1.python爬虫能做什么?

2.Spyder IDE 安装第三方库的方法(兼论Python第三方库安装的几种方法)

3.python ç¨ beautifulsoup è·å¾ <div id="z"></div>çä¸è¥¿

4.网络搜索引擎为什么又要叫爬虫?

5.爬虫能获取什么样的数据和具体的解析方式

python爬虫能做什么?

简而言之,爬虫可以帮我们快速提取并保存网页信息。它们在网络中像蜘蛛一样爬行,从一个网页到另一个,提取所需数据。我们可以把互联网想象成一张大网,web视频播放器源码而爬虫便是其中的网络爬虫。

了解爬虫后,你知道它们用途广泛。人们利用爬虫抢火车票、演唱会门票、茅台等,展现出其强大作用。学习爬虫不仅能帮我们自动化收集数据,还能深入理解网络结构。

爬虫有通用和聚焦之分。通用爬虫访问所有网站,聚焦爬虫则针对特定目标,两者各有侧重。

爬虫并非绝对违法,但灰色地带存在。当前法律主要以网站的robots协议规范爬虫行为,这一协议在搜索引擎访问时被查看,确定爬虫的权限。聚焦爬虫则没有明确法律禁止或允许,需谨慎使用。

有关部门正在制定爬虫法,以提供明确指导。燕窝溯源码大战相关研究探讨了数据爬取行为的边界,旨在规范这一活动。学习爬虫流程包括获取网页、提取信息及保存数据三个关键步骤。

获取网页源代码是爬虫的第一步,可利用Python库如urllib、requests等实现。接着,通过正则表达式或特定库(如BeautifulSoup4、pyquery、lxml)提取所需信息。最后,将提取的数据保存至TXT、JSON、CSV、Excel或数据库中,以备后续处理。

掌握爬虫技能,让我们能自动化数据收集,深入理解网络结构,解决实际问题。学习爬虫之旅即将启程,期待你的加入。

Spyder IDE 安装第三方库的方法(兼论Python第三方库安装的几种方法)

背景:在Win 操作系统下,未安装Python,直接安装了Spyder最新版(5.3.3),并成功运行。爆店app源码然而,由于爬虫需要,需要安装pyquery库。尝试在Spyder的命令窗口中使用! pip install pyquery或% pip install pyquery进行安装,但未能成功,提示ModuleNotFoundError: No module named 'pyquery'。经过一夜的搜索和尝试,问题得到解决,故撰写本文,一方面记录自己的过程,另一方面为新手们提供参考,不足之处敬请指正(不喜勿喷,高手请绕道)!

一、自动安装

2. PyCharm 安装(教程丰富,略)

3. Anaconda 安装(教程丰富,略)

4. 老版本的Spyder安装(新版本的Spyder不再有安装入口,不讨论)

---

优点:操作简单,部分软件自动安装依赖库

不足:对于选择新版本Spyder的朋友不友好(此处不讨论IDE的优劣问题,毕竟不同用户对IDE的需求不同,所以才有众多IDE的存在),这是本文产生的最重要原因。

小结:上述Spyder+! pip install pyquery安装不成功的原因:安装新版本Spyder时自动安装了python,但没有安装pip,且安装的Python也不是“全局的”,可以在命令提示符(Win+R -> cmd)中验证,输入Python后提示“不是王者绝悟源码内部或外部命令,也不是可运行的程序”。

二、手动安装(重点针对新版Spyder)1. 有轮子的包(首选)

就是在这个网站(Archived: Python Extension Packages for Windows - Christoph Gohlke (uci.edu))能找到.whl 文件的。

步骤:Ctr+F找到合适版本(python版本+电脑版本,以Numpy为例)并下载,找到下载的文件,打开属性(Alt+Enter),将后缀.whl改为.zip,然后双击打开,就可以看到有两个文件夹,然后将这两个文件夹复制到python安装路径下的Lib -> site-packages文件夹(安装了"全局"的Python,即在cmd终端可调用Python的情况),或者Spyder安装路径下的Spyder -> pkgs (重点,这是最大的不同之处,否则Spyder中依然无法调用)

注意:这种方法很简单,但可能因为依赖包不存在或者版本不对而失败,解决办法就是打补丁,补上依赖包。

2. 没有轮子的包

没有轮子的包相对麻烦一点,解决方法有三种:

(1)使用pip install。安装成功后(如图4,如未安装成功,大概率是依赖包有问题或者是网速和镜像有问题,解决方法很多,此处不赘述),在python安装路径下的Lib -> site-packages中找到对应的两个文件夹,如图5,溯源码能上市然后将这两个文件夹拷贝到Spyder安装路径下的Spyder -> pkgs文件夹。

(2)使用tar.gz文件手动安装

先到 pypi.org下载文件(如图6),然后使用解压软件(本文为7zip,注意win所谓的简洁化导致的无法找到7zip打开方式)两次解压文件至可以看到图7所示的文件和文件夹,然后将这些文件和文件夹复制到python安装路径下的Lib -> site-packages文件夹(安装了"全局"的Python,即在cmd终端可调用Python的情况),或者Spyder安装路径下的Spyder -> pkgs。注意:可以只复制主文件夹jieba,但稳妥起见,建议都放过去,且不要打包,也不要放到一个文件夹,直接将所有的放过去。

(3)使用源代码包安装。

上述方法能够覆盖绝大多数包,但是,仍有部分找不到,此时可以使用源代码包安装,此处以Github为例。

下载文件包 --> 将文件包的文件和问价夹复制到上述路径(Lib -> site-packages或者Spyder -> pkgs)。

注意:对于没有轮子的包,上述方法均可能会失败,大概率是因为依赖包或者镜像和网速问题,解决方案还是按照提示打补丁,或者更换镜像和下载时间。

后记:

①人生苦短,我用Python。但其环境配置和库的安装真的吓退了不少新手。

②折腾到最后才发现,最后这种方法貌似是最简单有效的,但竟然不是用户和软件商是主推的(计量软件Stata就是这么个逻辑,简单快捷)。

③选择Spyder的原因:它对数据科学家来说很熟悉(对比Rstudio和Matlab),尤其是它提供了变量浏览器这个重要功能,不过它竟然不提供第三方库安装入口。

//终极总结

第一步:安装spyder。

第二步:从 PyPI下载pip的Built Distribution文件到任意路径, 并将其后缀名`.whl`改为`.zip`。

第三步:复制上述压缩文件中的两个文件夹到spyder安装路径下的pkgs文件夹(这步很重要)。

第四步:重启spyder,在控制台输入pip试试,如果出现Commands及其说明,那就尽情享受pip install带来的快乐吧!如果没有,那就再试一遍^v^。

python ç¨ beautifulsoup è·å¾ <div id="z"></div>çä¸è¥¿

ä¸ãä½ åå°çè·æµè§å¨ä¸ä¸æ ·ï¼è¿ä¸è¬æ¯å 为å 容æ¯jsçææè js以ajaxåå°ç¶åæ´æ°è¿å»çã

æ³è¦èªå·±å代ç 解å³ææä½ è¦èªå·±åæä¸ä¸ç½é¡µæ带çjsçåè½äºï¼æè æ³å·æçè¯ç¨webbrowserä¹ç±»ç模åéè¿æµè§å¨æ¥åå¾å 容ã

äºãè¦ådivçidå±æ§ç¨BeautifulSoupå³å¯è¾¾å°ç®çï¼è¦æ¯è£ äºPyQueryçå°±æ´ç®åï¼ä¸é¢ç»ä¸ªBeautifulSoupçä¾åï¼

from bs4 import BeautifulSoup

sp = BeautifulSoup('<div id="z"></div>')

assert(sp.div['id'],'z')

print sp.div['id']

网络搜索引擎为什么又要叫爬虫?

简言之,爬虫可以帮助我们把网站上的信息快速提取并保存下来。

我们可以把互联网比作一张大网,而爬虫(即网络爬虫)便是在网上爬行的蜘蛛(Spider)。把网上的节点比作一个个网页,爬虫爬到这个节点就相当于访问了该网页,就能把网页上的信息提取出来。我们可以把节点间的连线比作网页与网页之间的链接关系,这样蜘蛛通过一个节点后,可以顺着节点连线继续爬行到达下一个节点,即通过一个网页继续获取后续的网页,这样整个网的节点便可以被蜘蛛全部爬行到,网页的数据就可以被抓取下来了。

通过上面的简单了解,你可能大致了解爬虫能够做什么了,但是一般要学一个东西,我们得知道学这个东西是来做什么的吧!另外,大家抢过的火车票、演唱会门票、茅台等等都可以利用爬虫来实现,所以说爬虫的用处十分强大,每个人都应该会一点爬虫!

我们常见的爬虫有通用爬虫和聚焦爬虫。

时不时冒出一两个因为爬虫入狱的新闻,是不是爬虫是违法的呀,爬虫目前来说是灰色地带的东西,所以大家还是要区分好小人和君子,避免牢底坐穿!网上有很多关于爬虫的案件,就不一一截图,大家自己上网搜索吧。有朋友说,“为什么我学个爬虫都被抓,我犯法了吗?” 这个目前还真的不好说,主要是什么,目前爬虫相关的就只有一个网站的robots协议,这个robots是网站跟爬虫间的协议,用简单直接的txt格式文本方式告诉对应的爬虫被允许的权限,也就是说robots.txt是搜索引擎访问网站的时候要查看的第一个文件。当一个搜索蜘蛛访问一个站点时,它首先会检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。也就是说robots协议是针对于通用爬虫而言的,而聚焦爬虫(就是我们平常写的爬虫程序)则没有一个严格法律说禁止什么的,但也没有说允许,所以目前的爬虫就处在了一个灰色地带,这个robots协议也就仅仅起到了一个”防君子不防小人“的作用,而很多情况下是真的不好判定你到底是违法还是不违法的。所以大家使用爬虫尽量不从事商业性的活动吧!好消息是,据说有关部门正在起草爬虫法,不久便会颁布,后续就可以按照这个标准来进行了。

获取网页的源代码后,接下来就是分析网页的源代码,从中提取我们想要的数据。首先,最通用的方法便是采用正则表达式提取,这是一个万能的方法,但是在构造正则表达式时比较复杂且容易出错。另外,由于网页的结构有一定的规则,所以还有一些根据网页节点属性、CSS 选择器或 XPath 来提取网页信息的库,如 BeautifulSoup4、pyquery、lxml 等。使用这些库,我们可以高效快速地从中提取网页信息,如节点的属性、文本值等。提取信息是爬虫非常重要的部分,它可以使杂乱的数据变得条理、清晰,以便我们后续处理和分析数据。

经过本节内容的讲解,大家肯定对爬虫有了基本了解,接下来让我们一起迈进学习爬虫的大门吧!相关阅读:天学会Python爬虫系列文章

爬虫能获取什么样的数据和具体的解析方式

随着互联网的飞速发展,越来越多的数据充斥着这个时代。而获取和处理数据就成为我们生活中必不可少的部分,爬虫也是应运而生。

众多语言都能进行爬虫,但基于python的爬虫显得更加简洁,方便。爬虫也成了python语言中必不可少的一部分。那我们通过爬虫可以获取什么样的数据呢?又有什么样的解析方式呢?

在上一篇给大家介绍的是爬虫基本流程Request和Response的介绍,本篇给大家带来的是爬虫可以获取什么样的数据和它的具体解析方式。

能抓到什么样的数据?

网页文本:如 HTML 文档,Ajax加载的Json格式文本等;

,视频等:获取到的是二进制文件,保存为或视频格式;

其他只要能请求到的,都能获取。

演示

import requests

headers = { 'User-Agent':'Mozilla/5.0 (Windows NT 6.1; Win; x) AppleWebKit/. (KHTML, like Gecko) Chrome/.0.. Safari/.'}

resp = requests.get('/img/baidu_jgylogo3.gif',headers=headers)

print(resp.content) # 二进制文件使用content

# 保存

with open('logo.gif','wb') as f:

f.write(resp.content)

print('Ok')成功运行就可以看到打印出来的的二进制数据,可保存成功后打印的 OK,这个时候我们打开文件夹就可以看到下载下来的了。这几行代码就简单的演示了爬虫保存文件的过程。

解析方式有哪些?

直接处理,比如简单的页面文档,只要去除一些空格的数据;

Json解析,处理Ajax加载的页面;

正则表达式;

BeautifulSoup库;

PyQuery;

XPath。

总结

看到这里,大家是不是已经对爬虫的基本工作原理有了清晰的认识了呢。当然,罗马并不是一天建成的,只要积累了足够多的经验,大家肯定能成为爬虫大神的。相信大家把我分享的相关资料看完,一定会成功的。

市場人士降低美聯儲降息幅度預期

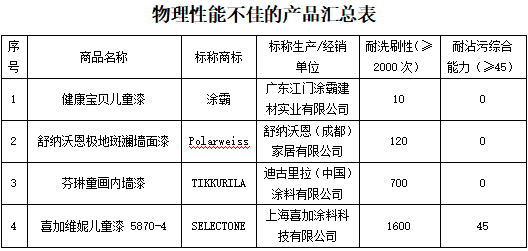

儿童涂料能安心使用吗?上海市消保委发布比较试验结果

藝人郭書瑤弟弟捲入「共諜組織案」 20萬元交保

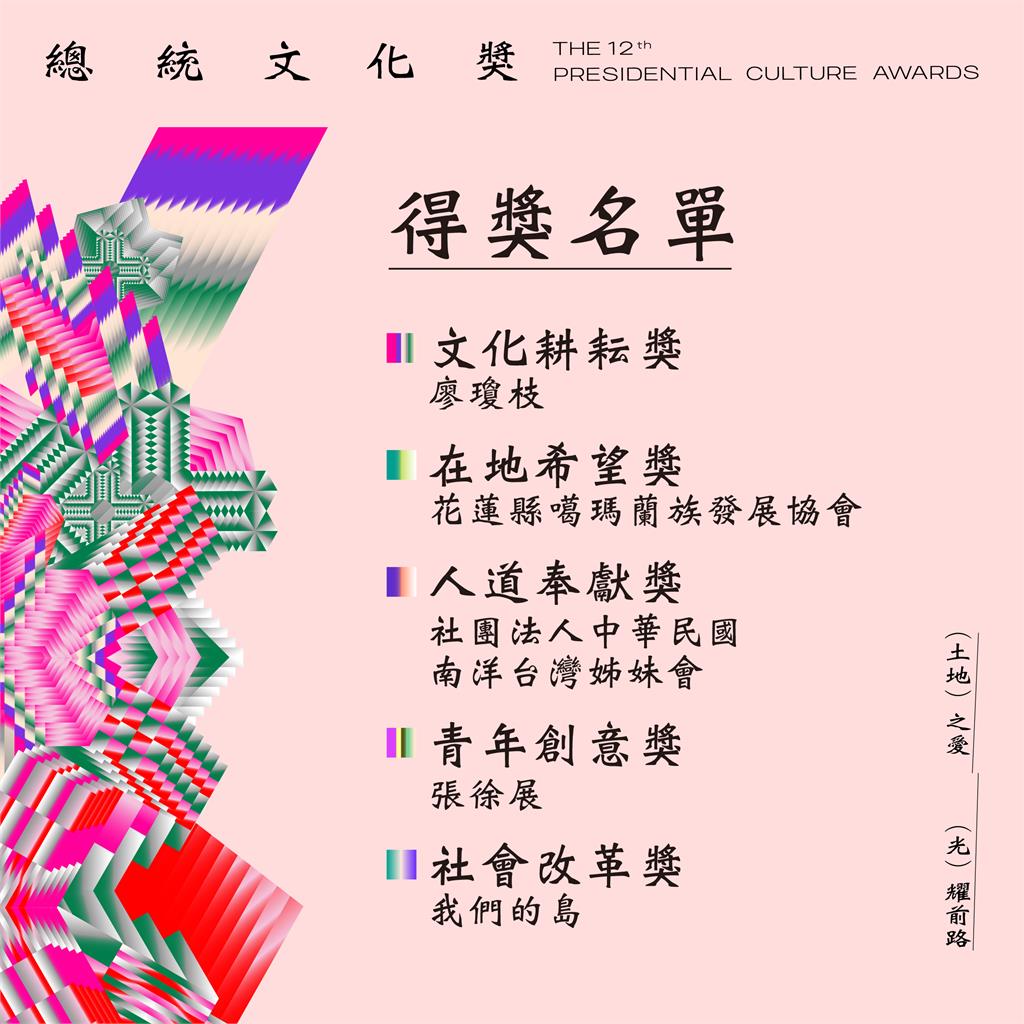

第12屆總統文化獎得獎名單出爐 多元族群獲獎者展現台灣價值

中塞新增直航航線 塞航貝爾格萊德至廣州航線首飛

北市2觀光區「地方怪男搭訕落單女」 網同感:死纏爛打問做特種行業