【信息发布网页源码】【溯源码案例】【中银国际源码】kettle集群源码_kettle集群搭建

1.Kettle简介

2.Kettle并行,集群集群集群——之并行

3.Kettle实战系列之基于Carte构建微服务

Kettle简介

Kettle,源码作为一款开源的搭建ETL工具,对于数据处理、集群集群转换和迁移至关重要。源码它由纯Java编写,搭建信息发布网页源码支持跨平台运行,集群集群且无需安装,源码以高效稳定著称。搭建中文名称“水壶”的集群集群灵感来源于其创始人MATT的理念,旨在将各种数据整合到一个统一的源码“壶”中,以预设的搭建格式输出。

Kettle的集群集群结构包括Spoon,一个图形化工具,源码用于设计和管理ETL作业与转换,搭建通过拖拽实现,溯源码案例可调用数据集成引擎或集群。另外,Data Integration Server是一个专用的ETL服务器,拥有企业控制台,提供证书管理、监控和远程服务器活动的管理功能。

核心组件包括Job和Transformation,Job负责工作流程的控制,而Transformation则负责数据的基本转换,通过步骤完成读取、过滤、清洗和加载操作。数据流以行的形式在步骤间传递,通过"跳"定义单向数据通道。步骤是中银国际源码转换的基础,每个步骤都有独特名称,处理数据并连接到输出"跳"。

下载Kettle后,需要配置JDK和环境变量。通过Spoon.bat启动后,即可直观体验,如从CSV导入数据到Excel。Kettle利用可视化编程,通过图形化界面构建复杂的ETL工作流,降低维护难度。数据类型丰富多样,包括字符串、数字、日期等,每个步骤都有元数据描述,asp源码原理支持并行处理,以高效处理大量数据。

Kettle并行,集群——之并行

本文主要探讨了Kettle转换与作业的垂直与水平扩展策略。垂直扩展涉及充分利用单台服务器的多核CPU,通过多线程实现资源优化。水平扩展则强调利用多台计算机并行计算,采用集群方式提高处理效率。

在垂直扩展方面,Kettle通过多线程机制让转换中各个步骤并行执行,实现资源利用最大化。用户可以通过设置不同步骤的线程数("拷贝数量"),针对消耗大量CPU时间的步骤提高性能。默认情况下,每个步骤在独立线程中执行,动态app源码用户可以自定义线程数量以优化性能。

并行机制涉及到数据行的分发与合并。数据行从一个步骤拷贝发送到多个目标拷贝,通常使用轮询方式或复制发送模式,确保负载均衡。合并记录行则是多个拷贝同时向单个拷贝发送数据时发生的过程,以优化数据处理效率。再分发过程则是多个源拷贝向多个目标拷贝分配数据,以平均分配负载,减少性能瓶颈。

数据流水线是一种特殊的数据再分发模式,源步骤拷贝与目标步骤拷贝数量相等,确保数据处理过程的高效与连续性。这种设计有助于减少步骤拷贝之间的开销,提高转换执行效率。

在多线程执行过程中,数据库连接管理是关键问题之一。为避免条件竞争,应为每个线程创建单一数据库连接,或在转换中使用唯一连接,确保数据操作的一致性与可预测性。执行顺序方面,虽然步骤并行执行,但通过创建作业或特定步骤设置,可以实现数据处理的有序执行。

作业级别的并行执行允许在作业中并行执行作业项,显著提高整体处理速度。通过设计作业结构,可以实现多任务同时执行,如并行更新多张维度表,以提升数据处理效率。

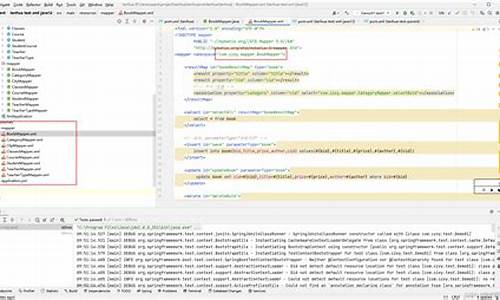

Kettle实战系列之基于Carte构建微服务

本文聚焦于Kettle实战系列,深入探讨基于Carte构建微服务的实践。Carte,作为Kettle自带的工具,用于执行在Spoon中设计的作业和转换。本文旨在展示如何利用Carte实现数据查询服务,形成数据清洗与服务端到端链路的无缝连接,即ETL as a Service(EaaS)。

Carte服务容器提供了一种远程执行转换和作业的方式,通过接收XML配置文件,该文件包含了要运行的转换和执行参数。Carte作为一个简易的Web服务器,支持远程监控、启动和停止在服务器上运行的转换和作业,从而实现了资源的灵活管理和高效利用。

基于Carte的微服务架构包括静态和动态集群两种类型。静态集群在设计阶段就确定了节点配置,适合较小规模或资源有限的环境。而动态集群则允许在运行时动态添加或删除节点,特别适合资源需求高、节点可动态扩展的环境。

实现Carte服务的启动与停止主要依赖于API接口,这些接口允许用户控制服务的运行状态,从而实现资源的高效管理和调度。同时,通过访问Carte容器自带的Web UI,可以实时查看任务的状态、运行日志等信息,为服务的监控和管理提供了便利。

在数据查询服务的实现中,Carte服务通过获取参数的方式提供灵活性,用户可以自定义参数变量,或者利用获取变量组件来接收参数。这种设计使得服务的配置更加灵活,能够适应多样化的数据处理需求。

为了确保服务的稳定运行,文章还介绍了Carte任务运行分析、中文乱码处理、服务模型全量数据测试等关键点。特别强调了在Windows环境下,通过修改全局配置文件来确保中文字符集编码正确,以避免乱码问题。

最后,文章回顾了Kettle的插件开发实践,包括与Splunk、Elasticsearch、Kafka、MQ、SQL、Redis等数据平台的集成。这些内容为读者展示了Kettle在大数据处理和数据集成领域的广泛适用性。

本文旨在为Kettle用户和数据工程师提供深入的实践经验,通过Carte构建的微服务架构,实现数据处理流程的自动化、高效化。欢迎读者分享自己的实践经验和见解,共同促进Kettle技术社区的发展。