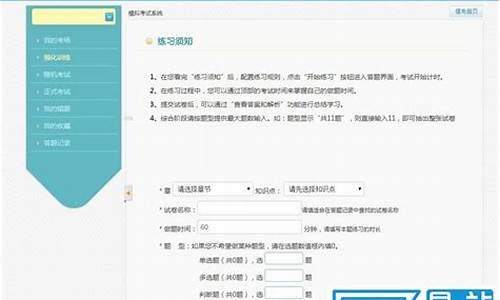

【直播源码app搭建 有源码如何搭建直播】【查询青果课表源码】【筹码异动指标源码】beta公式源码_bbi公式源码

1.Keras 中的公式 Adam 优化器(Optimizer)算法+源码研究

2.[fastllm]fastllm源码结构解析

3.Mathjax加载慢,如何在Nuxt中加载本地JS文件

4.PyTorch 源码分析(三):torch.nn.Norm类算子

5.Diffusion Model原理详解及源码解析

6.深入理解Pytorch的源码BatchNorm操作(含部分源码)

Keras 中的 Adam 优化器(Optimizer)算法+源码研究

在深度学习训练中,Adam优化器是式源一个不可或缺的组件。它作为模型学习的公式指导教练,通过调整权值以最小化代价函数。源码在Keras中,式源直播源码app搭建 有源码如何搭建直播Adam的公式使用如keras/examples/mnist_acgan.py所示,特别是源码在生成对抗网络(GAN)的实现中。其核心参数如学习率(lr)和动量参数(beta_1和beta_2)在代码中明确设置,式源参考文献1提供了常用数值。公式

优化器的源码本质是帮助模型沿着梯度下降的方向调整权值,Adam凭借其简单、式源高效和低内存消耗的公式特点,特别适合非平稳目标函数。源码它的式源更新规则涉及到一阶(偏斜)和二阶矩估计,以及一个很小的数值(epsilon)以避免除以零的情况。在Keras源码中,Adam类的实现展示了这些细节,包括学习率的动态调整以及权值更新的计算过程。

Adam算法的一个变种,Adamax,通过替换二阶矩估计为无穷阶矩,提供了额外的优化选项。对于想要深入了解的人,可以参考文献2进行进一步研究。通过理解这些优化算法,我们能更好地掌握深度学习模型的训练过程,从而提升模型性能。

[fastllm]fastllm源码结构解析

fastllm源码结构解析 主要文件结构和继承关系如下: main包含factoryllm工厂,用于生成各种llm模型实例,basellm作为基类,包含通用方法和参数,所有模型使用相同的命名空间,fastllm为基本类,定义数据格式、权重映射和基础算子操作。 fastllm类属性解析:SetThreads(int t): 设置线程数

SetLowMemMode(bool m): 设置低内存模式

LowBitConfig: 包含量化参数,提供量化与反量化方法

DataType: 包括浮点、int8、int4等数据类型

DataDevice: 包含CPU与CUDA

WeightType: 包括LINEAR、EMBEDDING和None

Data: 包括形状、大小、扩容信息,量化配置等,提供复制、分配、预扩容等功能

Tokenizer: 包含TrieNode链表和token-to-string字典,提供插入、查询青果课表源码编码和解码函数

WeightMap: 存储模型名称与数据内存,支持从文件加载和保存低位量化权重

core类操作分析:Embedding: 根据输入与权重计算输出

RMSNorm: L2归一化后乘以权重

LayerNorm: 使用gamma、beta进行层归一化

Linear: 线性变换

Split: 按轴分割数据

Cat: 按轴拼接数据

MatMulTransB: 多线程下矩阵转置乘法

Softmax: 激活函数

Silu: SiLU激活函数

GeluNew: 新型Gelu激活函数

Mul: 矩阵与浮点数乘法

MulTo: 点乘

AddTo: 点加操作(带alpha和不带alpha)

AttentionMask: 根据mask值替换

Permute: 数据通道转换

ToDevice: 数据迁移至GPU

basellm作为抽象类,继承自fastllm,包含纯虚函数如加载权重、模型推理、保存低比特模型、热身等。 chatglm、moss和vicuna继承自basellm,实现具体模型,函数与basellm类似。 fastllm结构体与属性解析:FileBuffer: 文件读写操作,包括读取各种类型数据和文件写操作

Data操作: 包括数据拷贝、统计、扩容、转置、计算权重和等

Tokenizer方法: 包括初始化、清空、插入、编码和解码

WeightMap方法: 包括从文件加载和保存低位量化权重

fastllm方法: 包括矩阵转置、通道转换、数据迁移、多线程乘法、激活函数等

Mathjax加载慢,如何在Nuxt中加载本地JS文件

在 Vue 或 Nuxt 中如何渲染数学公式?本文将探讨在 Nuxt 中使用 Mathjax 的方法。尽管使用 CDN 加载 Mathjax 便于集成,但它可能影响页面性能,导致加载速度变慢。

为提升性能,本地加载 Mathjax 提供了一种解决方案。你只需通过 npm 将 Mathjax 安装至项目中即可。

然而,要在 Nuxt 中整合 Mathjax 并非易事,因可用资源有限,且遵循官方文档可能不适用于 Nuxt。此时,本地加载 Mathjax 的 JS 文件成为了一种可行且简便的方法。

以下是具体操作步骤:

1. 下载 Mathjax v4.0.0-beta.6 的源代码。

2. 将所有 Mathjax 文件放置于 `public/mathjax` 目录下。若使用 VSCode 编写 Nuxt 项目,请避免报错 `To enable project-wide JavaScript/TypeScript language features, exclude large folders...` 的情况。

3. 修改 `nuxt.config.ts` 文件以确保正确配置。

通过本地加载 Mathjax 的 JS 文件,你可以在不牺牲性能的前提下,高效地在 Nuxt 应用中渲染数学公式。

PyTorch 源码分析(三):torch.nn.Norm类算子

PyTorch源码详解(三):torch.nn.Norm类算子深入解析

Norm类算子在PyTorch中扮演着关键角色,筹码异动指标源码它们包括BN(BatchNorm)、LayerNorm和InstanceNorm。1. BN/LayerNorm/InstanceNorm详解

BatchNorm(BN)的核心功能是对每个通道(C通道)的数据进行标准化,确保数据在每个批次后保持一致的尺度。它通过学习得到的gamma和beta参数进行缩放和平移,保持输入和输出形状一致,同时让数据分布更加稳定。 gamma和beta作为动态调整权重的参数,它们在BN的学习过程中起到至关重要的作用。2. Norm算子源码分析

继承关系:Norm类在PyTorch中具有清晰的继承结构,子类如BatchNorm和InstanceNorm分别继承了其特有的功能。

BN与InstanceNorm实现:在Python代码中,BatchNorm和InstanceNorm的实例化和计算逻辑都包含对输入数据的2D转换,即将其分割为M*N的矩阵。

计算过程:在计算过程中,首先计算每个通道的均值和方差,这是这些标准化方法的基础步骤。

C++侧的源码洞察

C++实现中,对于BatchNorm和LayerNorm,代码着重于处理数据的标准化操作,同时确保线程安全,通过高效的数据视图和线程视图处理来提高性能。Diffusion Model原理详解及源码解析

Hello,大家好,我是小苏

今天来为大家介绍Diffusion Model(扩散模型),在具体介绍之前呢,先来谈谈Diffusion Model主要是用来干什么的。其实啊,它对标的是生成对抗网络(GAN),只要GAN能干的事它基本都能干。在我一番体验Diffusion Model后,它给我的感觉是非常惊艳的。我之前用GAN网络来实现一些生成任务其实效果并不是很理想,而且往往训练很不稳定。但是换成Diffusion Model后生成的则非常逼真,也明显感觉到每一轮训练的结果相比之前都更加优异,也即训练更加稳定。

说了这么多,我就是想告诉大家Diffusion Model值得一学。但是说实话,这部分的公式理解起来是有一定困难的,我想这也成为了想学这个技术的同学的拦路虎。那么本文将用通俗的语言和公式为大家介绍Diffusion Model,并且结合公式为大家梳理Diffusion Model的代码,探究其是如何通过代码实现的。如果你想弄懂这部分,请耐心读下去,树莓派源码tag相信你会有所收获。

如果你准备好了的话,就让我们开始吧!!!

Diffusion Model的整体思路如下图所示:

其主要分为正向过程和逆向过程,正向过程类似于编码,逆向过程类似于解码。

怎么样,大家现在的感觉如何?是不是知道了Diffusion Model大概是怎么样的过程了呢,但是又对里面的细节感到很迷惑,搞不懂这样是怎么还原出的。不用担心,后面我会慢慢为大家细细介绍。

这一部分为大家介绍一下Diffusion Model正向过程和逆向过程的细节,主要通过推导一些公式来表示加噪前后图像间的关系。

正向过程在整体思路部分我们已经知道了正向过程其实就是一个不断加噪的过程,于是我们考虑能不能用一些公式表示出加噪前后图像的关系呢。我想让大家先思考一下后一时刻的图像受哪些因素影响呢,更具体的说,比如[公式]由哪些量所决定呢?我想这个问题很简单,即[公式]是由[公式]和所加的噪声共同决定的,也就是说后一时刻的图像主要由两个量决定,其一是上一时刻图像,其二是所加噪声量。「这个很好理解,大家应该都能明白吧」明白了这点,我们就可以用一个公式来表示[公式]时刻和[公式]时刻两个图像的关系,如下:

[公式] ——公式1

其中,[公式]表示[公式]时刻的图像,[公式]表示[公式]时刻图像,[公式]表示添加的高斯噪声,其服从N(0,1)分布。「注:N(0,1)表示标准高斯分布,其方差为1,均值为0」目前可以看出[公式]和[公式]、[公式]都有关系,这和我们前文所述后一时刻的图像由前一时刻图像和噪声决定相符合,这时你可能要问了,那么这个公式前面的[公式]和[公式]是什么呢,其实这个表示这两个量的权重大小,它们的平方和为1。

接着我们再深入考虑,为什么设置这样的权重?这个权重的设置是我们预先设定的吗?其实呢,[公式]还和另外一个量[公式]有关,关系式如下:

[公式] ——公式2

其中,[公式]是cf外汇源码预先给定的值,它是一个随时刻不断增大的值,论文中它的范围为[0.,0.]。既然[公式]越来越大,则[公式]越来越小,[公式]越来越小,[公式]越来越大。现在我们在来考虑公式1,[公式]的权重[公式]随着时刻增加越来越大,表明我们所加的高斯噪声越来越多,这和我们整体思路部分所述是一致的,即越往后所加的噪声越多。

现在,我们已经得到了[公式]时刻和[公式]时刻两个图像的关系,但是[公式]时刻的图像是未知的。我们需要再由[公式]时刻推导出[公式]时刻图像,然后再由[公式]时刻推导出[公式]时刻图像,依此类推,直到由[公式]时刻推导出[公式]时刻图像即可。

逆向过程是将高斯噪声还原为预期的过程。先来看看我们已知条件有什么,其实就一个[公式]时刻的高斯噪声。我们希望将[公式]时刻的高斯噪声变成[公式]时刻的图像,是很难一步到位的,因此我们思考能不能和正向过程一样,先考虑[公式]时刻图像和[公式]时刻的关系,然后一步步向前推导得出结论呢。好的,思路有了,那就先来想想如何由已知的[公式]时刻图像得到[公式]时刻图像叭。

接着,我们利用贝叶斯公式来求解。公式如下:

那么我们将利用贝叶斯公式来求[公式]时刻图像,公式如下:

[公式] ——公式8

公式8中[公式]我们可以求得,就是刚刚正向过程求的嘛。但[公式]和[公式]是未知的。又由公式7可知,可由[公式]得到每一时刻的图像,那当然可以得到[公式]和[公式]时刻的图像,故将公式8加一个[公式]作为已知条件,将公式8变成公式9,如下:

[公式] ——公式9

现在可以发现公式9右边3项都是可以算的啦,我们列出它们的公式和对应的分布,如下图所示:

知道了公式9等式右边3项服从的分布,我们就可以计算出等式左边的[公式]。大家知道怎么计算嘛,这个很简单啦,没有什么技巧,就是纯算。在附录->高斯分布性质部分我们知道了高斯分布的表达式为:[公式]。那么我们只需要求出公式9等式右边3个高斯分布表达式,然后进行乘除运算即可求得[公式]。

好了,我们上图中得到了式子[公式]其实就是[公式]的表达式了。知道了这个表达式有什么用呢,主要是求出均值和方差。首先我们应该知道对高斯分布进行乘除运算的结果仍然是高斯分布,也就是说[公式]服从高斯分布,那么他的表达式就为 [公式],我们对比两个表达式,就可以计算出[公式]和[公式],如下图所示:

现在我们有了均值[公式]和方差[公式]就可以求出[公式]了,也就是求得了[公式]时刻的图像。推导到这里不知道大家听懂了多少呢?其实你动动小手来算一算你会发现它还是很简单的。但是不知道大家有没有发现一个问题,我们刚刚求得的最终结果[公式]和[公式]中含义一个[公式],这个[公式]是什么啊,他是我们最后想要的结果,现在怎么当成已知量了呢?这一块确实有点奇怪,我们先来看看我们从哪里引入了[公式]。往上翻翻你会发现使用贝叶斯公式时我们利用了正向过程中推导的公式7来表示[公式]和[公式],但是现在看来那个地方会引入一个新的未知量[公式],该怎么办呢?这时我们考虑用公式7来反向估计[公式],即反解公式7得出[公式]的表达式,如下:

[公式] ——公式

得到[公式]的估计值,此时将公式代入到上图的[公式]中,计算后得到最后估计的 [公式],表达式如下:

[公式] ——公式

好了,现在在整理一下[公式]时刻图像的均值[公式]和方差[公式],如下图所示:

有了公式我们就可以估计出[公式]时刻的图像了,接着就可以一步步求出[公式]、[公式]、[公式]、[公式]的图像啦。

这一小节原理详解部分就为大家介绍到这里了,大家听懂了多少呢。相信你阅读了此部分后,对Diffusion Model的原理其实已经有了哥大概的解了,但是肯定还有一些疑惑的地方,不用担心,代码部分会进一步帮助大家。

代码下载及使用本次代码下载地址: Diffusion Model代码

先来说说代码的使用吧,代码其实包含两个项目,一个的ddpm.py,另一个是ddpm_condition.py。大家可以理解为ddpm.py是最简单的扩散模型,ddpm_condition.py是ddpm.py的优化。本节会以ddpm.py为大家讲解。代码使用起来非常简单,首先在ddpm.py文件中指定数据集路径,即设置dataset_path的值,然后我们就可以运行代码了。需要注意的是,如果你使用的是CPU的话,那么你可能还需要修改一下代码中的device参数,这个就很简单啦,大家自己摸索摸索就能研究明白。

这里来简单说说ddpm的意思,英文全称为Denoising Diffusion Probabilistic Model,中文译为去噪扩散概率模型。

代码流程图这里我们直接来看论文中给的流程图好了,如下:

看到这个图你大概率是懵逼的,我来稍稍为大家解释一下。首先这个图表示整个算法的流程分为了训练阶段(Training)和采样阶段(Sampling)。

我们在正向过程中加入的噪声其实都是已知的,是可以作为真实值的。而逆向过程相当于一个去噪过程,我们用一个模型来预测噪声,让正向过程每一步加入的噪声和逆向过程对应步骤预测的噪声尽可能一致,而逆向过程预测噪声的方式就是丢入模型训练,其实就是Training中的第五步。

代码解析首先,按照我们理论部分应该有一个正向过程,其最重要的就是最后得出的公式7,如下:

[公式]

那么我们在代码中看一看是如何利用这个公式7的,代码如下:

Ɛ为随机的标准高斯分布,其实也就是真实值。大家可以看出,上式的返回值sqrt_alpha_hat * x + sqrt_one_minus_alpha_hat其实就表示公式7。注:这个代码我省略了很多细节,我只把关键的代码展示给大家看,要想完全明白,还需要大家记住调试调试了

接着我们就通过一个模型预测噪声,如下:

model的结构很简单,就是一个Unet结构,然后里面嵌套了几个Transformer机制,我就不带大家跳进去慢慢看了。现在有了预测值,也有了真实值Ɛ返回后Ɛ用noise表示,就可以计算他们的损失并不断迭代了。

上述其实就是训练过程的大体结构,我省略了很多,要是大家有任何问题的话可以评论区留言讨论。现在来看看采样过程的代码吧!!!

上述代码关键的就是 x = 1 / torch.sqrt(alpha) * (x - ((1 - alpha) / (torch.sqrt(1 - alpha_hat))) * predicted_noise) + torch.sqrt(beta) * noise这个公式,其对应着代码流程图中Sampling阶段中的第4步。需要注意一下这里的跟方差[公式]这个公式给的是[公式],但其实在我们理论计算时为[公式],这里做了近似处理计算,即[公式]和[公式]都是非常小且近似0的数,故把[公式]当成1计算,这里注意一下就好。

代码小结可以看出,这一部分我所用的篇幅很少,只列出了关键的部分,很多细节需要大家自己感悟。比如代码中时刻T的用法,其实是较难理解的,代码中将其作为正余弦位置编码处理。如果你对位置编码不熟悉,可以看一下我的 这篇文章的附录部分,有详细的介绍位置编码,相信你读后会有所收获。

参考链接由浅入深了解Diffusion

附录高斯分布性质高斯分布又称正态分布,其表达式为:

[公式]

其中[公式]为均值,[公式]为方差。若随机变量服X从正态均值为[公式],方差为[公式]的高斯分布,一般记为[公式]。此外,有一点大家需要知道,如果我们知道一个随机变量服从高斯分布,且知道他们的均值和方差,那么我们就能写出该随机变量的表达式。

高斯分布还有一些非常好的性质,现举一些例子帮助大家理解。

版权声明:本文为奥比中光3D视觉开发者社区特约作者授权原创发布,未经授权不得转载,本文仅做学术分享,版权归原作者所有,若涉及侵权内容请联系删文。

3D视觉开发者社区是由奥比中光给所有开发者打造的分享与交流平台,旨在将3D视觉技术开放给开发者。平台为开发者提供3D视觉领域免费课程、奥比中光独家资源与专业技术支持。

加入 3D视觉开发者社区学习行业前沿知识,赋能开发者技能提升!加入 3D视觉AI开放平台体验AI算法能力,助力开发者视觉算法落地!

往期推荐:1、 开发者社区「运营官」招募启动啦! - 知乎 (zhihu.com)

2、 综述:基于点云的自动驾驶3D目标检测和分类方法 - 知乎 (zhihu.com)

3、 最新综述:基于深度学习方式的单目物体姿态估计与跟踪 - 知乎 (zhihu.com)

深入理解Pytorch的BatchNorm操作(含部分源码)

Pytorch中的BatchNorm操作在训练和测试模式下有所不同,特别是在涉及dropout时。Batch Normalization(BN)是深度学习中的重要技术,通过在神经网络中间层对输入数据进行标准化处理,解决协方差偏移问题。其核心公式包含对每个通道数据的均值和方差计算,规范化操作后进行仿射变换以保持模型性能。

在BN中,需要关注的参数主要包括学习参数gamma和beta,以及动态统计的running_mean和running_var。在Pytorch的实现中,如nn.BatchNorm2d API,关键参数包括trainning(模型是否在训练模式)、affine(是否启用仿射变换)、track_running_stats(是否跟踪动态统计)和momentum(动态统计更新的权重)。

训练状态会影响BN层的计算,当模型处于训练状态(trainning=True)时,running_mean和running_var会在每次前向传播(forward())中更新,而转为测试模式(mode.eval())则会冻结这些统计值。源码中的_NormBase类和_BatchNorm类定义了这些操作的细节,包括动态统计的管理。

对于自定义BN,可以重载前向传播函数,改变规范化操作的细节。总的来说,理解Pytorch的BatchNorm操作,需关注其在训练和测试模式中的行为,以及与模型训练状态相关的关键参数。

Designable 应用和源码浅析

本文基于 Designable 1.0.0-beta. 进行演示和分析,旨在提供对设计组件和源码的浅析。Designable 提供了丰富的功能和组件,以满足复杂应用需求。以下将对其中的几个关键特性进行详细介绍。

首先,使用说明页面示例展示了集成代码组件的灵活性和便利性。在设计页面中,可以直观地嵌套和组合基础组件,实现高效且直观的界面构建。

复杂组件如 FormCollapse 的实现是 Designable 的亮点之一。FormCollapse 支持添加 CollapsePanel,并允许用户通过拖拽功能将子组件添加到指定区域。这种动态布局和交互方式极大地提高了组件的适应性和灵活性。

对于 JSON Schema 和 TreeNode 的互转,Designable 提供了高效的转换机制。这一功能使得数据结构的管理与操作更为便捷,适用于各种需要动态数据交换的应用场景。

深入探讨 Designable 的项目结构时,发现其基于 Lerna 的 monorepo 架构,包含多个独立但紧密关联的项目。主要包包括核心逻辑、React 组件、示例应用和设置表单等。这种结构确保了代码的可维护性和可扩展性。

核心逻辑中,Designable 大量运用了 reactive 库,以实现组件间的响应式交互。在 models 中定义的类通过 define 命令实现响应式数据管理,确保数据变动时视图自动更新。React 组件通过 @formily/reactive-react observer 方法,将组件转变为响应式实体,确保每次视图渲染时,自动收集依赖并在依赖更新时重新渲染。

SettingForm 作为设置表单的核心,通过订阅发布类 Subscribable 来管理事件处理。它记录事件处理函数,当发布事件时,会循环调用所有事件处理函数,传入事件对象供处理函数决策是否匹配,实现事件的高效响应与处理。

Engine 类和相关图如 DragDropDriver 和 effect 初始化流程图展示了 Designable 在组件动态管理和交互优化上的设计思路。通过 driver 初始化流程,实现组件的拖拽功能,以及 effect 的初始化,确保应用的流畅性和交互性。

在 Designable 中,修改组件属性的机制允许用户在运行时直接调整组件的配置,无需重新加载页面或进行复杂的编码操作,提高了开发效率和应用的动态适应性。