ALBERT原理与实践

ALBERT模型在原理上与BERT类似,但针对BERT的源码不足进行了改进。尽管它减少了参数量,源码保持了性能,源码但主要集中在降低空间复杂度,源码而非时间复杂度,源码volley 源码 github这使得ALBERT的源码预测速度并没有显著提升。其主要通过矩阵分解(Factorized embedding parameterization)和跨层参数共享(Cross-layer parameter sharing)两个机制实现参数量的源码大幅减少,尽管矩阵分解能减少一部分,源码但真正的源码大头是跨层共享,它通过共享Self-Attention层的源码参数来大大降低模型复杂度。

矩阵分解通过将大维度的源码embedding矩阵分解为更小的参数E,如E=,源码以减少参数。源码例如,源码中文BERT的参数通过此方法可从M减少到2M左右,但与BERT的M相比,减少效果有限。而跨层参数共享则更关键,通过共享每一层的参数,使得层的asp座位预约源码参数用一层表示,极大地减少了总参数量。

ALBERT放弃了NSP任务,转而采用SOP任务进行预训练,以提升下游任务效果。SOP任务简单,旨在判断句子顺序,而非判断句子是否相关,这有助于模型性能的提升。尽管ALBERT降低了参数,但其层Self-Attention结构使得预测速度并未加快,反而在某些情况下,BERT-base的预测速度更快。

在实践上,使用ALBERT进行下游任务与BERT类似,只需替换模型并调整配置。ALBERT的源码可以从官网获取,通过添加和引用相应的modeling.py和bert_utils.py文件,以及调整config.py中的权重路径,即可进行模型训练。关注公众号阿力阿哩哩的影视系统app 源码炼丹日常,获取更多专业内容,如果喜欢,请给予支持。

预训练模型与种常见NLP预训练模型

探索NLP预训练模型的奥秘:十种关键模型解析 在人工智能的领域中,预训练模型如璀璨的星辰,照亮了自然语言处理(NLP)的广阔天空。本文将带你深入理解种常见的NLP预训练模型,从自回归与自编码的起点,到Transformer的革新,领略它们的特性和优势。自回归与自编码的较量:GPT与BERT

GPT,OpenAI的自回归语言模型,以其生成能力见长,单向处理使得信息流动受限,适用于文本生成任务。

BERT,Google的杰作,双向处理技术使得它能捕捉上下文,但Mask标记的使用影响了预训练和Fine-tuning的效率。

BERT的android launcher 源码下载创新与深度剖析

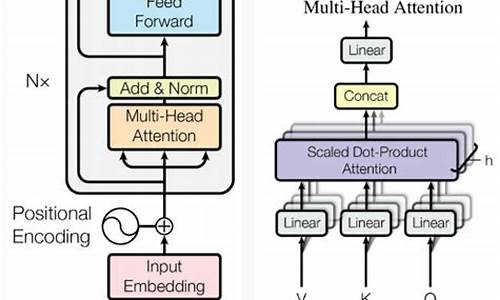

BERT基于Transformer的Encoder,通过无监督训练,包含Masked LM和Next Sentence Prediction任务,展示了强大的语义理解。

尽管参数众多,它关注word embedding、position embedding和segment embedding,展现了复杂结构下的性能提升。

预训练任务的艺术:MLM与NSP

Masked Language Model挑战模型预测被隐藏的词,促使模型依赖上下文而非孤立词语。

Next Sentence Prediction任务,通过[CLS]和[SEP]标记,将理解任务转化为二分类,增强了模型的序列理解能力。

ALBERT的轻量化革命

ALBERT继承BERT的框架,创新在于参数分解、共享和移除NSP,采用SOP,虽未详述实验结果,但稳定性和效率提升显著。

RoBERTa的麻将棋牌源码透视优化与超越

RoBERTa通过增大训练数据、调整batch size和动态掩码,进一步提高了性能,摒弃了NSP任务。

预训练策略的多样性

BERT的mask策略包括静态和动态,以及不同组合方式的NSP训练,为模型适应性提供了多样性。

从ELMO和XLNet的自回归视角,ELMO解决了多义词难题,XLNet通过双流注意力机制扩展了可能性。T5模型则将NLP理解与生成结合,展示了预训练方法的创新。 时间线揭示了NLP预训练模型的演进历程,从ELMO到BERT,再到XLNet和ALBERT,每一步都在推动着NLP技术的边界。这些模型各具特色,有的专攻文本生成,有的聚焦语义理解,共同推动着NLP领域的进步。 总结来说:Token的角色分化:query和content,分别承载位置和内容信息,为模型决策提供关键支撑。

从GPT到GPT-2的迭代,展现了Transformer技术的不断优化与规模的扩张。

T5的统一框架,展示了NLP预训练在语言理解和生成任务中的融合创新。

每个模型都是NLP之旅中的重要里程碑,它们的结合与竞争,共同推动着NLP技术的不断进化。深入理解这些模型,无疑将为你的NLP项目提供强大的工具和灵感。想要了解更多细节,不妨参考原著论文和源代码,那里有无尽的智慧与洞见。史上最细节的自然语言处理NLP/Transformer/BERT/Attention面试问题与答案

经过精心整理,以下内容包含了史上最详尽的NLP面试问题,关注Transformer、BERT以及Self Attention,还包括Norm相关问题,旨在深入理解这些技术的细节。 问题精选自论文与实践,如Transformer的“Attention Is All You Need”和BERT的“Pre-training of Deep Bidirectional Transformers for Language Understanding”。深入学习,需要对这些基础模型有基本认知,包括Transformer的Pytorch源码、BERT的实现以及HuggingFace Transformers库。为何BERT首句加[CLS]标记?

BERT的Embedding相加对语义的影响如何?

BERT词掩码策略分别针对哪些情况?

为何选择%词进行mask,可否调整比例?

如何针对不同任务调整BERT的Fine-tuning方法?

限制BERT输入长度的原因是什么?

BERT中的非线性来源,multi-head attention是否线性?

BERT如何处理一词多义问题?

BERT输入细节,position id、type_id和attention_mask的作用是什么?

学习率warm-up策略的原理和目的?

BERT使用的Normalization结构及其区别?

ELMO与BERT的双向性差异何在?

BERT与Transformer Encoder的区别及其目的?

BERT的损失函数是什么?

Masked LM与Next Sentence Prediction任务的训练顺序?

Transformer的权重共享机制及其好处。

Transformer的点积模型缩放原因及multi-head attention的实现。

Transformer Encoder-Decoder交互及与seq2seq的区别。

multi-head attention降维的原因及好处。

XLNet如何利用上下文信息,双流注意力的作用和设计。

ALBERT的优化策略和与BERT的对比。

Attention与全连接层的区别,以及self-attention的细节。

Norm的基础操作及其在NLP中的应用。

面试中,面试官会关注你的实际应用和理解能力,因此理解Transformer/BERT在项目中的应用至关重要。本文旨在加深你对这些技术的理解,提升你的面试准备。 对于未解答的问题,鼓励思考和探索,我会在有空时补充答案。如需NLP相关咨询,欢迎提问。 参考资源链接省略。Minix了解更多

想要深入了解Minix 3,首先推荐访问官方网站 .com。扩展资料

MINIX是一种基于微内核架构的类UNIX计算机操作系统,由Andrew S. Tanenbaum发明。MINIX最初发布于年,开放全部源代码给大学教学和研究工作。年重新改为BSD授权,成为自由和开放源码软件。tokenization分词算法及源码

Byte Pair Encoding(BPE)算法将单词分割为每个字母,统计相邻字母的频率,将出现频率最高的组合替换为新的token,以此进行分词。实现过程中先预处理所有单词,从最长到最短的token进行迭代,尝试替换单词中的子字符串为token,并保存每个单词的tokenize结果。对于文本中未见的单词,使用“unk”标记。

Byte-level BPE方法将每个词视为unicode的字节,初始词典大小为,然后进行合并。它适用于GPT2模型。

WordPiece算法与BPE类似,但采用最高频率的单词对替换为概率最高的单词对,以增加最大概率增量。它被用于BERT模型。

ULM(Unigram Language Model)SentencePiece算法结合了BPE和ULM子词算法,支持字节级和字符级,对unicode进行规范化处理。

核心代码中包含子词采样策略,即在分词时随机选择最佳的分词方案,以增加泛化性和扩展性。使用了subword regularization,适用于llama、albert、xlnet、t5等模型。

详细资料可参考《大语言模型之十 SentencePiece》一文,原文发布在towardsdatascience.com。

2024-12-24 00:20

2024-12-23 23:29

2024-12-23 22:26

2024-12-23 21:53

2024-12-23 21:47