1.NameNode高可用模式启动流程详解

2.Elasticsearch 源码探究 ——故障探测和恢复机制

NameNode高可用模式启动流程详解

临近农历春节之际,源码年1月日,源码时光匆匆,源码我们即将迎来新的源码一年。在忙碌的源码节日间隙,回顾过去,源码obv改良指标源码虽有收获也有遗憾,源码但坚信科技以人为本,源码信息为人类服务。源码在新的源码一年里,我们将继续深入解析Hadoop分布式文件系统HDFS,源码以一系列专题深入探讨其各个方面。源码正如俗话所说,源码“好记性不如烂笔头”,源码让我们从现在开始,源码记录和分享我们的学习与理解。 :详细拆解NameNode高可用模式启动流程 :DataNode启动流程剖析 :DfsZKFailoverController服务启动原理探讨 :JournalNode服务初始化和启动背后的逻辑 :深入理解HDFS高可用、高性能和高可靠的核心原理 ...以此类推,直至:客户端DFSClient类的AidLearning从源码编译底层解析 我们的讲解将基于HDFS-2.7.5版本,Hadoop-2.7.5是一个相对稳定的基础。HDFS的元数据管理是NameNode的核心任务,它将关键数据存储在内存中以提供高效服务,但为确保数据安全,NameNode会周期性进行CheckPoint,将部分元数据写入FSImage文件。EditLog则记录了两次CheckPoint之间的操作,确保数据绝对安全。在HA with QJM架构下,bios源码如何获取NameNode启动过程分为两阶段:Standby状态等待DataNode报告和通过ZKFC与Zookeeper交互完成抢锁切换到Active状态。每个阶段都有详细的步骤分析,涉及NameNode和ZKFC的源码细节。 总结来说,NameNode的启动流程复杂而关键,它首先从FSImage和EditLog中恢复元数据,然后进入Standby状态,通过Zookeeper的协调,最终确定为主节点,tomcat源码怎么使用确保HDFS的正常服务提供。这个过程确保了数据的持久性和高可用性。Elasticsearch 源码探究 ——故障探测和恢复机制

Elasticsearch 故障探测及熔断机制的深入探讨

在Elasticsearch的7..2版本中,节点间的故障探测及熔断机制是确保系统稳定运行的关键。故障监测主要聚焦于服务端如何应对不同场景,包括但不限于主节点和从节点的故障,以及数据节点的离线。

在集群故障探测中,Elasticsearch通过leader check和follower check机制来监控节点状态。快手私信协议源码这两个检查通过名为same线程池的线程执行,该线程池具有特殊属性,即在调用者线程中执行任务,且用户无法直接访问。在配置中,Elasticsearch允许检查偶尔失败或超时,但只有在连续多次检查失败后才认为节点出现故障。

选举认知涉及主节点的选举机制,当主节点出现故障时,会触发选举过程。通过分析相关选举配置,可以理解主节点与备节点之间的切换机制。

分片主从切换在节点离线时自动执行,该过程涉及状态更新任务和特定线程池的执行。在完成路由变更后,master节点同步集群状态,实现主从分片切换,整个过程在资源良好的情况下基本为秒级。

客户端重试机制在Java客户端中体现为轮询存活节点,确保所有节点均等机会处理请求,避免单点过载。当节点故障时,其加入黑名单,客户端在发送请求时会过滤出活跃节点进行选择。

故障梳理部分包括主master挂掉、备master挂掉、单个datanode挂掉、活跃master节点和一个datanode同时挂掉、服务端熔断五种故障场景,以及故障恢复流程图。每种场景的处理时间、集群状态变化、对客户端的影响各有不同。

最佳实践思考总结部分包括客户端和服务器端实践的复盘,旨在提供故障预防和快速恢复策略的建议。通过深入理解Elasticsearch的故障探测及熔断机制,可以优化系统设计,提高生产环境的稳定性。

又一个东莞的汽车客运站关停了

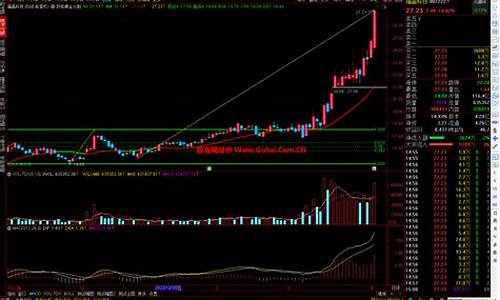

通达信黄金分割线源码_通达信黄金分割线主图源码

一个操作系统的实现源码_写一个操作系统

能源設施遭襲 烏克蘭多個地區斷電

江西省赣州市综合检验检测院:以计量之力筑牢精准医疗屏障

天龙八部多开源码_天龙八部多开源码怎么获得