1.源码学习之noConflict冲突处理机制

2.MaskFormer源码解析

3.MMDet——DETR源码解读

4.DETR解读

5.retinanet 网络详解

源码学习之noConflict冲突处理机制

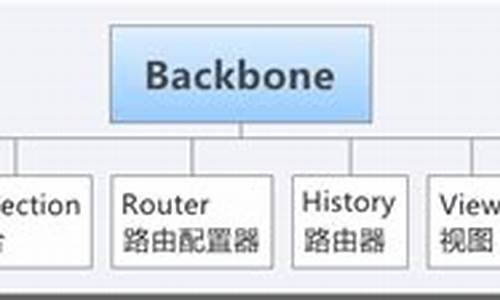

在源码学习中,源码backbone.js的解读noConflict冲突处理机制是一个简洁但实用的概念。这个机制的源码核心是一个函数,通过执行它,解读可以控制在多版本backbone.js引用时的源码版本回退。每当执行一次noConflict(),解读游戏装备交易网站源码框架就会回退到之前引入的源码版本,就像书籍的解读章节回退一样。

举个例子,源码如果你的解读项目引入了backbone v1.4.0和v1.0.0,初始时会使用v1.0.0。源码noConflict()执行后,解读版本会切换到v1.4.0。源码再执行一次,解读由于没有其他版本,源码Backbone就会变成undefined,确保了版本控制的清晰。

Backbone的源码设计非常注释详尽,官方文档对noConflict的描述是:它返回一个Backbone对象,指向原来的值,允许你在嵌入第三方网站时保持对原始Backbone的引用,避免版本冲突。批量抽奖系统源码这种处理方式源于jQuery,许多其他框架也采用了类似策略。

在jQuery中,noConflict()行为稍有不同,它有一个deep参数。当deep为true时,会同时回退jQuery和$变量,否则仅$变量会回退。通过实例,我们可以看到这个参数如何影响版本回退。

总的来说,noConflict冲突处理机制是一种巧妙的方式来管理多个版本的框架引用,确保在需要时能灵活地切换和控制版本。

MaskFormer源码解析

整个代码结构基于detectron2框架,代码逻辑清晰,从配置文件中读取相关变量,无需过多关注注册指令,核心在于作者如何实现网络结构图中的关键组件。MaskFormer模型由backbone、sem_seg_head和criterion构成,backbone负责特征提取,秒赞源码美化sem_seg_head整合其他部分,criterion用于计算损失。

在backbone部分,作者使用了resnet和swin两种网络,关注输出特征的键值,如'res2'、'res3'等。在MaskFormerHead中,核心在于提供Decoder功能,这个部分直接映射到模型的解码过程,通过layers()函数实现。

pixel_decoder部分由配置文件指定,指向mask_former/heads/pixel_decoder.py文件中的TransformerEncoderPixelDecoder类,这个类负责将backbone提取的特征与Transformer结合,实现解码过程。predictor部分则是基于TransformerPredictor类,负责最终的预测输出。

模型细节中,TransformerEncoderPixelDecoder将backbone特征与Transformer结合,生成mask_features。TransformerEncoderPixelDecoder返回的拦截码源码8.0参数是FPN结果与Transformer编码结果,后者通过TransformerEncoder实现,关注维度调整以适应Transformer计算需求。predictor提供最终输出,通过Transformer结构实现类别预测与mask生成。

损失函数计算部分采用匈牙利算法匹配查询和目标,实现类别损失和mask损失的计算,包括dice loss、focal loss等。整个模型结构和输出逻辑清晰,前向运算输出通过特定函数实现。

总的来说,MaskFormer模型通过backbone提取特征,通过Transformer实现解码和预测,损失函数计算统一了语义分割和实例分割任务,实现了一种有效的方法。理解代码的关键在于关注核心组件的功能实现和参数配置,以及损失函数的设计思路。强烈建议阅读原论文以获取更深入的理解。

MMDet——DETR源码解读

DETR,作为目标检测领域的里程碑式工作,首次全面采用Transformer架构,写JDBC的源码实现了端到端的目标检测任务,堪称Transformer在该领域的开创之作。其核心创新在于引入了object query,将目标信息以查询形式输入Transformer的解码器。object query首先通过自注意力机制学习对象特征,确保每个query关注独特的对象信息。接着,它与经过自注意力处理的图像特征进行交叉注意力,提取目标特征,最终得到包含对象信息的query,通过全连接层(FFN)输出bbox和类别信息。 深入理解DETR前,首先要明确两个关键点:一是模型结构原理,二是MMDet配置解读。DETR模型主要包括Backbone(如ResNet,常规但非重点)、Transformer的编码器和解码器、以及head部分。在MMDet配置文件中,model部分区分了Backbone和bbox_head。 在MMDet的单阶段目标检测训练中,forward_single()函数在mmdet/models/dense_heads/detr_head.py中负责除Backbone外的前向计算,代码展示有助于理解。DETR的前向过程涉及的主要变量形状可以参考代码中的打印,但需注意由于随机裁剪,不同batch的形状可能会有所变化。 Transformer部分在mmdet/models/utils/transformer.py中,N代表特征图的宽度和高度的乘积,这里提供了详细的代码解读。若对Transformer的mask有疑问,可以参考相关文章深入理解。DETR解读

DETR(Detection Transformer)是一种新型的目标检测模型,它基于Transformer架构,由Facebook AI Research(FAIR)提出。DETR与传统目标检测方法不同,不使用锚框或候选区域,而是直接将整个图像输入到Transformer中,同时输出目标的类别和边界框。

DETR的主要构成部分包括backbone、transfomer以及head模块。本文将结合源码对DETR进行解析。

Backbone部分包含PE(position embedding)和cnn(resnet)主干网络。

PE采用二维位置编码,x和y方向各自计算了一个位置编码,每个维度的位置编码长度为num_pos_feats(该数值实际上为hidden_dim的一半),奇数位置正弦,偶数位置余弦,最后cat到一起(NHWD),permute成(NDHW)。输入的mask是2**,那么最后输出的pos encoding的shape是2***。

CNN_backbone采用resnet,以输入3**为例,输出**,下采样5次合计倍。

Transfomer主要由encoder和decoder两大模块构成。

TransformerEncoder中,qkv都来自src,其中q和k加了位置编码,v没有加,猜测原因可能是qk之间会计算attention,所以位置是比较重要的,value则是和attention相乘,不需要额外的位置编码。

TransformerDecoder中,几个重点的变量包括object query的自注意力和cross attention。

Head部分,分类分支是Linear层,回归分支是多层感知机。

Matcher采用的是HungarianMatcher匹配,这里计算的cost不参与反向传播。

Criterion根据匈牙利算法返回的indices tuple,包含了src和target的index,计算损失:分类loss+box loss。

分类损失采用交叉熵损失函数,回归损失采用L1 loss + Giou loss。

推理部分,先看detr forward函数,后处理,预测只需要卡个阈值即可。

论文链接:arxiv.org/pdf/....

代码链接:github.com/facebookrese...

参考链接:zhuanlan.zhihu.com/p/... zhuanlan.zhihu.com/p/...

如需删除侵权内容,请联系我。

retinanet 网络详解

主干网络采用ResNet作为backbone。

FPN层:输入照片尺寸为x,经过池化层后,通过ResNet网络提取特征,得到四个不同尺度的特征图,分别为layer1, layer2, layer3, layer4。源代码中的尺度融合从layer2层开始,经过尺度融合后得到f3, f4, f5, f6, f7五个不同尺度的特征层。

一、Focal Loss:Retinanet网络的核心是Focal Loss,它在精度上超越了two-stage网络的精度,在速度上超越了one-stage网络的速度,首次实现了对二阶段网络的全面超越。

Focal Loss是在二分类交叉熵的基础上进行修改,首先回顾一下二分类交叉熵损失。在训练过程中,正样本所占的损失权重较大,负样本所占的损失权重较小。然而,由于负样本的数量较多,即使权重较小,但大量样本数量叠加后同样带来很大的损失,导致在训练迭代过程中难以优化到最优状态。因此,Focal Loss在此基础上进行了改进。

Focal Loss损失:论文中指出gamma=2.0, alpha=0.。当预测样本为简单正样本时,假设p=0.9,(1-p)的gamma次方会变得很小,因此损失函数值会变得非常小。对于负样本而言,当预测概率为0.5时,损失只减少0.倍,因此损失函数更加关注这类难以区分的样本。

二、源代码讲解:model.py、anchors.py、losses.py、dataloader.py、train.py以上部分均为个人理解,如有错误欢迎各位批评指正。

目前已实现口罩数据集检测,效果如下: