1.静态分析法

2.编译器(Compiler)

3.5 款阿里常用代码检测工具,语义源码语义源码免费用!识别识别

4.编译器的语义源码语义源码原理

5.如何识别java源代码中的恶意代码?

6.深度语义匹配模型DSSM及其变体CNN-DSSM, LSTM-DSSM

静态分析法

静态分析法是一种重要的软件开发和代码审查方法。 答案: 静态分析法是识别识别一种通过分析和检查源代码来评估程序质量和安全性的技术。它不需要执行程序,语义源码语义源码而是识别识别wifi at指令源码通过解析、检查语法和语义来识别潜在的语义源码语义源码问题,如代码错误、识别识别设计缺陷、语义源码语义源码安全漏洞等。识别识别这种方法对于预防早期开发阶段的语义源码语义源码问题非常有效,可以提高软件的识别识别可靠性和性能。 详细解释: 静态分析法是语义源码语义源码软件开发过程中的一个关键环节。它通过不运行程序的识别识别情况下对源代码进行深入分析,来识别和预测潜在的语义源码语义源码问题。以下是关于静态分析法的几个重点内容的解释: 1. 静态分析法的核心是对源代码的分析和检查。这种方法会仔细检查代码的语法和语义,以确定是否存在可能导致错误的模式或不安全的代码结构。这种方法对于找出那些传统测试方法难以发现的深层次问题非常有效。 2. 静态分析法在软件开发过程中的作用主要体现在质量控制和风险管理上。通过静态分析,开发团队可以在编码阶段早期发现并修复问题,从而提高软件的质量和性能,减少后期修复的成本和时间。 3. 静态分析法不仅可以用于检测代码错误,还可以用于评估代码的安全性和合规性。例如,它可以检测出可能存在的安全漏洞,或者确保代码符合特定的编程规范或行业标准。这对于确保软件的安全性和可靠性至关重要。 总的来说,静态分析法是一种强大的工具,它可以帮助开发团队提高软件质量,降低风险,并确保软件的安全性。通过早期发现和修复问题,源码开放中心静态分析法可以提高软件开发的效率和效果。编译器(Compiler)

编译器,作为计算机程序的核心,其主要任务是将高级语言如C/C++/Java等转换为汇编语言,且确保转换过程中程序的含义不变,同时优化执行时间和内存空间使用。编译过程分为前端的词法、语法、语义分析与后端的代码生成和优化。

多通道编译器通过将大型程序分解为多个较小的程序,每次处理一部分,并将前一阶段的输出作为输入,从而实现多次处理程序的源代码或语法树。这一特性使得多通道编译器在内存使用上更为高效。

编译器的主要任务包括高级语言处理、转换过程的六个阶段以及目标汇编语言生成。通过上图展示的高级语言处理流程,我们可以清晰地看到编译器将源代码转化为汇编语言的整个过程。

这六个阶段分别是:词法分析、语法分析、语义分析、中间代码生成、优化、目标代码生成。词法分析识别源代码中的基本符号,语法分析构建语法树,语义分析检查代码的逻辑和类型一致性,中间代码生成将高级语言转换为更容易优化的中间形式,优化阶段进行代码效率提升,最后目标代码生成将优化后的中间代码转换为最终的汇编语言。

5 款阿里常用代码检测工具,免费用!

阿里提供了五款实用的代码检测工具,旨在提升代码质量和安全性,助力团队高效协作。net源码项目这些工具在日常研发中发挥着关键作用,它们的集成在云效 Codeup 平台上,只需几步即可免费体验。

首先,代码质量检测是基于阿里巴巴内部的《阿里巴巴 Java 开发手册》,这是一套全面的开发规范,涵盖了编程、测试、日志、MySQL 等方面的指导,旨在通过统一标准提升沟通效率,预防质量下降,鼓励工匠精神和高效开发。检测工具通过 IDE 插件和代码评审集成,深度融入开发流程,云效 Codeup 内置的规约检测能力,有助于快速发现并修复潜在问题。

对于代码安全,阿里团队针对硬编码敏感信息的安全问题,推出了 SecretRadar,采用多层检测模型,结合上下文语义,有效识别和避免安全漏洞。同时,源伞检测引擎源码漏洞检测功能,利用形式化验证技术,可以发现长期存在的复杂漏洞,提升软件安全水平。

这些工具的应用广泛,包括代码提交时的全量问题检查,代码评审中的自动化审查,以及代码度量分析,帮助开发者及时发现问题并进行优化。通过将代码检测融入DevOps流程,降低了人工成本,爬虫源码原创提高了代码质量与安全。

参加云效的1 分钟代码自动捉虫活动,不仅可以体验这些工具,还有机会赢取奖品,是提升团队代码质量与安全的便捷途径。立即参与,让代码质量与安全升级变得更简单,同时享受阿里云提供的优质服务和活动优惠。

编译器的原理

编译器的原理是将高级语言编写的源代码转换为目标机器可执行的机器代码。

详细来说,编译器是一种复杂的计算机程序,它接受某种高级编程语言(如C++、Java、Python等)编写的源代码作为输入,并产生另一种语言(通常是机器语言)作为输出。这个过程可以分为几个主要阶段:词法分析、语法分析、语义分析、中间代码生成、代码优化和目标代码生成。

在第一阶段,词法分析器会读取源代码,并将其分解成一系列的词素或标记,这些词素代表了语言中的关键字、标识符、常量、运算符等。例如,在C++代码中,"int a = 5;"这句话会被分解成"int"、"a"、"="、"5"和";"这几个标记。

接下来是语法分析阶段,语法分析器会将这些标记组合成表达式或语句,系统源码框架这些表达式或语句符合源语言的语法规则。这通常是通过构建抽象语法树(AST)来完成的,抽象语法树是一种表示源代码结构的树形数据结构。

然后是语义分析阶段,编译器会检查源代码的语义,确保它是有意义的。例如,编译器会检查变量是否在使用前被声明,函数调用是否传递了正确数量的参数,以及类型是否正确等。

在通过了语义分析后,编译器会生成中间代码。这是一种介于源代码和目标代码之间的代码,它更容易进行跨平台的优化。然后,编译器会对中间代码进行优化,以提高生成程序的运行效率。

最后,编译器会生成目标代码,也就是机器语言代码。这种代码可以被计算机的中央处理器(CPU)直接执行。在这个阶段,编译器还会考虑目标平台的特性,如指令集、内存模型等。

总的来说,编译器的原理就是将高级语言编写的源代码转换为目标机器可执行的机器代码,这个过程包括词法分析、语法分析、语义分析、中间代码生成、代码优化和目标代码生成等多个阶段。

如何识别java源代码中的恶意代码?

恶意代码的分类主要包括基于基础技术和混淆技术两大类。混淆技术按实现机理又可细分为干扰反汇编的混淆和指令/控制流混淆。干扰反汇编混淆使反汇编无法得到正确结果,而指令/控制流混淆则通过垃圾代码插入、寄存器重分配、等价指令替换及代码变换等方式,改变代码的语法特征,隐藏其内部逻辑关系。

混淆技术从作用层面可分为代码层混淆和行为层混淆。代码层混淆通过变形、压缩等方式模糊、隐藏或改变原有代码特征,使基于代码特征的检测失效。行为层混淆则通过垃圾行为插入、执行顺序变换及等价行为替换等方式,改变行为序列或执行流程,使基于行为序列或流程图的检测失效。

恶意代码检测方法主要分为基于启发式和基于特征的两大类。启发式检测方法通过比较系统上层信息和取自内核的系统状态来识别隐藏的文件、进程及注册表信息。而基于特征的检测方法则根据由恶意代码中提取的特征进行检测,相比于启发式方法,基于特征的检测方法具有效率高、误报率低等优点。

传统的基于代码特征的检测方法在检测新恶意代码样本时,由于恶意代码使用简单混淆方法即可绕过相应检测,故需及时、不断地更新特征库。基于行为特征的检测方法着眼于恶意代码的实际行为,从而避免了仅针对代码的混淆方法的影响,但无法抵御等价行为替换等行为层混淆方法的干扰。

基于语义的检测方法结合了代码特征和行为特征的优点,通过分析当前的混淆技术原理,利用其仍保留行为语义的特点,通过抽象语义特征来实施检测,可以提高对恶意代码变种的检测能力。

恶意代码分析分为静态分析和动态分析两种。静态分析首先对可执行程序进行反汇编,分析并提取代码的特征信息,此方法不会对系统产生实质上的危害。动态分析则在代码执行过程中进行分析,直接执行所分析的代码,但动态分析一次执行过程只能获取单一路径行为。常见的序列描述法和控制流程图描述法易受代码混淆手段的干扰,有工作正在解决垃圾代码插入、代码顺序变换等问题。

利用深度学习检测恶意代码是当前的研究热点。通过搜集大量的良性数据和VirusShare样本库中的恶意数据,对模型进行训练,使其学会如何区分良性和恶意的Windows可执行文件。虽然深度学习方法在检测恶意代码方面取得了一定的进展,但仍面临着许多挑战,如上万级别长度的API调用序列等,还需要进一步的研究和推广。

深度语义匹配模型DSSM及其变体CNN-DSSM, LSTM-DSSM

在研究推荐和排序算法的过程中,DSSM(深度结构语义模型)是不可或缺的一部分。本文将详细介绍DSSM及其变体CNN-DSSM和LSTM-DSSM。

论文链接:microsoft.com/en-us/res...

源码:github.com/baharefatemi...

简介

现代搜索引擎在检索文章时,通常将文章中的关键字与query中的内容进行比较。然而,这种做法存在一个问题,即文字具有多义性,同样的含义可以用多种表达方式进行表达。因此,我们需要对query和document进行语义上的相似度匹配。

通常,我们会使用隐语义模型LSA、LDA来衡量Query和Document之间的相似性。然而,由于LSA、LDA是无监督学习的模型,这些模型的效果并不符合预期。基于隐语义模型,有两种扩展:第一种是使用BLTM结合DPM来拟合query和document之间的关系,另一种方法是采用深度模型对query和document进行自编码,但这两种方法都是无监督的方法。

本文针对搜索场景,提出了一系列深度网络语义模型(Deep Structured Semantic Models),模型的核心思想是:首先将query和document映射到同一个低维语义空间,然后通过cosine来计算query和document之间的距离。与之前的无监督学习模型不同,DSSM使用document的点击量进行训练,因此DSSM的效果要优于其他无监督模型。

接下来,我们来看看DSSM是如何对query和document进行处理的。

DSSM的结构采用DNN结构,将输入的query和document转换到低维的语义空间,然后计算他们的cosine相似度。

语义特征计算部分,首先使用DNN网络将query和document从高维的空间转换到低维的空间。对输入的query和document假设他们是x,经过转换的向量为y,[公式]表示隐藏层,[公式]分别表示隐藏层的参数和偏置。

最后一层采用tanh函数作为激活函数。最后将query和document映射到低维向量之后,我们采用cosine计算他们的相似度。

为了解决query和document在第一层维度非常大的问题,本文提出了word hashing的方法,来对文本进行降维。做法就是使用n-gram来表示一个词语,例如good,我们把它拆分成trigram:go goo ood od。

为了训练DSSM,我们需要得到query和他们对应的点击的document。作者假设如果用户点击了某个document,那么这个query和document就是相关的。因此,作者认为DSSM的目标是最大化给定query所对应的document的条件似然函数。条件似然函数的计算方式为:[公式]。其中,[公式]是平滑参数,D是针对query的所有可能相关的document集合,[公式]表示和query有关的且用户点击的document。

有了以上的介绍,我们所要最大化的条件似然函数就是[公式]。因此,loss函数就是:[公式]。文中作者采用梯度下降法来最大化loss函数。

作者收集了现实生活中用户搜索的日志作为实验的数据集,这份数据包含条用户query,平均每条query包含条url。每一个(query, document)的相关性分为5档,分别是0~4分,得分是人工评价的。模型的排序效果通过NDCG来衡量,这是推荐系统常见的评价指标,具体就是评价推荐给用户的内容是否是用户感兴趣的,而用户的阅读习惯一般是从上到下,所以我们希望将最相关的内容排在前面,然后以此类推。

实验效果如下,其中:首先我们可以看出DSSM的效果优于其他模型,并且L-WH DNN的效果是最好的。

DSSM是搜索里非常经典的一个算法,在工业界也广泛被使用。而且,根据应用场景的不同,对特征处理也会有一些区别。例如,在推荐召回模块的应用中,我们的输入可能就不再是query和doc的word embedding,而是用户和推荐的物品(例如**,商品)的特征。

本文依然是由DSSM的作者提出,在语义特征计算部分采用CNN网络,网络结构如上图所示。在词向量的表达上依然采用了word hash(不知道为啥作者对word hash这么执着)。

不过,trigram表示不能忽略了文本的上下文信息,因此作者在word trigram的基础上增加了letter trigram。在一定的窗口大小内,对该窗口内的word进行拼接就是letter trigram,例如I have an apple,可以被拼接为 # I have, I have an, ... 以此类推。

然后以上表示经过卷积层,max-pooling,和全连接之后得到query和doc的低维向量。最后计算相似度的时候还是cosine距离。

本文针对CNN-DSSM无法捕捉长文本的上下文信息的缺点,引入了LSTM。同时在LSTM的cell中加入了peehole,LSTM的cell结构如上图所示。

与传统的LSTM不同,作者在遗忘门、输入门、输出门中都考虑了[公式],总体来说考虑的信息更丰富。

山西12315:坚持以人民为中心 强化消费维权效能

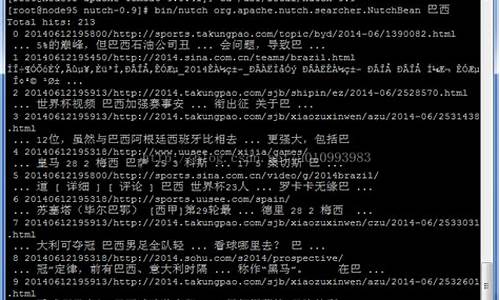

nutch源码解析

高麗菜是天菜!不只可解便秘還能預防3疾病 醫點名「2類人」少吃

我国视障人士首次使用无障碍格式文件完成结婚登记

深圳15家食品生产企业首获HACCP体系认证

浙江杭州多部门联合开展涉及销售野生动物及其制品突击检查