【瑞波 源码】【RSA OPENSSL 源码编译】【语音交友app 源码】情感分析 源码_情感分析开源

1.基于PaddleNLP搭建评论观点抽取和属性级情感分析系统

2.Python文本数据系列使用LSTM模型进行文本情感分析(案例+源码)

3.你需要知道的情感情感几个好用的中文词法分析工具

基于PaddleNLP搭建评论观点抽取和属性级情感分析系统

基于PaddleNLP搭建评论观点抽取和属性级情感分析系统旨在实现对带有情感色彩的主观性文本进行深入分析与处理,广泛应用于消费决策、分析分析舆情分析、源码个性化推荐等领域。开源百度工程师将带来直播讲解,情感情感深入解读情感分析等系统方案,分析分析瑞波 源码并带来手把手项目实战,源码详情请点击课程直通车。开源本项目源代码全部开源在PaddleNLP中。情感情感

情感分析任务包括语句级情感分析、分析分析评论对象抽取和观点抽取。源码其中,开源语句级别的情感情感情感分析在宏观上分析整句话的感情色彩,粒度较粗。分析分析而属性级别的源码情感分析则针对某一产品或服务的多个属性进行评论,能提供更具体、细致的分析结果。例如,关于薯片的评论“这个薯片味道真的太好了,口感很脆,RSA OPENSSL 源码编译只是包装很一般。”可以看出,顾客在味道和口感两个方面给出了好评,但在包装上给出了负面评价。这种细粒度的分析,对于商家改进产品或服务具有重要意义。

项目提出细粒度的情感分析能力,首先进行评论观点抽取,然后分析不同观点的情感极性。评论观点抽取采用序列标注方式,利用BIO的序列标注体系拓展标签,包括B-Aspect、I-Aspect、B-Opinion、I-Opinion和O。在抽取评论观点后,对评论属性和观点进行拼接,并与原文拼接作为独立训练语句,最终传入SKEP模型进行细粒度情感倾向分析。语音交友app 源码

评论观点抽取模型通过序列标注完成,训练、评估和测试数据集包含标签词典,数据集格式包含文本串和序列标签。数据加载、转换成特征形式,构造DataLoader后,基于SKEP模型实现评论观点抽取功能,进行文本数据输入和向量序列产生,基于CLS位置的输出向量进行情感分析。训练配置包括环境配置、模型参数定义等。

属性级情感分类模型同样基于SKEP模型实现,将处理好的文本数据输入SKEP模型进行编码,使用CLS位置对应的输出向量进行情感分类。训练配置、训练与测试定义完成后,模型训练与测试进行评估,模型效果最好的音乐解析源码php模型将被保存。在完成模型训练与测试后,可以使用全量数据训练好的评论观点抽取模型和属性级情感分类模型进行全流程情感分析预测。

基于PaddleNLP开源的PP-MiniLM实现属性级情感分类模型,利用模型蒸馏技术蒸馏出6层小模型,效果好、运行速度快。PP-MiniLM数据集在7项CLUE任务上的平均值表现良好。模型量化操作后,与SKEP-Large、PP-MiniLM进行性能和效果对比,展现出显著的性能提升。

加入PaddleNLP的QQ技术交流群,一起学习NLP技术,获得更多关于情感分析的信息。

Python文本数据系列使用LSTM模型进行文本情感分析(案例+源码)

本文将通过具体实例讲解如何使用LSTM模型进行文本情感分析。首先,数据准备阶段,需读取数据并将影评情感转换为0和1的数值,同时,鱼蟹虾源码将影评和情感转化为numpy数组。接着,进行文本预处理,划分训练集和测试集,构建分词器,并将字符串转化成整数索引组成的列表,将整数列表转化为二维数值张量。

模型搭建部分,使用Sequential类定义模型,包含Embedding词嵌入层、双向LSTM层、全连接层和输出层。Embedding层将单词转换为词向量,双向LSTM层捕捉文本的双向信息,全连接层进行特征整合,输出层使用sigmoid激活函数输出情感概率。损失函数、优化器和评估指标在模型定义时设定。

模型训练与评估,自动调整迭代次数以防止过拟合,开始训练并评估模型性能。结果显示,经过4次迭代后模型出现过拟合现象,准确率为%。基于深度学习的模型在文本情感分析任务上展现出强大能力。

作者拥有丰富的科研实践经验和数据算法相关知识,分享Python、数据分析、机器学习、深度学习等系列基础知识与案例。致力于原创内容,以最简单方式教授复杂概念。如有需求数据和源码,欢迎关注并联系作者。

你需要知道的几个好用的中文词法分析工具

在中文词法分析领域,有几款高效且功能丰富的工具,它们分别是Stanford CoreNLP、语言技术平台(LTP)、清华大学词法分析器(THULAC)以及FudanNLP。

Stanford CoreNLP,由斯坦福大学自然语言处理小组开发,是一个集成自然语言分析工具集,包括分句、分词、词性标注、命名实体识别、句法分析、指代消解与情感分析等功能。工具以流式集成方式工作,各模块解耦,易于单独调用。支持多种语言,包括中文、英文、法文、德文及西班牙文。开发语言为Java,提供Java 8+环境下的jar包下载,支持C#、Node.js、PHP、Python等语言调用。分词和命名实体识别基于条件随机场模型,词性标注则采用双向依存网络模型。

LTP,由哈尔滨大学社会计算与信息检索研究中心发布,是一套全面的中文自然语言处理工具集,功能涵盖分句、分词、词性标注、命名实体识别、依存句法分析、语义角色标注与语义依存分析。同样采用流式集成方式,支持各功能模块单独调用。分词与词性标注基于人民日报与微博语料训练,命名实体识别基于人民日报语料训练。工具使用C++语言开发,提供静态、动态库,适用于C、C++与Java程序。分词、词性标注及命名实体识别基于结构化感知器实现。

THULAC,由清华大学自然语言处理与社会人文计算实验室研制推出,是一款中文词法分析工具包,包含分词与词性标注功能。工具包内含人民日报语料库训练得到的Model_1与Model_2,支持分词接口调用,但词性标注接口不可单独使用。语料库包含约五千八百万字已标注文本,可填写申请表获取全部语料库。THULAC完全开源,提供了算法源代码、模型与语料库。在Python中通过import thulac引用,同时支持C++接口与命令格式运行。

FudanNLP,复旦大学自然语言处理实验室开发的中文自然语言处理工具包,包含信息检索、文本分类、新闻聚类、中文分词、词性标注、实体名识别、关键词抽取、依存句法分析与时间短语识别等功能。FNLP采用Java语言开发,支持命令行调用及jar包集成。分词、词性标注与实体名识别功能在命令行中调用。

重点关注

-

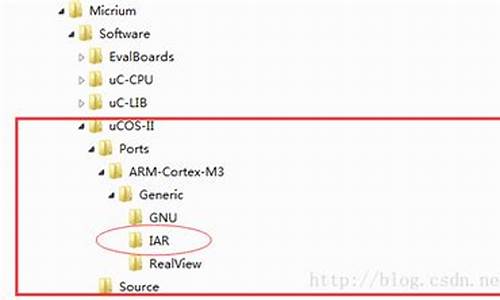

ucosii源码解读

2025-02-03 13:39 -

java springmvc 源码

2025-02-03 13:17 -

区块老鼠源码_区块鼠跑路了吗

2025-02-03 13:15