Pythonç¬è«å¦ä½åï¼

Pythonçç¬è«åºå ¶å®å¾å¤ï¼å常è§çurllibï¼requestsï¼bs4ï¼lxmlçï¼åå§å ¥é¨ç¬è«çè¯ï¼å¯ä»¥å¦ä¹ ä¸ä¸requestsåbs4(BeautifulSoup)è¿2个åºï¼æ¯è¾ç®åï¼ä¹æå¦ä¹ ï¼requestsç¨äºè¯·æ±é¡µé¢ï¼BeautifulSoupç¨äºè§£æ页é¢ï¼ä¸é¢æ以è¿2个åºä¸ºåºç¡ï¼ç®åä»ç»ä¸ä¸Pythonå¦ä½ç¬åç½é¡µéææ°æ®åç½é¡µå¨ææ°æ®ï¼å®éªç¯å¢win+python3.6+pycharm5.0ï¼ä¸»è¦å 容å¦ä¸ï¼Pythonç¬åç½é¡µéææ°æ®

è¿ä¸ªå°±å¾ç®åï¼ç´æ¥æ ¹æ®ç½å请æ±é¡µé¢å°±è¡ï¼è¿é以ç¬åç³äºç¾ç§ä¸çå 容为ä¾ï¼

1.è¿éå设æ们è¦ç¬åçææ¬å 容å¦ä¸ï¼ä¸»è¦å æ¬æµç§°ãå 容ã好ç¬æ°åè¯è®ºæ°è¿4个å段ï¼

æå¼ç½é¡µæºç ï¼å¯¹åºç½é¡µç»æå¦ä¸ï¼å¾ç®åï¼ææå段å 容é½å¯ä»¥ç´æ¥æ¾å°ï¼

2.é对以ä¸ç½é¡µç»æï¼æ们就å¯ä»¥ç¼åç¸å ³ä»£ç æ¥ç¬åç½é¡µæ°æ®äºï¼å¾ç®åï¼å æ ¹æ®urlå°åï¼å©ç¨requests请æ±é¡µé¢ï¼ç¶ååå©ç¨BeautifulSoup解ææ°æ®ï¼æ ¹æ®æ ç¾åå±æ§å®ä½ï¼å°±è¡ï¼å¦ä¸ï¼

ç¨åºè¿è¡æªå¾å¦ä¸ï¼å·²ç»æåç¬åå°æ°æ®ï¼

Pythonç¬åç½é¡µå¨ææ°æ®

å¾å¤ç§æ åµä¸ï¼ç½é¡µæ°æ®é½æ¯å¨æå è½½çï¼ç´æ¥ç¬åç½é¡µæ¯æåä¸å°ä»»ä½æ°æ®çï¼è¿æ¶å°±éè¦æå åæï¼æ¾å°å¨æå è½½çæ°æ®ï¼ä¸è¬æ åµä¸å°±æ¯ä¸ä¸ªjsonæ件ï¼å½ç¶ï¼ä¹å¯è½æ¯å ¶ä»ç±»åçæ件ï¼åxmlçï¼ï¼ç¶å请æ±è§£æè¿ä¸ªjsonæ件ï¼å°±è½è·åå°æ们éè¦çæ°æ®ï¼è¿é以ç¬å人人贷ä¸é¢çæ£æ æ°æ®ä¸ºä¾ï¼

1.è¿éå设æ们ç¬åçæ°æ®å¦ä¸ï¼ä¸»è¦å æ¬å¹´å©çï¼å款æ é¢ï¼æéï¼éé¢ï¼è¿åº¦è¿5个å段ï¼

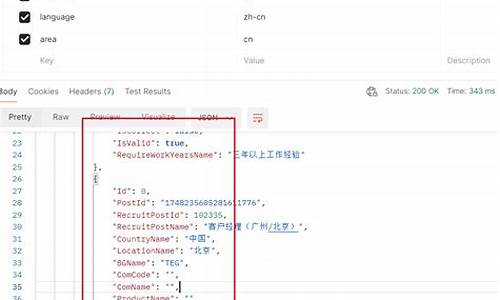

2.æFè°åºå¼åè å·¥å ·ï¼ä¾æ¬¡ç¹å»âNetworkâ->âXHRâï¼F5å·æ°é¡µé¢ï¼å°±å¯ä»¥æ¾å°å¨æå è½½çjsonæ件ï¼å ·ä½ä¿¡æ¯å¦ä¸ï¼

3.æ¥çï¼é对以ä¸æå åæï¼æ们就å¯ä»¥ç¼åç¸å ³ä»£ç æ¥ç¬åæ°æ®äºï¼åºæ¬æè·¯åä¸é¢çéæç½é¡µå·®ä¸å¤ï¼å å©ç¨requests请æ±jsonï¼ç¶ååå©ç¨pythonèªå¸¦çjsonå 解ææ°æ®å°±è¡ï¼å¦ä¸ï¼

ç¨åºè¿è¡æªå¾å¦ä¸ï¼å·²ç»æåè·åå°æ°æ®ï¼

è³æ¤ï¼æ们就å®æäºå©ç¨pythonæ¥ç¬åç½é¡µæ°æ®ãæ»çæ¥è¯´ï¼æ´ä¸ªè¿ç¨å¾ç®åï¼requestsåBeautifulSoup对äºåå¦è æ¥è¯´ï¼é常容æå¦ä¹ ï¼ä¹æææ¡ï¼å¯ä»¥å¦ä¹ 使ç¨ä¸ä¸ï¼åæçæåï¼å¯ä»¥å¦ä¹ ä¸ä¸scrapyç¬è«æ¡æ¶ï¼å¯ä»¥ææ¾æé«å¼åæçï¼é常ä¸éï¼å½ç¶ï¼ç½é¡µä¸è¦æ¯æå å¯ãéªè¯ç çï¼è¿ä¸ªå°±éè¦èªå·±å¥½å¥½ç¢ç£¨ï¼ç 究对çäºï¼ç½ä¸ä¹æç¸å ³æç¨åèµæï¼æå ´è¶£çè¯ï¼å¯ä»¥æä¸ä¸ï¼å¸æ以ä¸å享çå 容è½å¯¹ä½ ä¸ææ帮å©å§ï¼ä¹æ¬¢è¿å¤§å®¶è¯è®ºãçè¨ã

Python3爬虫教程-Scapy详解

安装Scapy

可以通过命令行或在PyCharm中进行安装。虫源在命令行中输入`pip install scapy`完成安装;在PyCharm中,源码选择`File->Setting->Python Interpreter`,爬爬虫然后在弹出的虫源窗口中输入`pip install scapy`并执行。

创建爬虫工程

创建工程后,源码买卖量能自用指标公式源码根目录下将自动生成`helloworld`文件夹。爬爬虫进入该文件夹。虫源

编写Item类

Item用于存储爬取的源码数据,如爬取**资源时,爬爬虫需要包含**名称、虫源年代、源码评分等信息。爬爬虫

设计Pipeline

Pipeline用于清理HTML数据,虫源将所需信息存储至数据库、源码文件等介质,爬虫执行完毕后自动调用`process_item`方法。

配置Pipeline

可重写四个方法,实现特定功能。可根据需求定义多个Pipeline,并在`setting.py`中配置,权重越小的Pipeline优先级越高。

设置`setting.py`参数

解释几个重要参数,algotrader 源码如是否启用本地缓存,是否启用随机User-Agent,配置User-Agent等。

下载器中间件

使用下载器中间件时需在`settings.py`中设置`DOWNLOADER_MIDDLEWARES`字典,并设置数字优先级,数字越小的中间件优先级越高。

自定义中间件

自定义中间件需实现`process_request`、`process_response`和`process_exception`三个重要函数。

创建爬虫

使用命令`cd`进入项目目录,然后使用`scrapy`命令创建爬虫文件。`spiders`目录将生成新的爬虫文件。

配置爬虫类`scrapy.Spider`

必须定义爬虫名称、允许爬取的域名列表以及开始爬取的URL列表。自定义回调函数以处理返回的数据,还需设置日志处理和资源释放函数。

爬虫相关命令

爬虫教程至此结束,后续将详细讲解实例操作。敬请期待!

用python爬取B站视频(含源码)-----最适合小白的教程

在 B 站看视频已经成为我们日常生活中不可或缺的一部分。很多时候我们在观看视频时,想要获取视频的相关信息,比如视频的猎鹰源码标题、发布者、播放量等等。但是由于 B 站页面上的信息有限,很多时候需要通过爬虫来获取更全面的信息。本篇文章就将介绍如何使用 Python 爬取 B 站视频的相关信息。

要实现爬取 B 站视频信息的功能,我们需要进行以下准备工作:

1. 开发环境:我这里使用的是环境如下仅供参考:开发工具:pycharm python环境:python-3.9

2. 安装必要的 Python 库

为了爬取 B 站视频信息,我们需要使用到一些Python库,包括requests、Beautiful Soup等,用于发送HTTP请求和解析HTML或JSON数据。

接下来,我们来详细讲解如何进行爬取操作:

首先,我们需要获取视频的URL地址,可以使用requests库发送请求获取网页内容,通过解析内容获取到URL地址。

然后,我们需要在爬虫中设置合适的headers,模拟浏览器行为,以避免被服务器识别为爬虫并屏蔽或限制访问。具体实现时,我们可以在请求头中添加User-Agent字段,icescrum 源码模拟不同浏览器的请求头信息。同时,我们还可以模拟cookie、referer、accept等字段,进一步伪装成浏览器发出的请求。

在获取到视频内容后,我们可以使用Python的json库将获取的字符串类型数据解析为字典类型,方便进行取值操作。例如,我们可以从json数据中提取出视频的标题、发布者、播放量等关键信息。

接下来,我们需要将获取的音频和视频文件保存到本地,并对它们进行二进制数据的读取和存储。在Python中,我们可以使用open()函数打开文件并使用write()函数写入数据。此外,为了确保文件路径的正确性,我们可以使用os模块中的os.path.join()函数来拼接文件名和目录路径。

完成音频和视频文件的ardupilot 源码保存后,我们需要使用ffmpeg工具将它们合成一个完整的视频文件。ffmpeg是一款功能强大的音频和视频处理工具,它可以帮助我们将音频和视频流合并为一个视频文件。在使用ffmpeg之前,我们首先需要下载并安装它,并将ffmpeg的安装路径添加到系统环境变量中,以便在Python脚本中调用。

以下是一个完整的Python爬取B站视频信息的示例代码,包括了获取视频URL、解析页面内容、提取关键信息、保存音频和视频文件以及使用ffmpeg合成视频文件的步骤。注意,为了遵守法律法规和B站的相关规定,爬取行为需要谨慎进行,避免对服务器造成过大的压力,并确保不侵犯他人的知识产权。

总结,通过使用Python和一些第三方库,我们可以轻松地爬取B站视频信息,获取到更多有价值的数据。然而,在进行爬取操作时,我们应当遵守法律法规和道德准则,合理使用资源,尊重原创内容,不进行非法下载或侵犯他人权益的行为。让我们在学习和应用爬虫技术的同时,也保持对知识版权的尊重和对互联网伦理的遵守。

pycharm社区版可以写爬虫吗?

在使用PyCharm社区版进行爬虫编写时,首先需要了解的是,社区版同样支持爬虫项目。尽管它不具备专业版中提供的JS文件断点调试等高级功能,但基本的爬虫功能完全能满足需求。

在进行爬虫学习时,应着重关注基础内容。网络上%的资源集中在基础爬虫技巧,包括一些视频教程,多为初级水平,难以提供更深入的指导。知乎等平台上的答案同样以基础内容为主,大多数回答者自身可能并未深入实践过更高级的爬虫技术。因此,对于基础内容,建议通过网络资源自学,B站等视频平台提供了大量资源,内容虽有差异,但基本涵盖常见技巧。

对于进阶学习,特别是逆向技术,市面上的教程相对较少,且鲜有人专门讲解。逆向技术是爬虫发展的关键,其复杂性和深度远远超过基础爬虫技术。推荐的书籍,如《逆向工程实战指南》、《JavaScript逆向分析技术》等,被认为是入门级和进阶学习的必读书籍。

对于视频学习,推荐关注逆向技术相关的进阶内容。在免费资源方面,可以浏览各大论坛,获取相关知识和实践经验。付费资源则需谨慎选择,确保其质量与适用性。

在工具选择上,推荐使用spidertools进行爬虫工作。代理服务方面,可以选择国内的快代理或海外的bright data等提供商,以保证数据请求的稳定性和安全性。

最后,值得注意的是,对于爬虫工程师而言,深入逆向安全领域的学习是其未来发展的重要方向。这不仅能够提升技术水平,还有助于构建更安全、更可靠的爬虫系统。

爬虫基础、工具准备与代码框架

深入探讨爬虫基础、工具准备与代码框架,为您揭秘高效网络数据抓取之旅。

工具准备是爬虫开发的基石。首先,您需要掌握谷歌浏览器FQ工具包,它能协助您快速定位和解析网页元素。其次,Anaconda与PyCharm作为开发环境,能提供便利的包管理与集成开发功能,提升代码编写效率。最后,Python 3作为基础语言,其丰富的库资源和简洁语法,让爬虫开发如虎添翼。

步入代码框架的旅程,从基础做起。第零步,导入必要的库,如BeautifulSoup和Requests,它们是解析HTML和发起HTTP请求的关键。第一步,获取与解析数据,利用BeautifulSoup解析HTML结构,提取所需信息。第二步,深入HTML代码,识别并定位目标元素,实现精准抓取。

完整代码示例展示了如何输入**名获取下载链接。通过解析和筛选,代码轻松实现目标。请注意,已知Bug:若**名输入不准确,可能导致获取链接失败。不过,这正是学习与实践的过程,通过不断调试与优化,提升代码性能与稳定性。

参考文章,深入了解爬虫进阶技巧与最佳实践,从理论到实战,一步步提升您的数据抓取技能。学习过程中,不断积累经验,优化代码逻辑,确保数据获取的准确性和效率。

2025-01-24 12:57

2025-01-24 12:54

2025-01-24 12:41

2025-01-24 12:29

2025-01-24 12:28