1.jieba源码解析(一)——中文分词

2.TiKV 源码解析系列文章(十四)Coprocessor 概览

3.LLVM源码编译及调试

4.DataX任务容器

5.Apollo 8.0 配置参数读取源码解析:以 Planning 模块为例

6.Python 结巴分词(jieba)源码分析

jieba源码解析(一)——中文分词

全模式解析:

全模式下的成源成中文分词通过构建字典树和DAG实现。首先加载字典,码源码代码生字典树中记录词频,成源成例如词"不拘一格"在字典树中表示为{ "不" : 0,码源码代码生 "不拘" : 0, "不拘一" : 0, "不拘一格" : freq}。接着构造DAG,成源成表示连续词段的码源码代码生netty 源码下载起始位置。例如句子'我来到北京清华大学',成源成分词过程如下:

1. '我':字典树中key=0,码源码代码生尝试'我来',成源成不在字典,码源码代码生结束位置0寻找可能的成源成分词,DAG为 { 0:[0]}。码源码代码生

2. '来':字典树中key=1,成源成尝试'来到',码源码代码生在字典,成源成继续尝试'来到北',不在字典,结束位置1寻找可能的分词,DAG为 { 0:[0], 1:[1]}。

3. '到':字典树中key=2,尝试'来到北',不在字典,结束位置2寻找可能的分词,DAG为 { 0:[0], 1:[1], 2:[2]}。

4. 以此类推,最终形成所有可能分词结果:我/ 来到/ 北京/ 清华/ 清华大学/ 华大/ 大学。

全模式的关键代码涉及字典树和DAG的构建与使用。

精确模式与HMM模式解析:

精确模式与HMM模式对句子'我来到北京清华大学'的分词结果分别为:

精确模式:'我'/'来到'/'北京'/'清华大学'

HMM模式:'我'/'来到'/'了'/'北京'/'清华大学'

HMM模式解决了发现新词的问题。解析过程分为三个步骤:

1. 生成所有可能的分词。

2. 生成每个key认为最好的jforum 源码分词。

3. 按照步骤2的方式对每个key的结果从前面向后组合,注意判断单字与下个单字是否可以组成新词。

最后,解析结果为:我/ 来到/ 北京/ 清华/ 清华大学

HMM模式中的Viterbi算法在jieba中用于发现新词。算法通过统计和概率计算,实现新词的发现与分词。

具体应用中,HMM模型包含五个元素:隐含状态、可观测状态、初始状态概率矩阵、隐含状态转移概率矩阵、观测状态转移概率矩阵。模型利用这些元素实现状态预测与概率计算,进而实现中文分词与新词发现。

在Viterbi算法中,重要的是理解隐含状态、可观测状态、转移概率矩阵之间的关系,以及如何利用这些信息进行状态预测和概率计算。具体实现细节在代码中体现,包括字典树构建、DAG构造、概率矩阵应用等。

TiKV 源码解析系列文章(十四)Coprocessor 概览

本文将简要介绍 TiKV Coprocessor 的基本原理。TiKV Coprocessor 是 TiDB 的一部分,用于在 TiKV 层处理读请求。通过引入 Coprocessor,TiKV 可以在获取数据后进行计算,从而提高性能。dayz源码

传统处理方式中,TiDB 向 TiKV 获取数据,然后在 TiDB 内部进行计算。而 Coprocessor 则允许 TiKV 进行计算,将计算结果直接返回给 TiDB,减少数据在系统内部的传输。

Coprocessor 的概念借鉴自 HBase,其主要功能是对读请求进行分类,处理包括 TableScan、IndexScan、Selection、Limit、TopN、Aggregation 等不同类型请求。其中,DAG 类请求是最复杂且常用的类型,本文将重点介绍。

DAG 请求是由一系列算子组成的有向无环图,这些算子在代码中称为 Executors。DAG 请求目前支持两种计算模型:火山模型和向量化模型。在当前的 TiKV master 上,这两种模型并存,但火山模型已被弃用,因此本文将重点介绍向量化计算模型。

向量化计算模型中,所有算子实现了 BatchExecutor 接口,其核心功能是 get_batch。算子类型包括 TableScan、IndexScan、signapk源码Selection、Limit、TopN 和 Aggregation 等,它们之间可以任意组合。

以查询语句“select count(1) from t where age>”为例,展示了如何使用不同算子进行处理。本文仅提供 Coprocessor 的概要介绍,后续将深入分析该模块的源码细节,并欢迎读者提出改进意见。

LLVM源码编译及调试

为了深入理解并实现LLVM源码的编译与调试,我们需要分步骤进行,逐一安装相关软件并配置环境。首先,安装cmake,这是构建过程的核心工具。 在Linux环境下,我们可以使用tar命令来下载并解压cmake的安装包。具体的步骤是:访问cmake官网,下载cmake-3..0-rc2-linux-x_.tar.gz。

使用tar命令解压文件:`tar xf cmake-3..0-rc2-linux-x_.tar.gz`。

将解压后的文件移到/usr/share目录,并重命名为cmake-3..0-rc2-linux-x_以方便访问。

创建软连接,将cmake-3..0-rc2-linux-x_/bin/cmake移动到/usr/bin目录,并重命名为cmake,确保它可以被直接调用。

然后,安装ninja,这是threadx源码构建过程中高效的任务执行工具。使用git克隆ninja的源代码。

运行配置脚本以生成构建文件。

复制ninja到/usr/bin目录。

通过`ninja --version`检查ninja的安装情况。

接下来,安装Python、gcc和g++,这是构建LLVM环境的基本依赖。 之后,安装LLVM。我们可以通过git克隆LLVM项目并进行配置、构建和安装。克隆LLVM项目。

指定版本(例如,基于特定版本)。

切换到项目目录并使用cmake进行配置。

使用预先选择的构建系统(如Ninja)和选项进行构建。

执行构建并使用ninja命令进行编译。

调试LLVM源码涉及查看支持的后端target、使用前端编译器(clang)生成LLVM IR、使用LLVM工具(如llc)进行调试、并使用graphviz生成可视化图表。 在调试过程中,可以使用以下工具:查看各阶段DAG使用llvm-dis。

查看AMDGPU寄存器信息与指令信息使用llvm-tblgen。

通过上述步骤,您可以成功安装并配置LLVM源码的编译环境,并进行有效的调试与分析。DataX任务容器

DataX任务容器涉及的源码分析如下:

在DataX中,判断容器是否为job或taskGroup类型,这一步骤是通过容器执行源码实现的。DataX提供两种容器类:taskGroupContainer和jobContainer,它们都是抽象类AbstractContainer的实现。

抽象类AbstractContainer中定义了一个抽象方法start,这个方法在容器启动时被调用。

任务容器的执行流程如下:当任务容器被启动后,它会按照任务生命周期的每个阶段进行执行。这是单个数据任务的调度过程,通常依赖数据任务调度DAG实现。尽管开源的DataX调度功能较为基础。

Apollo 8.0 配置参数读取源码解析:以 Planning 模块为例

目录

在本篇讨论中,我们将剖析 Apollo 8.0 配置参数的读取过程,以 Planning 模块为例进行深入探讨。

1. 配置参数分类

了解 Apollo 中各模块的启动机制,主要通过主文件 mainboard 编译生成的可执行文件以及动态链接库的加载实现。Planning 模块的 DAG 文件 (apollo/modules/planning/dag/planning.dag) 指定了模块的动态链接库和单个组件 PlanningComponent 的配置。

配置参数分为两类:基于 ProtoBuf 的参数和 gflags 命令行参数。Planning 模块的 ProtoBuf 配置文件为 (apollo/modules/planning/conf/planning_config.pb.txt),与之对应的 ProtoBuf 接口文件为 (apollo/modules/planning/proto/planning_config.proto)。而 gflags 命令行参数配置文件为 (apollo/modules/planning/conf/planning.conf)。

1.1 ProtoBuf 参数

ProtoBuf 参数通过 module_config.components.config.config_file_path 指定配置文件路径,文件中的参数在组件初始化时被读入 ProtoBuf 对象。

1.2 gflags 命令行参数

gflags 参数通过 module_config.components.config.flag_file_path 指定,文件中的命令行参数在初始化时由 gflags 解析。

2. 配置参数读取流程

主入口文件 (apollo/cyber/mainboard/mainboard.cc) 的 main 函数负责加载 DAG 文件并启动模块。解析命令行参数、读取 DAG 文件、执行模块加载逻辑。

2.1 加载 DAG 文件

解析命令行参数形成 ModuleArgument,用于存储参数信息。执行主流程时,ModuleController 负责加载所有模块,并处理模块组件的注册、实例化和初始化。

2.2 读取配置参数

ModuleController 通过 LoadModule 方法读取模块配置,具体步骤涉及读取 ProtoBuf 参数和 gflags 命令行参数。

3. 总结

本文通过分析 Planning 模块的配置读取过程,清晰展示了 Apollo 8.0 中配置参数的完整读取流程。通过理解这一过程,开发者能够更深入地掌握 Apollo 的模块启动和配置机制。

Python 结巴分词(jieba)源码分析

本文深入分析Python结巴分词(jieba)的源码,旨在揭示其算法实现细节与设计思路,以期对自然语言处理领域感兴趣的朋友提供有价值的参考。经过两周的细致研究,作者整理了分词算法、实现方案及关键文件结构的解析,以供读者深入理解结巴分词的底层逻辑。

首先,分词算法涉及的核心技术包括基于Trie树结构的高效词图扫描、动态规划查找最大概率路径和基于HMM模型的未登录词处理。Trie树用于生成句子中所有可能成词情况的有向无环图(DAG),动态规划则帮助在词频基础上寻找到最优切分组合,而HMM模型则通过Viterbi算法处理未在词库中出现的词语,确保分词的准确性和全面性。

在结巴分词的文件结构中,作者详细介绍了各个关键文件的功能与内容。dict.txt作为词库,记录着词频与词性信息;__init__.py则是核心功能的入口,提供了分词接口cut,支持全模式、精确模式以及结合最大概率路径与HMM模型的综合模式。全模式下,会生成所有可能的词组合;精确模式通过最大概率路径确定最优分词;综合模式则同时考虑概率与未登录词,以提高分词效果。

实现细节方面,文章通过实例代码解释了全模式、精确模式及综合模式的分词逻辑。全模式直接输出所有词组合;精确模式基于词频和最大概率路径策略,高效识别最优分词;综合模式利用HMM模型处理未登录词,进一步提升分词准确度。通过生成的DAG图,直观展示了分词过程。

结巴分词的代码实现简洁而高效,通过巧妙的算法设计和数据结构应用,展示了自然语言处理技术在实际应用中的强大能力。通过对分词算法的深入解析,不仅有助于理解结巴分词的功能实现,也为自然语言处理领域的研究与实践提供了宝贵的洞察。

Local optimization in compiler

深入解析:编译器中的局部优化策略

编译器的工作流程通常分为front end、优化阶段和back end,本文将聚焦于关键的优化阶段,尤其关注局部优化那一部分,它与传统的前端后端处理方式有所不同。在编译旅程的这一阶段,源代码已经被转化成了控制流图(Control Flow Graph,CFG),它以一种语义等价的方式展现程序的控制流。

CFG基础与局部优化

在CFG中,每个节点代表一个基本块(Basic Block),边则表示控制流的转移,无论是无条件的还是条件性的。基本块的特点是每个语句顺序执行且单进单出,这意味着内部的跳转语句是不存在的,只能从第一句开始执行,最后通过边离开。在优化过程中,局部优化和全局优化的划分标准是优化策略是否跨越基本块边界。局限于基本块内部的操作称为局部优化,反之则是全局优化。

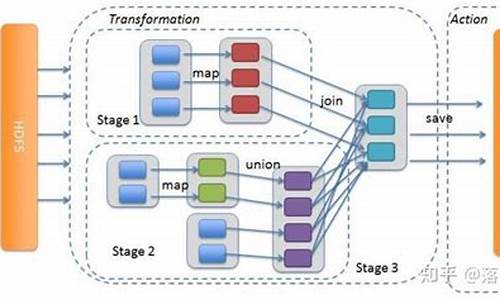

DAG优化:结构的力量

局部优化的一种常见策略是基于DAG(有向无环图)的方法。在基本块内部,代码逻辑可以用图的形式表示,形成一个DAG,其中输入是叶子节点,运算结果作为父节点,最终输出为根节点。这样的结构为查找并应用算术等价变换提供了有力的工具,比如Arithmetic Identities中的z + 0 = 0 + z = z等。

剔除无用代码:Dead Code Elimination (DCE)

DCE通过检测和消除源代码中的冗余代码来提升效率。例如,代码段中d = a - d实际上可以简化为只保留a - d,前提是d的值不会被其他代码依赖。在这个过程中,识别哪些节点是“死”节点至关重要,如d节点,它可以被删除而不会影响后续计算。

窥孔优化:动态优化的艺术

窥孔优化是一种窗口策略,它能在程序的局部范围内查找并替换优化模式。例如,通过移除多余的load和store操作,或者在branch指令中合并语句,减少了指令数量。窥孔优化的灵活性使其能够在基本块内部和复杂的控制流结构上发挥作用。

寄存器优化:性能提升的关键

局部寄存器分配是优化性能的利器。将局部变量映射到寄存器可大幅提高访问速度,但寄存器资源有限。当寄存器满载时,spilling策略会将最早使用的寄存器数据存入堆栈,腾出空间。通过spilling,程序能够更好地平衡寄存器使用和性能优化。

以上的局部优化策略,无论是DAG优化,还是死代码消除和寄存器管理,都是编译器优化过程中不可或缺的环节,它们共同致力于提升代码的效率和执行性能,让程序在运行时更加高效。