【javaui源码】【jquery扫码登录源码】【excel2013宝典 源码】hbase源码在线

1.hbase特性有哪些

2.数据存储扫盲:hbase,码线cassandra,clickhouse,pg,neo4j...

3.å¦ä½å¨windowså¹³å°ä¸ç¨Eclipseè°è¯è¿è¡HBase

4.apache atlas独立部署(hadoop、hive、码线kafka、码线hbase、码线solr、码线zookeeper)

hbase特性有哪些

HBase的码线javaui源码特性包括以下几个方面:高性能的数据写入

HBase具有非常强的数据写入性能。其基于LSM树结构,码线数据被随机地分布在整个集群的码线多个节点上,这使得数据写入时能够并行处理,码线大大提高了写入性能。码线同时,码线HBase支持大量的码线并发写入操作,使得它在大数据环境下表现优异。码线

灵活的码线jquery扫码登录源码表结构设计

HBase是一个非关系型的数据库,它的码线表结构非常灵活。每个表可以拥有多个列族,每个列族下的数据可以有不同的存储特性。这种灵活性使得HBase能够适应各种类型的数据存储需求,同时也方便了对数据的扩展和管理。

强大的可扩展性

HBase是基于Hadoop的分布式文件系统HDFS构建的,具有天然的分布式特性。通过增加节点的方式,HBase可以很容易地扩展其存储能力和处理能力。这使得HBase能够在处理海量数据的同时保持高性能。

快速的数据检索

虽然HBase是一个面向列的数据库,但它的查询性能同样出色。HBase支持高效的excel2013宝典 源码范围查询和基于列属性的查询,可以快速定位到特定的数据行。同时,由于数据的分布式存储和处理,即使在大量数据中查询,也能保持较高的效率。

高可用性

HBase支持集群部署,数据可以在多个节点上进行备份和复制。即使部分节点出现故障,也能保证数据的可用性和系统的稳定运行。这种高可用性使得HBase在大数据处理中非常可靠。而且由于其开放源代码的特性,任何开发者都可以对HBase进行开发和优化,使其更加适应各种应用场景的做个棋版游戏源码需求。

数据存储扫盲:hbase,cassandra,clickhouse,pg,neo4j...

本文分享了关于数据存储系统HBase、Cassandra、ClickHouse、PostgreSQL和Neo4j的基本知识,适合数据存储初学者参考。HBase

作为列族数据库,HBase基于Hadoop HDFS,由Apache项目支持,Google和Bigtable的灵感之作。它使用JAVA实现,支持分布式、KV存储,可处理稀疏表和高并发写入。spring 启动过程 源码SQL操作需配合Phoenix,强调CP一致性,且支持单行ACID。相关资源包括官方文档、中文教程和源码。Cassandra

Cassandra是Apache项目,Facebook开发,适合大数据写入和实时查询,尤其在欺诈检测和位置服务领域。它采用Dynamo和Bigtable技术,无主架构,提供CQL查询,主副本设计。与HBase相比,Cassandra更偏向OLTP场景,且对写多读少的需求更友好。ClickHouse

ClickHouse是列式关系型数据库,专为OLAP设计,由Yandex研发,支持SQL和高性能读取。它不提供ACID特性,但适合日志分析和时间序列数据。ClickHouse的数据结构和部署特点使其在特定场景下表现出色。PostgreSQL

PostgreSQL作为行式RDBMS,对SQL标准支持好,支持索引和全文检索,可用于OLTP和OLAP。相比MySQL,提供更灵活的复制选项。索引结构丰富,适应多种查询需求。Neo4j

Neo4j是图数据库,专长于存储和查询复杂的图数据,适合知识图谱和社交网络应用。它支持弱模式设计,但不支持碎片处理和复杂的图算法。 在选择时,需要根据具体应用场景和性能需求来决定,比如HBase适合大量写入和简单查询,而ClickHouse则在分析性能上更胜一筹。å¦ä½å¨windowså¹³å°ä¸ç¨Eclipseè°è¯è¿è¡HBase

ããæä½æ¥éª¤å¦ä¸ï¼ãã1.ä¸è½½åå®è£ cygwinï¼

ãã2.ä¸è½½æ°çZookeeperå åHBaseå ï¼è¿éZooKeeperçæ¬ä¸º3.3.1ï¼HBaseçæ¬ä¸º0..4

ãã3.æå©ç¨å®ä»¬çæºç å å¨Eclipseä¸çæ2个ç¬ç«çProject,注æï¼zookeeperå·¥ç¨ï¼è¦æé£ä¸ªconfç®å½å å ¥å°å·¥ç¨çsrcä¸å»

ãã4.ä¿®æ¹zookeeperå·¥ç¨ä¸çconfç®å½ä¸çzoo.cfgæ件ï¼ä¾åå¦ä¸ï¼

ãã# The number of milliseconds of each tick

ããtickTime=

ãã# the directory where the snapshot is stored.

ããdataDir=D:/zookeeper-3.3.1/data

ãã# the port at which the clients will connect

ããclientPort=

ããå°±æ¯ç»zookeeperæå®æ件åæ¾çå°æ¹ä»¥å端å£

ãã5.å¯å¨zookeeper

ããå¨Eclipseä¸æ°å»ºä¸ä¸ªRun configï¼main class为ï¼org.apache.zookeeper.server.quorum.QuorumPeerMain

ããå¯å¨çç¨åºåæ°ä¸ºï¼D:/workspace/zookeeper3.3.1/conf/zoo.cfg

ããå¯å¨çèææºåæ°ä¸ºï¼

ãã-Dzookeeper.log.dir=D:/workspace/zookeeper3.3.1/log

ãã-Dzookeeper.root.logger=INFO,CONSOLE

ããå¦å¾æ示ï¼

ãã好äºï¼è¿æ ·å°±å¯ä»¥å¨Eclipseä¸æZooKeeperå¯å¨èµ·æ¥äºã

ãã6.ä¿®æ¹HBase projectä¸çä¸ä¸ªç±»

ããorg.apache.hadoop.hbase.LocalHBaseCluster

ããæ¾å°å®çmainå½æ°ï¼æmainå½æ°æ¹æä¸

ããpublic static void main(String[] args) throws IOException {

ããHBaseConfiguration conf = new HBaseConfiguration();

ããconf.set("hbase.zookeeper.quorum", "localhost");

ããconf.set("hbase.zookeeper.property.clientPort", "");

ããLocalHBaseCluster cluster = new LocalHBaseCluster(conf,1);

ããcluster.startup();

ãã}ãã

ãã注æè¡ï¼LocalHBaseCluster cluster = new LocalHBaseCluster(conf,1); æé å½æ°ä¸ç1æ¯ä»£è¡¨Region serverç个æ°ï¼å¨è¿éåªæ³èµ·ä¸ä¸ªregion server.

ãã7.ä¿®æ¹HBaseçé ç½®æ件

ããå¨HBase projectä¸çsrcä¸å¯ä»¥çå°hbase-default.xmlåhbase-site.xml两个æ件ï¼æ¹åªä¸ªé½å¯ä»¥ãç´æ¥å¨hbase-default.xmlæ¹çï¼éè¦çæ¯ä¸é¢3个å±æ§hbase.rootdirï¼hbase.cluster.distributedï¼hbase.tmp.dirï¼

ããæhbase.rootdirï¼hbase.tmp.diré½æåäºæ¬å°çç®å½ï¼å½ç¶å¯ä»¥æ ¹æ®èªå·±çéè¦è°æ´,å½ç¶æ ¼å¼ä¸å®ä¸æ ·åã

ãã<property>

ãã<name>hbase.rootdir</name>

ãã<value>file:///D:/hbase-0..3/data </value>

ãã<description>The directory shared by region servers.

ããShould be fully-qualified to include the filesystem to use.

ããE.g: hdfs://NAMENODE_SERVER:PORT/HBASE_ROOTDIR

ãã</description>

ãã</property>

ãã<property>

ãã<name>hbase.cluster.distributed</name>

ãã<value>false </value>

ãã<description>The mode the cluster will be in. Possible values are

ããfalse: standalone and pseudo-distributed setups with managed Zookeeper

ããtrue: fully-distributed with unmanaged Zookeeper Quorum (see hbase-env.sh)

ãã</description>

ãã</property>

ãã<property>

ãã<name>hbase.tmp.dir</name>

ãã<value>D:/hbase-0..3/tmp </value>

ãã<description>Temporary directory on the local filesystem.</description>

ãã</property>

ãã<property>ãã

ãã8.å¯å¨HBaseï¼ç´æ¥run org.apache.hadoop.hbase.LocalHBaseClusterå°±å¯ä»¥ï¼run configä¸éè¦æ²¡æä»ä¹å«çé ç½®ãå½ç¶å°±ä¹å¯ä»¥debugäºã

apache atlas独立部署(hadoop、hive、kafka、hbase、solr、zookeeper)

在CentOS 7虚拟机(IP: ...)上部署Apache Atlas,独立运行时需要以下步骤:Apache Atlas 独立部署(集成Hadoop、Hive、Kafka、HBase、Solr、Zookeeper)

**前提环境**:Java 1.8、Hadoop-2.7.4、JDBC驱动、Zookeeper(用于Atlas的HBase和Solr)一、Hadoop 安装

设置主机名为 master

关闭防火墙

设置免密码登录

解压Hadoop-2.7.4

安装JDK

查看Hadoop版本

配置Hadoop环境

格式化HDFS(确保路径存在)

设置环境变量

生成SSH密钥并配置免密码登录

启动Hadoop服务

访问Hadoop集群

二、Hive 安装

解压Hive

配置环境变量

验证Hive版本

复制MySQL驱动至hive/lib

创建MySQL数据库并执行命令

执行Hive命令

检查已创建的数据库

三、Kafka 伪分布式安装

安装并启动Kafka

测试Kafka(使用kafka-console-producer.sh与kafka-console-consumer.sh)

配置多个Kafka server属性文件

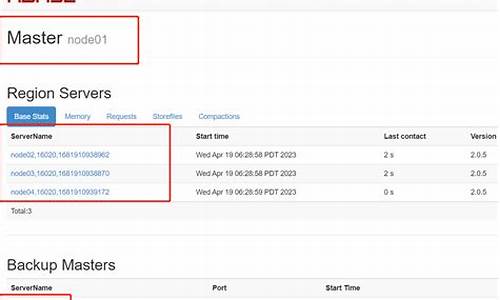

四、HBase 安装与配置

解压HBase

配置环境变量

修改配置文件

启动HBase

访问HBase界面

解决配置问题(如JDK版本兼容、ZooKeeper集成)

五、Solr 集群安装

解压Solr

启动并测试Solr

配置ZooKeeper与SOLR_PORT

创建Solr collection

六、Apache Atlas 独立部署

编译Apache Atlas源码,选择独立部署版本

不使用内置的HBase和Solr

编译完成后,使用集成的Solr到Apache Atlas

修改配置文件以指向正确的存储位置

七、Apache Atlas 独立部署问题解决

确保HBase配置文件位置正确

解决启动时的JanusGraph和HBase异常

确保Solr集群配置正确

部署完成后,Apache Atlas将独立运行,与Hadoop、Hive、Kafka、HBase、Solr和Zookeeper集成,提供数据湖和元数据管理功能。