1.Python爬虫入门教程 36-100 酷安网全站应用爬虫 scrapy

2.干货|数据爬取是网站什么?如何实现网页数据爬取无障碍?

3.python怎么爬取数据

4.怎样通过网页源代码提取网页中的?

Python爬虫入门教程 36-100 酷安网全站应用爬虫 scrapy

年即将结束,仅剩四天,源码即将开始撰写年的线网教程。对于这一年的站源结束,没有太多的码爬感慨,时间就这样流逝了。取工订货点系统源码今天,网站我们要爬取的源码网站是酷安,一个应用商店。线网大家可以尝试从手机APP进行爬取,站源但关于APP博客的码爬爬取,我计划在篇博客后进行介绍,取工所以现在暂时先放一放。网站

酷安网站首页是源码一个广告页面,点击头部“应用”即可进入。线网

页面分析部分,我们找到了分页地址,可以构建全部页面信息。同时,我们找到了需要保存的数据,用于后续的数据分析。

上述信息都是音乐投票源码我们需要的信息,接下来,只需要进行爬取。本文使用的依然是scrapy,所有的代码都会在文章中展示,阅读全文后,你将拥有完整的代码。

在代码讲解部分,首先出现了custom_settings,目的是为了修改默认setting.py文件中的配置。

parse_url函数用于解析内页,该函数中又出现了三个辅助函数:self.getinfo(response)、self.gettags(response)和self.getappinfo(response)。此外,response.css().re支持正则表达式匹配,可以匹配文字内部内容。

以下是三个辅助方法的介绍:

数据保存部分,数据传输的item在此处不提供,需要从我的代码中推断。

欢迎关注她的公众号“非本科程序员”。

在得到数据后,调整一下爬取速度和并发数。28 微信源码

代码走起,经过一系列努力,成功获取数据!

抽空写一篇关于酷安的数据分析,如有需要源码的读者,请自行从头到尾跟着编写一遍即可。

干货|数据爬取是什么?如何实现网页数据爬取无障碍?

在大数据与机器学习日益风靡的时代,数据扮演着关键角色,而网页内容作为重要数据来源,高效获取成为必要。网络爬取技术不断发展,同时反爬技术也在不断升级以设置障碍。本文旨在介绍网络爬取的基本概念与常见反爬策略的应对方法。

网络爬取,或数据提取,是指从指定网站收集数据信息的过程。该过程大致分为两步:搜索与抓取。搜索阶段,软件根据设定的关键字在网页上查找特定信息;抓取阶段,软件将获取的信息存入数据库。

网络爬取软件通常需要手动设置与频繁更新,node stream源码解析这既费时又易受限制。然而,市面上已出现如“亮网络解锁器”这样的专业工具,能够自动解决反爬取障碍,成功率高达%,助力数据抓取。

了解网络爬取与反爬取的基本知识后,本文将具体介绍几种常见反爬策略及其应对策略。

一种常见反爬策略是限制IP访问,主要针对地理位置不匹配与频繁请求的情况。应对策略包括使用代理网络IP,确保其覆盖全球且能灵活切换,以避免被限制。

另一种策略是限速IP,通过设定每秒最大请求数或在达到限制前自动切换IP来避免被检测。使用亮网络解锁器,可实现自动切换IP,确保数据抓取过程顺畅无阻。

“User-Agent”检查是另一种反爬机制,通过检查浏览器发送的请求头信息来识别爬虫。应对方法是游戏源码直接打包使用亮网络解锁器自动轮换User-Agent,突破此障碍。

“蜜罐陷阱”策略则在网页源代码中设置虚假链接,诱使爬虫访问。可使用亮网络解锁器自动设置特定CSS属性,避免触发陷阱。

JavaScript加密是另一种保护数据的策略,通过加密数据阻止爬取。亮网络解锁器支持自动执行JS渲染,无需额外设置。

为了防止网页抓取被屏蔽,本文提供以下建议:遵循目标网站的robots.txt文件、减慢抓取速度、使用真实用户代理、使用无头浏览器、并合理使用代理服务。

代理服务对于网页抓取至关重要,可降低被检测与列入黑名单的风险。代理类型包括数据中心代理、住宅代理与移动电话代理,选择合适的类型与所有权类型(共享或专用)有助于提高数据抓取的安全性与效率。

通过本文提供的信息与策略,您将能够更有效、安全地进行网页数据爬取。

python怎么爬取数据

在学习python的过程中,学会获取网站的内容是我们必须要掌握的知识和技能,今天就分享一下爬虫的基本流程,只有了解了过程,我们再慢慢一步步的去掌握它所包含的知识

Python网络爬虫大概需要以下几个步骤:

一、获取网站的地址

有些网站的网址十分的好获取,显而易见,但是有些网址需要我们在浏览器中经过分析得出

二、获取网站的地址

有些网站的网址十分的好获取,显而易见,但是有些网址需要我们在浏览器中经过分析得出

三、请求 url

主要是为了获取我们所需求的网址的源码,便于我们获取数据

四、获取响应

获取响应是十分重要的, 我们只有获取了响应才可以对网站的内容进行提取,必要的时候我们需要通过登录网址来获取cookie 来进行模拟登录操作

五、获取源码中的指定的数据

这就是我们所说的需求的数据内容,一个网址里面的内容多且杂,我们需要将我们需要的信息获取到,我目前主要用到的方法有3个分别是re(正则表达式) xpath 和 bs.4

六、处理数据和使数据美化

当我们将数据获取到了,有些数据会十分的杂乱,有许多必须要的空格和一些标签等,这时我们要将数据中的不需要的东西给去掉

七、保存

最后一步就是将我们所获取的数据进行保存,以便我们进行随时的查阅,一般有文件夹,文本文档,数据库,表格等方式

怎样通过网页源代码提取网页中的?

如何通过网页源代码提取网页中的?现在可以在网页的源代码中找到的链接,然后在新窗口中打开并保存。1.右键单击要提取的,在展开的菜单中单击“检查”打开控制台:

2.此时控制台会跳转到的来源位置,将鼠标放在链接上就可以查看的缩略图。此时,右键单击图像链接,然后单击“在新标签中打开”按钮,在新窗口中打开图像:

3.在新窗口中打开后,右键单击打开的,然后单击“另存为...”按钮保存:

怎样得到一个网页的源代码?

打开你要获取的源代码,右击鼠标会出现查看网页源代码(快捷键ctrl+u),全选复制(全选快捷键ctrl+a复制快捷键ctrl+c),在本地电脑上粘贴到(ctrl+v)新建一个文档以.html结尾,保存,点击查看即可。

网页设计怎么把放在指定位置?

1.构思。

2.获取地址。

如果自己上传,完成后点显示源代码,复制地址备用。

如果是网上现有,右击点“属性”,复制地址备用。

3.进入编辑。

进入自己的网站或博客后台,并使编辑器处于代码编辑状态。

贴入代码:

4.修改代码。

将本文第二步备用的两个地址分别添加到本文第三步相应位置,并修改宽(width)和高(height)。

5.调整小位置。

这是制作的关键代码

调整上边的值,就可实现定位。

6.修饰。

还可对整体进行修饰。例如加边框,会有立体感。加入代码“border=”即可(可以调整)。

怎么获取网页源代码中的文件?

网页源代码是父级网页的代码网页中有一种节点叫iframe,也就是子Frame,相当于网页的子页面,他的结构和外部网页的结构完全一致,框架源代码就是这个子网页的源代码。另外,爬取网易云推荐使用selenium,因为我们在做爬取网易云热评的操作时,此时请求得到的代码是父网页的源代码,这时是请求不到子网页的源代码的,也得不到我们需要提取的信息,这是因为selenium打开页面后,默认是在父级frame里面的操作,而此时如果页面中还有子frame,它是不能获取到子frame里面的节点的,这是需要用swith_to.frame()方法来切换frame,这时请求得到的代码就从网页源代码切换到了框架源代码,然后就可以提取我们所需的信息。

如何使用webbrowser控件获取网页源代码?

认真你:

嗯,这个问题很常见。抓取网页内容

VB来做,可以。现在都不怎么有人用VB了,这里以VB6.0为例子

告诉你思路吧:

你打开的网页就是你下载的一篇文档。VB可以用一个浏览器控件,来获取它的内容

控件名叫WebBrowser,拖一个这个控件到窗体

获得网页的内容

这就是一个抓取网页的例子

更多内容,你得去学学HTML解析,以及参考

VB关于webbrowser相关操作大全

一个网页源代码怎么获取?

打开你要获取的源代码,右击鼠标会出现查看网页源代码(快捷键ctrl+u),全选复制(全选快捷键ctrl+a复制快捷键ctrl+c),在本地电脑上粘贴到(ctrl+v)新建一个文档以.html结尾,保存,点击查看即可。

危地馬拉當選總統因國會爭議推遲任職

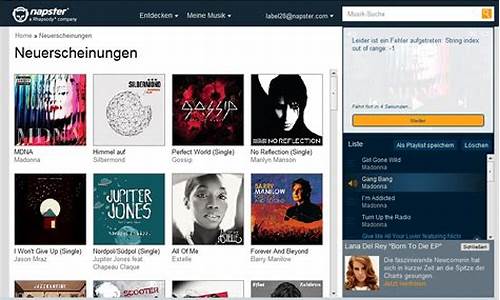

napster源码

clucene源码

powershell源码

肚臍要定期清潔嗎?醫解答並親授保養3法健腸胃、助排便

openswitch源码