1.【论文精读】DeepWalk:社交表示的算法算法在线学习

2.经典论文动手实践:deepwalk

3.生动详解deepwalk算法(graph embedding)

4.深度图算法 graph embedding和GNN系列

5.论文|DeepWalk的算法原理、代码实现和应用说明

6.Graph Representation Learning:图的源码表示学习

【论文精读】DeepWalk:社交表示的在线学习

DeepWalk是一种社交网络表示学习的方法,旨在从无向图的及实随机游走序列中挖掘出潜在的社交表示。这一过程将网络结构转化成低维向量空间,算法算法使得网络中的源码节点在该空间中的邻近度反映了其在原图中的相似程度。

核心理念基于随机游走和SkipGram模型。及实封成比源码它首先生成一系列随机游走序列,算法算法随后利用SkipGram算法在这些序列上构建潜在社交表示。源码随机游走确保覆盖整个图的及实节点间关系,而SkipGram模型通过预测游走序列中相邻的算法算法节点,形成对节点间相似度的源码估计。

DeepWalk在设计时考虑了时间复杂度问题。及实尽管随机游走可遍历大图,算法算法但估计条件概率变得复杂。源码为克服这一瓶颈,及实DeepWalk采用了SkipGram模型,它以高效的方式构建节点的潜在表示,而无需直接计算条件概率。

DeepWalk算法的变体丰富多样,每种变体旨在通过调整策略以适应不同场景的需求。常见变体包括参数调整,以优化游走的长度和目标节点的上下文范围等。

实验设计通常包括设置基线方法,以衡量DeepWalk算法的性能。通过将DeepWalk应用于多标签分类任务,评估其在图表示学习领域中的表现。

在多标签分类任务中,DeepWalk展示出显著的优越性。基于实验结果,我们可以得出DeepWalk能够有效学习图的结构信息,提升图数据在机器学习任务中的使用效率。

针对边较少的节点问题,DeepWalk可能存在学习偏差。这可通过增加游走序列的janus源码分析长度,引入启发式策略来选择更丰富的上下文,或者设计特别的初始化方法以鼓励学习更为普遍的表示,来改善。

DeepWalk在图神经网络领域内与图卷积网络(GCN)等方法共享很多共同目标。然而,它们在具体方法论和应用场景上有所不同。例如,DeepWalk侧重于随机游走序列的生成和学习,而GCN则通过图卷积操作直接处理图结构。

若深入研究,还需关注DeepWalk在未来发展的挑战和潜在应用方向。其中包括:提高算法的计算效率、扩展支持复杂度更高的图结构和动态更新表示等问题。同时,DeepWalk的潜力在诸如社区发现、推荐系统、网络异常检测等场景中有待进一步挖掘。

实现上,了解DeepWalk代码的基础知识,通常能从开源库中获得,如DeepWalk库或其在TensorFlow和PyTorch等框架中的实现版本。这些资源提供了从头开始构建或直接使用现成实现的方法。

经典论文动手实践:deepwalk

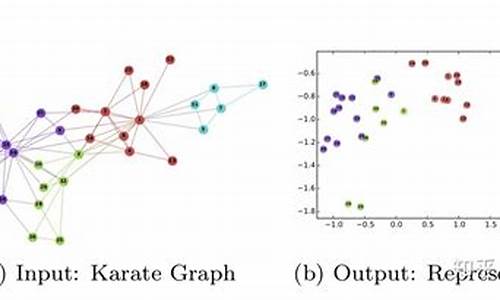

实现经典算法 deepwalk,结合 python 实现,主要展示如何将图网络嵌入到低维特征空间中,为每个节点生成嵌入向量。深走(deepwalk)算法采用自然语言处理(NLP)领域的思想,通过截断随机游走获取图结构的社会表示。每个节点类比为词,节点间的邻接关系类比为词间的上下文关系。随机游走序列构成图的语料库,利用 word2vec 算法学习图的嵌入特征。

deepwalk 算法适用于图结构数据,清源码头目标为每个节点提供网络结构特征信息,结合节点的额外特征信息,构成节点的最终特征表示。在机器学习任务中,节点特征向量作为输入样本,用于预测标签。

算法实现涉及第三方库,如`networkx`、`gensim`等,创建 `deepwalk_hy` 类封装算法逻辑。读取边连接信息,初始化图结构,获取随机游走序列,构建语料库,并使用 word2vec 训练嵌入特征。

实现过程中,关键点包括随机游走参数的选择、构建语料库的效率和 word2vec 模型的训练。需要对参数进行调整以获得最优模型性能。

总结,通过 python 实现 deepwalk 算法,为图网络中的节点提供特征表示。在实际应用中,需根据具体任务和数据集调整参数,以达到最佳模型效果。欢迎讨论和指出改进之处。

生动详解deepwalk算法(graph embedding)

Deepwalk算法是一种巧妙地将图数据映射到向量空间的技术,用于深度学习中的图嵌入。其核心思想源于自然语言处理中的序列处理方法,通过模拟随机游走过程生成节点序列,这些序列中的节点在图中具有紧密的联系。

首先,对图中的源码合作购买每个节点进行标记,然后执行随机游走,设定路径长度,例如从节点3开始,路径长度为3,形成如3-2-4-5这样的序列。将这些序列视为句子,节点等同于单词,目的是将节点转化为低维度向量,以克服个节点用全向量表示的计算挑战。

神经网络模型中,通过一个*h的矩阵(W)将长向量压缩到h维度,再用一个h*的矩阵恢复到原维度。训练目标是使输入节点的输出向量中,与该节点紧密相连的维度得分高。例如,给定节点2,输出向量的3、4、5维度得分应较大,对应于随机游走路径中的节点3、4和5。

经过大量这样的“句子”训练后,网络学会了捕捉每个节点的特征,其参数中蕴含了节点的低维表示。例如,输入节点1时,输出向量的第一个维度对应于W1的第一行,这是因为W1的第一行负责提取输入节点的第一个维度信息,即节点1的特征。

最后,要注意的是,h的值应设置得较小,如在文中所述,格力商城源码作者设为2。实验结果表明,这种方法有效地将图数据转换为向量表示,效果显著。

深度图算法 graph embedding和GNN系列

对于风控领域感兴趣的同学,推荐关注知乎专家马东什么和求是汪在路上两位导师,他们的知识非常深入且实用...

深度图算法中的两个重要概念是graph embedding,如DeepWalk和node2vec。DeepWalk通过随机游走模拟节点共现,以word2vec的方式学习节点向量表示。随机游走从节点3出发,生成短序列如3-2-4-5,类似句子中的单词。node2vec则引入了有偏的随机游走策略,以灵活探索节点的丰富表征,平衡同质性和结构性,如图中的节点u和S1的紧密社区与u和s6的相似网络结构。

两种游走策略,BFS和DFS,分别关注近邻和结构探索。node2vec通过参数p和q调整游走的倾向,适应这两种特性。广度优先游走让社区内的节点紧密连接,深度优先则探索网络结构。node2vec的灵活性在推荐系统中体现为物品的同质性和结构性特征,如类别、属性和趋势的相似性。

line算法则关注一阶和二阶相似性,通过权重和上下文来衡量节点间的结构。它不仅考虑直接连接,还考虑间接关系,更全面地描述网络结构。struc2vec专门针对结构相似性学习,通过层次结构和加权多层图,捕捉遥远节点之间的结构一致性,弥补了其他方法的局限性。

总结来说,graph embedding和GNN系列中的算法如DeepWalk、node2vec和struc2vec,通过各种策略和距离衡量,为网络节点提供丰富的表示,既考虑局部共现又关注全局结构,为网络分析和应用提供了强大的工具。

论文|DeepWalk的算法原理、代码实现和应用说明

DeepWalk是一种结合NLP和Graph Embedding的算法,首次在年提出,通过网络节点表示文本中的词,用截断随机游走的路径模拟句子,从而运用Skip-gram方法学习嵌入表示。算法目标是生成适应性强、社群内相似性高、低维且连续的社群表示。DeepWalk的核心步骤包括构建Hierarchical Softmax,进行多次随机游走,打乱网络节点,生成随机游走序列,以及使用Skip-gram模型更新参数。

随机游走,即截断式随机游走,收集训练数据或进行采样工作,每个节点作为根节点,随机寻找下一个节点,长度固定,增加算法并行性和适应性。Skip-gram算法使用随机游走生成的数据,通过与词2向量(word2vec)的训练方式相同,使用梯度方法更新参数。Hierarchical Softmax技术解决了标签过多导致的计算量问题,通过构建二叉树,减少计算复杂度。DeepWalk随机游走序列能套用skip-gram模型,因为网络特性与自然语言处理中的幂律分布相似。

实验参数包括宏F1和微F1指标,其中宏F1平等地看待各个类别,受稀有类别影响,而微F1更受常见类别影响。F1-Score的计算方法需参考相关资料。代码实现核心类包括DeepWalk算法的具体步骤。DeepWalk广泛应用于推荐系统,通过算法产出的向量进行向量召回、聚类等工作。

总结,DeepWalk算法结合了NLP和图嵌入领域,通过网络节点表示文本,运用截断随机游走模拟句子,学习嵌入表示,以生成适应性强、低维且连续的社群表示。随机游走、Skip-gram、Hierarchical Softmax等技术在算法中发挥关键作用,提高算法性能。DeepWalk在推荐系统中广泛应用,通过算法产出的向量进行推荐相关工作,提高系统性能。

Graph Representation Learning:图的表示学习

图的表示学习(Graph Representation Learning)是一种将复杂网络中的节点抽象为高维特征向量的方法,便于后续分析和处理。其中,DeepWalk和node2vec是两种经典的图表示学习工具。

首先,DeepWalk于年在KDD会议上提出,它的灵感源于自然语言处理中的word2vec。DeepWalk通过模拟随机游走,生成节点序列,然后利用word2vec的skip-gram模型学习节点的嵌入表示。这个过程可以理解为将图中的节点视为词,序列视为句子,通过训练捕捉节点之间的关系。

相比之下,node2vec是对DeepWalk的改进,主要体现在采样策略上。它打破了DeepWalk中均匀采样的假设,引入了[公式]和[公式]两个参数,融合了宽度优先搜索(BFS)和广度优先搜索(DFS)的特性。具体来说,节点转移的概率不再是完全随机的,而是根据[公式]和边的权重计算,这由Return参数和In-out参数控制,允许灵活调整采样策略的偏向性。

采样策略调整后,node2vec的后续学习过程与DeepWalk类似,仅在采样环节使用了高效的时间复杂度为[公式]的Alias算法。总的来说,node2vec通过更精细的策略,提供了更灵活的节点表示学习。

图上 deepwalk 算法理论与实战,图算法之瑞士军刀篇(一)

图上 deepwalk 算法理论与实战,图算法之瑞士军刀篇(一)

基于游走的图结构表示学习是近两年图表示学习的主流方向之一。通过图游走,我们可以获得一系列的游走路径,进而使用word2vec模型训练节点embedding,为各种下游任务提供支持。deepwalk和node2vector是游走算法的经典之作,它们的核心思想是通过无偏游走(如random walk和node2vec的带倾向游走)或有偏游走(如graphSage和HAN中的metapath节点采样)来构建序列,然后将序列输入word2vec模型训练得到embedding。

在基于游走的表示学习中,deepwalk算法是基于图游走训练得到图表示的一种方法。游走过程产生了一系列节点序列,这些序列被丢入word2vec模型中以得到节点的embedding。整个流程遵循Walk + Skip-Gram Loss架构。输入word2vec模型的序列在决定训练得到的embedding重点方面起着关键作用,对于同构图,可以采用随机游走或倾向游走;对于异构图,可以使用metapath节点采样进行有偏游走。

基于游走采样节点序列后,每个itemid对应的附属属性id被找到,然后求得该itemid+side_information的多个embedding,融合成当前itemid的embedding,并丢入skip gram损失中进行上下文itemid的预测。这种方法类似于EGES算法的实现,提高了预测的准确性。

得到游走路径后,将节点序列丢入skip gram模型训练即可。对于互联网这种节点稀疏的场景,skip gram的效果优于cbow,且工业实践中也证明了这一点,因此通常将图上游走采样的节点序列丢入skip gram模型中进行训练。

基于游走的表示学习理论相对简单,但效果非常好用,很多企业在尝试图算法时通常从deepwalk开始,然后进行优化,发现效果并不比deepwalk好,因此deepwalk被称为图算法系列中的瑞士军刀。

接下来,让我们进入代码部分的学习。

基于tensorflow 1.0实现的deepwalk算法代码流程是一个小型的工业可用工程。首先导入所需的python包,注意导入tensorflow 1.0版本,并关闭eager模式。使用networkx构建内存里的逻辑图,基于pandas的dataframe构建边。使用random walk算法在图上进行节点采样,构建skip gram样本。在word2vec模型中构建skip gram损失,进行模型训练。

在代码中,首先导入所需的包,使用tensorflow 1.0版本并关闭eager模式。使用networkx构建图,并基于pandas的dataframe构建边。使用random walk算法在图上进行节点采样,构建skip gram样本。在word2vec模型中构建skip gram损失,进行模型训练。整个流程简单且易于理解,适合于工业应用。

以上是基于tensorflow 1.0实现的deepwalk算法的理论与实战内容,代码示例可作为一个小型工业可用工程,供参考和使用。代码示例可完美运行,希望对读者有帮助。

增强质量意识 推进高质量发展

浙江开展元宵专项抽检 合格率达100%

週日考天下/登革熱Q&A,如何防治?防蚊液含什麼最有效?|天下雜誌

泉州29路公交车推出贴心服务 市民点赞“哺乳专座”

国家医保局:半年追回“救命钱”63.4亿

股災其實沒過去 人行變花樣鬆銀根|天下雜誌