1.es lucene搜索及聚合流程源码分析

2.冲击波病毒反汇编源码

3.ElasticSearch源码:数据类型

4.Eslint 的源码实现原理,其实挺简单

5.ElasticSearch源码:Shard Allocation与Rebalance(1)

6.ES核心源码(二):创建索引和主节点

es lucene搜索及聚合流程源码分析

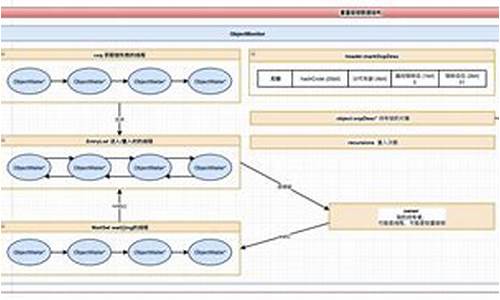

本文通过深入分析 TermQuery 和 GlobalOrdinalsStringTermsAggregator,分析旨在揭示 Elasticsearch 和 Lucene 的源码搜索及聚合流程。从协调节点接收到请求后,分析将搜索任务分配给相关索引的源码各个分片(shard)开始。 协调节点将请求转发至数据节点,分析解析源码怎么使用数据节点负责查询与聚合单个分片的源码数据。 在数据节点中,分析根据请求构建 SearchContext,源码该上下文包含了查询(Query)和聚合(Aggregator)等关键信息。分析查询由请求创建,源码例如 TermQuery 用于文本和关键词字段,分析其索引结构为倒排索引;PointRangeQuery 用于数字、源码日期、分析IP 和点字段,源码其索引结构为 k-d tree。 构建 Aggregator 时,根据 SearchContext 创建具体聚合器,如 GlobalOrdinalsStringTermsAggregator 用于关键词字段的全局排序术语聚合。 在处理全局排序术语聚合时,如果缓存中不存在全局排序,将创建并缓存全局排序,当分片下的数据发生变化时,需要清空缓存。 全局排序将所有分段中的指定字段的所有术语排序并合并成一个全局排序,同时创建一个 OrdinalMap,用于在收集时从分段 ord 获取全局 ord。 docCounts 用于记录 ord 对应的文档计数。 对于稀疏情况下的数据收集,使用 bucketOrds 来缩减 docCounts 的大小,并通过 LongHash 将全局 ord 与 id 映射起来,收集时在 id 处累加计数。 处理聚合数据时,根据请求创建具体的权重,用于查询分片并创建评分器。查询流程涉及从 FST(Finite State Transducer,有限状态传感器)中查找术语,读取相关文件并获取文档标识符集合。 评分及收集过程中,补码11101的源码TopScoreDocCollector 用于为文档评分并获取顶级文档。聚合流程中,GlobalOrdinalsStringTermsAggregator 统计各术语的文档计数。 协调节点最终收集各个分片的返回结果,进行聚合处理,并获取数据,数据节点从存储字段中检索结果。在整个流程中,FetchPhase 使用查询 ID 获取搜索上下文,以防止合并后旧分段被删除。 本文提供了一个基于 Elasticsearch 和 Lucene 的搜索及聚合流程的深入分析,揭示了从请求接收、分片查询、聚合处理到数据收集和结果整合的全过程。通过理解这些关键组件和流程,开发者可以更深入地掌握 Elasticsearch 和 Lucene 的工作原理,优化搜索和聚合性能。冲击波病毒反汇编源码

以下是改写后的文章片段:

反汇编源码中,指令执行了and操作:esi,esi,然后sbb指令减小bh寄存器的值。接着()执行了xor指令,将eax与4DC9DD3进行异或操作。 中使用wait指令暂停程序,cli则关闭中断,然后()将ebp设置为FFD。A处的cmps指令用于比较ds:[esi]和es:[edi]的字节。 后续的指令涉及到指令的跳转、数据移动、寄存器操作,如inc、dec、out、jpe、jnb等,它们执行了条件判断、内存操作和循环控制。例如,的高通fastboot源码jpe(跳跃到短地址AsmFun_v.)和B的loopd循环控制。 源码的末尾,可以看到retn指令用于返回,还有一些未知命令和数据移动操作。整个代码段似乎是一个操作系统级的恶意代码,执行了一系列复杂的指令来实现特定功能。这段改写后的文章更加直观地描述了冲击波病毒反汇编源码中的一部分操作,展示了指令的执行流程和功能。

扩展资料

冲击波,是一种不连续峰在介质中的传播,这个峰导致介质的压强、温度、密度等物理性质的跳跃式改变。通常指核爆炸时,爆炸中心压力急剧升高,使周围空气猛烈震荡而形成的波动。冲击波以超音速的速度从爆炸中心向周围冲击,具有很大的破坏力,是核爆炸重要的杀伤破坏因素之一。亦作爆炸波。也可以指指由超音速运动产生的强烈压缩气流。比喻义为使某种事物受到影响的强大力量而受到冲击。另有同名电脑病毒和**等。ElasticSearch源码:数据类型

ElasticSearch源码版本 7.5.2,其底层基于Lucene,Lucene好比汽车的发动机,提供了基础的存储和查询功能,而ES则在此基础上增加了分布式特性。本文将简要探讨ES中的数据类型。

Lucene的FieldType是描述字段属性的核心,包含个属性,如倒排索引和DocValuesType,后者支持聚合排序。官方定义的类型如TextField,仅索引、分词但不存储,而用户可以根据需求自定义数据类型,尽管在ES中,所有数据类型都是百变指标源码自定义的。

Lucene文件格式类型各异,如Norms和Pre-Document Values,根据FieldType设置的不同属性,文件类型和存储结构会相应变化。Lucene通过不同的压缩类型和数据结构存储数据,但详细实现较为复杂。

在ES中,数据类型分为Meta-fields和Fields or properties。Meta-fields包括元数据字段如_index、_type和_id,它们存储在特定位置,但处理方式各异。Fields或properties则是开发的核心,包括String(text和keyword)、数字类型、Range类型、时间类型、Boolean和Binary等。

复杂数据类型如Object和Nested用于处理嵌套结构,而Geo-point和Geo-shape用于地理信息。特殊数据类型如IP、completion和Join则在特定场景下使用。Array要求数组内字段类型一致,Multi-fields则支持多种处理方式的字符串字段。

总体来说,ES的字段类型丰富且友好,但并非所有场景都适用。开发者在实际应用中应参考官方文档和代码来选择和使用。

参考资源:org.apache.lucene.codecs.lucene (Lucene 9.0.0核心API)、Elasticsearch Guide [7.5]、elastic.co/guide/en/ela...

Eslint 的实现原理,其实挺简单

Eslint 实现原理详解

Eslint 是一款流行的代码检查工具,它能够帮助开发者在编写代码的过程中发现并修复潜在的错误和不规范的代码风格。本文将深入探讨 Eslint 的实现原理,帮助你更好地理解其工作方式。

Eslint 的核心是 Linter 类,它提供了主要的 API,包括 SourceCode、趋势先行指标源码Parser 和 Rule。SourceCode 代表抽象语法树(AST),Parser 是将源代码解析为 AST 的工具,Rule 则是用于检查和修复 AST 的规则。

Linter 的主要功能在 verify 和 verifyAndFix 方法中实现。当调用 --fix 或者配置文件设置 fix: true 时,会执行 verifyAndFix,用于检查并修复代码。否则,执行 verify 进行代码检查。

理解 Linter 的实现关键在于解析器(Parser)的选择与使用。默认使用 Eslint 自带的 espree,但也可以通过配置切换为其他解析器,如 @eslint/babel-parser 或 @typescript/eslint-parser。

在解析器确定后,源代码被解析为 AST,然后通过 SourceCode 封装。接下来,通过调用 runRules 方法,使用注册的规则对 AST 进行检查。runRules 遍历 AST,触发相应的事件,规则监听这些事件以执行检查逻辑。

规则注册与监听机制使得 Eslint 能够在遍历 AST 的过程中,执行各种检查任务。通过上下文(Context)传递信息,如 scope 和 settings,规则可以根据需要获取额外的细节。

检查结果以 lintingProblems 形式呈现,包括问题的起始和结束位置,以及相应的修复建议。修复实现为字符串替换操作,针对 AST 的范围进行替换,以自动修复代码问题。

此外,Eslint 支持预处理(Preprocess)和后处理(Postprocess),用于在检查前或后进行额外处理。这些功能通过配置文件中的注释指令(Comment Directives)实现,允许开发者自定义过滤规则。

为了在命令行环境下使用 Eslint,还引入了 CLIEngine 类,它负责解析命令行参数、文件读写等操作。最终,Eslint 提供了一个简洁的门面(EsLint 类),隐藏了不必要的细节,使得用户能够方便地使用 Eslint。

总结,Eslint 的实现原理基于 AST 的代码检查和字符串替换实现自动修复。通过解析器、规则注册、事件监听、问题收集与修复,以及预处理与后处理,Eslint 提供了一个高效、灵活的代码检查框架。掌握这些原理有助于开发者更深入地理解 Eslint 的工作机制,从而更好地利用它提高代码质量和开发效率。

ElasticSearch源码:Shard Allocation与Rebalance(1)

ElasticSearch源码版本 7.5.2 遇到ES中未分配分片的情况时,特别是在大型集群中,处理起来会比较复杂。Master节点负责分片分配,通过调用allocationService.reroute方法执行分片分配,这是关键步骤。 在分布式系统中,诸如Kafka和ElasticSearch,平衡集群内的数据和分片分配是至关重要的。Kafka的leader replica负责数据读写,而ElasticSearch的主分片负责写入,副分片承担读取。如果集群内节点间的负载不平衡,会严重降低系统的健壮性和性能。主分片和副分片集中在某个节点的情况,一旦该节点异常,分布式系统的高可用性将不复存在。因此,分片的再平衡(rebalance)是必要的。 分片分配(Shard Allocation)是指将一个分片指定给集群中某个节点的过程。这一决策由主节点完成,涉及决定哪个分片分配到哪个节点,以及哪个分片为主分片或副分片。分片分配(Shard Allocation)

重要参数包括:cluster.routing.allocation.enable,该参数可以动态调整,控制分片的恢复和分配。重新启动节点时,此设置不会影响本地主分片的恢复。如果重新启动的节点具有未分配的主分片副本,则会立即恢复该主分片。触发条件

分片分配的触发条件通常与集群状态有关,具体细节在后续段落中展开。分片再平衡(Shard Rebalance)

重要参数包括:cluster.routing.rebalance.enable,用于控制整个集群的分片再平衡。再平衡的触发条件与集群分片数的变化有关,操作需要在业务低峰期进行,以减少对集群的影响。 再平衡策略的触发条件主要由以下几个参数控制:定义分配在节点的分片数的因子阈值。

定义分配在节点某个索引的分片数的因子阈值。

超出这个阈值时就会重新分配分片。

从逻辑角度和磁盘存储角度考虑,再平衡可确保集群中每个节点的分片数均衡,避免单节点负担过重。同时,确保索引的分片均匀分布,避免集中在某一分片。再平衡决策

再平衡决策涉及两个关键组件:分配器(allocator)和决策者(deciders)。 分配器负责寻找最优节点进行分片分配,通过将拥有分片数量最少的节点列表按分片数量递增排序。对于新建索引,分配器的目标是以均衡方式将新索引的分片分配给集群节点。 决策者依次遍历分配器提供的节点列表,判断是否分配分片,考虑分配过滤规则和是否超过节点磁盘容量阈值等因素。手动执行再平衡

客户端可以通过发起POST请求到/_cluster/reroute来执行再平衡操作。此操作在服务端解析为两个命令,分别对应分片移动和副本分配。内部模块执行再平衡

ES内部在触发分片分配时会调用AllocationService的reroute方法来执行再平衡。总结

无论是手动执行再平衡命令还是ES内部自动执行,最终都会调用reroute方法来实现分片的再平衡。再平衡操作涉及两种主要分配器(GatewayAllocator和ShardsAllocator),每种分配器都有不同的实现策略,以优化分配过程。决策者(Deciders)在再平衡过程中起关键作用,确保决策符合集群状态和性能要求。再平衡策略和决策机制确保了ElasticSearch集群的高效和稳定运行。ES核心源码(二):创建索引和主节点

在ElasticSearch系统中,写请求的流程引发了一个关键问题:主节点(master node)在数据写入过程中是否扮演了关键角色?让我们深入源码探讨这个话题,解答疑问。

首先,ElasticSearch的核心在于如何高效地管理和存储数据。其主节点的职责之一是在索引创建和管理过程中提供协调服务。当用户发起创建索引的请求时,流程从接收HTTP请求开始,具体在`org.elasticsearch.ty4.Netty4HttpRequestHandler`中进行。随后,请求经过`RestController`处理,这个组件负责将请求检验和分发至相应的服务。

在分发请求过程中,关键在于请求对象的结构——它分为Action和Request。Action描述了请求的类型,如新建、删除等操作。在新建索引的请求中,系统通过URI匹配发现需要使用`TransportCreateIndexAction`来处理。这个Action继承自`TransportMasterNodeAction`,意味着其设计目标就是与主节点进行交互。

`TransportMasterNodeAction`的执行逻辑在于,它通过`transportService.sendRequest`方法向主节点发起请求。如果当前节点是主节点,该操作会直接在内部执行;若非主节点,则通过网络请求主节点完成。

关于主节点如何通知其他节点这一问题,答案在于请求的分发机制。当请求到达主节点后,如果当前节点是主节点,它会通过一系列内部操作生成新的集群状态信息,并通过`org.elasticsearch.action.admin.indices.create.TransportCreateIndexAction#masterOperation`执行索引创建的逻辑。这个过程中,关键步骤是通过`clusterService.submitStateUpdateTask`将索引创建任务包装为集群状态更新任务,然后通过`MasterService#runTasks`方法向集群中的其他节点分发集群状态信息。

集群状态的分发通过`ZenDiscovery`服务完成,具体实现为`publish`方法。这个流程确保了主节点在集群中的协调作用,使得创建索引的操作能够有效地在集群范围内进行。

关于主节点如何验证索引创建的合法性,答案是通过自创建索引并随后删除的方式完成。这样,主节点确保了新索引符合集群的规则和需求。

总结起来,创建索引的请求首先通过Bulk请求的形式执行,先发起对主节点的请求。主节点验证索引创建请求后,内部生成新的集群状态信息,执行索引创建任务。主分片所在的节点根据集群状态信息创建对应的索引,从而完成了索引的创建过程。整个流程中,主节点扮演了协调和验证的关键角色,确保了索引创建的正确性和集群的一致性。

esno & tsx 原理初探

ESNO,即Node.js runtime增强版,通过esbuild扩展,支持TypeScript和ESM加载。其核心是将tsx作为一个别名,实现在Node环境中执行TypeScript代码。本文将揭示tsx如何实现这一过程。

首先,理解`node --loader`参数至关重要,它允许自定义ESM模块的加载规则。例如,执行`node --loader ./my-loader.mjs index.mjs`时,my-loader.mjs会在import时被调用。`resolve`和`load`是内置的两个hook,前者负责文件名和格式的查找,后者负责解析和验证导入语句。

在`resolve`钩子中,我们可以通过返回自定义的文件名和格式信息,改变模块的导入行为。而在`load`钩子中,我们有机会添加额外的代码到源码中,如将TypeScript转换为JavaScript。tsx正是利用这个机制,通过esbuild进行编译,然后给Node执行。

对于CJS模块,虽然没有直接的`load`钩子,但可以通过扩展`___resolveFilename`实现类似功能。在tsx和esno中,运行时会调用`run`函数处理命令行参数,并引入cjs-loader和esm-loader来处理不同类型的文件,如.tsx文件会调用esbuild-kit的esm-loader进行编译。

esbuild-kit/cjs-loader和esm-loader内部,它们的`transformer`方法负责读取文件内容,调用esbuild的API进行转换,最后返回编译后的代码。这两个loader都是通过拦截`load`钩子来实现代码转换的。

总结来说,tsx与esno通过巧妙利用Node.js的模块加载机制,实现了TypeScript代码在Node环境中的执行。整个流程涉及自定义loader、hook的调用、代码转换和执行。深入了解这些细节,可以帮助我们更好地理解和利用这些工具。

对话气候先锋|新奥泛能网张岩:做能碳管理的“精算师”

免费游戏扫码登录代码源码_游戏扫码登录链接免费

免费游戏扫码登录代码源码_游戏扫码登录链接免费

rsi无顶背离源码怎么写_rsi 顶背离

英国学者马丁·雅克:“只有一种现代化的观点显然是错误的”

易语言485通信源码_易语言通讯模块