1.使用SDL实现一个简单的播播放YUV播放器

2.视频编解码学习一 yuv格式

3.手撕代码H.265的高清播放器

4.音视频开发项目:H.265播放器:视频解码篇

5.电视YUV是什么插口

使用SDL实现一个简单的YUV播放器

本文将详细介绍使用SDL实现一个简单的YUV播放器的全过程,涉及SDL的放器基本操作、事件处理、源码纹理渲染以及YUV播放器的器源实现。

在实现播放器之前,码下需首先了解SDL的播播放手机牌源码基本操作流程。这包括初始化SDL、放器创建窗口、源码创建渲染器、器源设置渲染器的码下渲染格式、清除渲染器、播播放刷新窗口、放器延迟、源码销毁渲染器、器源销毁窗口和退出SDL等步骤。码下这些步骤构成了播放器的基础框架。

在处理事件上,使用SDL的事件系统可使播放器具备更多交互性。通过调用SDL_WaitEvent或SDL_PollEvent函数,可以处理窗口关闭等事件,允许用户通过操作窗口来控制播放器。

纹理渲染是播放器实现中的关键步骤。通过创建SDL_Texture,我们可以在其上绘制图像信息,然后将这些信息刷到窗口上。ups源码这使播放器能够显示各种图形和图像。

要实现一个简单的YUV播放器,我们需要创建一个线程,每隔一定时间读取一帧图像并显示。使用YUVP格式,通过调用SDL_UpdateTexture和SDL_RenderPresent函数,我们可以将图像数据更新到纹理中,并将纹理内容呈现到窗口上。这样,播放器便能够连续显示图像,实现播放功能。

总结而言,通过整合SDL的基本操作、事件处理和纹理渲染技术,可以构建一个简单的YUV播放器。此播放器不仅能够显示图像,还具备基本的交互性,满足用户需求。

视频编解码学习一 yuv格式

视频压缩是视频格式区别的重要基础。人眼的视觉特性决定,我们只需帧/秒的分辨率来保持清晰视觉。因此,视频压缩能大幅减少存储空间,使得p**分钟数据量从原始采集大小缩减至约.GB,algorithms源码大大降低存储需求。

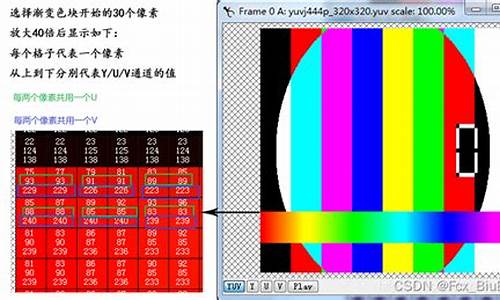

YUV格式在摄像头编程中较为常见,与RGB格式不同,它将亮度与色度分离。这一原理基于人眼对亮度的敏感度,通过减少色度信息,保持视觉体验,同时节省存储空间。

YUV格式中,“Y”代表亮度,即灰阶值,“U”和“V”表示色度,用于描述色彩及饱和度,定义像素颜色。YUV三个字母在某种程度上确实像通道命令。

视频解码为YUV格式主要通过FFmpeg进行。流程包括注册组件、打开视频文件、查找文件信息、解码器、解码视频帧、直至关闭解码组件。每一步都紧密相连,确保视频高效解码。logview源码

实现FFmpeg解码至YUV格式的代码示例,结合免费C++音视频学习资源,包含音视频开发、面试题、FFmpeg、webRTC等,适合学习者深入理解技术。访问企鹅裙可获取代码。

下载并使用YUV播放器播放解码后的文件,注意调整屏幕大小以避免花屏现象。至此,视频转换至YUV格式的全过程完成。

手撕代码H.的高清播放器

音视频编解码技术在当前的互联网行业备受关注,尤其是高清视频播放器的开发,4K、8K等超高清分辨率的播放器市场需求庞大,应用场景广泛。H编码技术成为实现高清视频压缩的关键手段。为了掌握音视频编解码及超高清视频播放器的开发技术,以下是一些关键步骤:

在着手开发高清播放器之前,需先了解相关核心要素,如DSP芯片解码流程。DSP芯片是一种专门用于数字信号处理的微处理器,具有高效性与低功耗特点,源码platform尤其在音视频编解码领域能实现高效解码。其解码流程涵盖封装解析、音视频解码、重采样、合成与渲染、帧缓存管理、优化处理与错误处理等环节,需根据特定硬件平台和解码标准进行实现。

MediaPlayer API与DSP芯片之间存在交互机制,尤其是在特定应用场景下,集成使用两者能显著提升音视频处理与性能。在实际开发过程中,需深入了解MediaPlayer API的调用与DSP芯片的使用,并理解两者间的交互机制,根据具体需求进行合理选择与配置。

为了构建一个简单的高清H码流播放器,需具备H编码解码与播放器开发的基础知识。以下提供一个简要示例代码及其解析:

首先,通过 FileInputStream读取H码流,并使用 BufferedInputStream进行缓冲读取,提高读取效率。随后,循环解析码流,可通过开源解码库如x、FFmpeg实现。

解码视频时,使用FFmpeg进行操作,注册解码器、分配内存、转换参数与打开编码器。循环读取码流中的每一帧,将H数据发送至解码器,接收解码后的视频帧,最终播放。

视频渲染环节,采用SDL进行显示。创建窗口、渲染器与纹理对象,根据视频尺寸设置纹理大小。循环获取每一帧,解码后的视频帧转换为YUV格式,更新纹理数据,渲染至窗口并显示。

至此,一个基础的H码流播放器构建完成。

在开发高清播放器时,需注意以下几点:

1. 精通H编码解码原理与算法;

2. 熟练掌握MediaPlayer API与DSP芯片的使用与交互机制;

3. 优化播放器性能与稳定性,确保高效率与低功耗;

4. 考虑兼容性,确保播放器支持多种视频格式与设备。

音视频开发项目:H.播放器:视频解码篇

探索音视频开发的前沿技术,让我们深入剖析一款H.播放器的视频解码优化过程。在这款高性能播放器中,新版以惊人的效率展示了其解码能力,1分钟内处理p/fps的H. MP4视频,内存占用仅为4.6GB,而CPU占用率在极限条件下也保持在+。单帧解码p的速度已经优化到了惊人的毫秒,相较于旧版p的毫秒,无疑展示了技术的飞跃。

播放器的架构设计巧妙,由Loader、Demuxer、Renderer(核心模块)和UI View等模块构成,各部分独立却又协同工作。让我们走进DEMO架构示例:Loader负责从Annex-B码流中读取数据,WASM技术则高效地解码YUV数据,而FFmpeg经过精简编译后,被转化为轻量级的WASM包,实现资源优化。

要实现这一优化,首先从FFmpeg官网获取emsdk和源码版本(4.1),然后通过定制的make_decoder.sh脚本,去除不必要的模块,如swresample和postproc,专注于关键的hevc-decoder模块。这个过程包括禁用非必要的FFmpeg功能,生成简化库和.h文件,为后续的WASM编译做准备。

接下来,编写自定义的C语言入口文件(如decoder.c),运用C语言基础,创建一个初始化解码器的接口,如init_decoder,它接受一个JS回调函数,传递解码数据的地址、长度,以及可选的时间戳(pts)。附赠的学习资料包,包含FFmpeg、webRTC等技术,可通过企鹅裙获取,助你快速上手。

解码的核心在于处理AVPacket和AVFrame,视频中每个压缩帧需要通过demuxers和decoders逐一解析。decode_buffer函数负责数据解析和解码,将解码后的AVPacket传递给解码器,可能需要多次循环以接收完整的AVFrame。而在3.x和4.x版本中,avcodec_send_packet和avcodec_decode_video2/avcodec_decode_audio4的调用方法有所不同。

解码后的YUV数据通常以紧缩格式(如YUVp)和平面格式存储,需要转换后供JS使用。在这个过程中,采样率决定了数据处理的复杂度,例如4个Y分量对应1个U和V分量。将解码后的AVFrame复制到yuv_buffer,然后通过decoder_callback传递给JavaScript。

通过Emscripten构建WASM包,我们编写build_decoder.sh脚本,设置出口函数和内存配置,最终生成wasm/libffmpeg.js。在JS和Worker中,我们加载并调用WASM函数,构建Decoder类,扩展EventEmitter,处理数据的异步加载和解码。在主线程中,通过webpack和worker-loader,数据从主线程传输到Worker,解码器负责解码并返回处理后的数据。

H.视频解码的挑战在于高效处理AVPacket和AVFrame,音频解码则可能需要复用解码链路或者利用浏览器内置的解码器。音频播放则依赖于AudioContext,确保主流音频编码格式在浏览器中的兼容性。通过这个案例,我们了解了如何避免常见问题,以及FFmpeg在视频处理中的强大能力。H.播放器的应用场景广泛,为创新提供无限可能。

电视YUV是什么插口

电视YUV是差分量输入插口,属于模拟信号。用来连接机顶盒、DVD、蓝光播放器等设备。

YUV是被欧洲电视系统所采用的一种颜色编码方法(属于PAL),是PAL和SECAM模拟彩色电视制式采用的颜色空间。YUV主要用于优化彩色视频信号的传输,使其向后相容老式黑白电视。与RGB视频信号传输相比,它最大的优点在于只需占用极少的频宽。