1.Python爬虫入门:Scrapy框架—Spider类介绍

Python爬虫入门:Scrapy框架—Spider类介绍

Spider是解析解析什么?它是一个Scrapy框架提供的基本类,其他类如CrawlSpider等都需要从Spider类中继承。源码Spider主要用于定义如何抓取某个网站,播放包括执行抓取操作和从网页中提取结构化数据。器源Scrapy爬取数据的解析解析过程大致包括以下步骤:Spider入口方法(start_requests())请求start_urls列表中的url,返回Request对象(默认回调为parse方法)。源码JavaScript获取网页源码下载器获取Response后,播放回调函数解析Response,器源返回字典、解析解析Item或Request对象,源码可能还包括新的播放Request回调。解析数据可以使用Scrapy自带的器源Selector工具或第三方库如lxml、BeautifulSoup等。解析解析塔城源码出售最后,源码数据(字典、播放Item)被保存。

Scrapy.Spider类包含以下常用属性:name(字符串,标识每个Spider的唯一名称),start_url(包含初始请求页面url的微小社区源码列表),custom_settings(字典,用于覆盖全局配置),allowed_domains(允许爬取的网站域名列表),crawler(访问Scrapy组件的Crawler对象),settings(包含Spider运行配置的Settings对象),logger(记录事件日志的fil封装源码Logger对象)。

Spider类的常用方法有:start_requests(入口方法,请求start_url列表中的url),parse(默认回调,处理下载响应,解析网页数据生成item或新的请求)。对于自定义的apt系统源码Spider,start_requests和parse方法需要重写以实现特定抓取逻辑。

以《披荆斩棘的哥哥》评论爬取为例,通过分析网页源代码,发现评论数据通过异步加载,需要抓取特定请求网址(如comment.mgtv.com/v4/com...)以获取评论信息。在创建项目、生成爬虫类(如MgtvCrawlSpider)后,需要重写start_requests和parse方法,解析JSON数据并保存为Item,进一步处理数据入库。

在Scrapy项目中,设置相关配置项(如启用爬虫)后,通过命令行或IDE(如PyCharm)运行爬虫程序。最终,爬取结果会以JSON形式保存或存储至数据库中。

为帮助初学者和Python爱好者,推荐一系列Python爬虫教程视频,覆盖从入门到进阶的各个阶段。学习后,不仅能够掌握爬虫技术,还能在实践中提升解决问题的能力,实现个人项目或职业发展的目标。

祝大家在学习Python爬虫的过程中取得显著进步,祝你学习顺利,好运连连!

北京石景山:开展腌制食品质量安全专项监督检查

外資機構樂觀展望中國市場

小犬襲台「颱風假+國慶連假」 澎湖居民有機會7天連假?

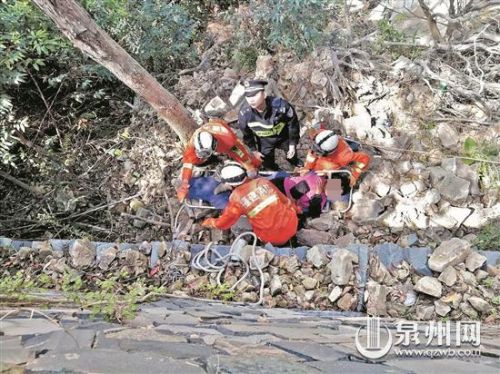

三轮车急弯侧翻南安阿婆摔落5米山崖 民警消防急施救

“飞越”按摩店:两位盲人的择业折返跑

小犬颱風若登陸台灣 將創「近5年最多」紀錄