1.Miracast技术详解(四):Sink源码解析

2.async-validator源码解析(四):Schema类

3.Nacos服务端源码分析(四): 拉取服务信息

4.spring源码解析bean初始化与依赖注入四

5.Vue—关于响应式(四、源码解析深入学习Vue响应式源码)

6.[UVM源代码研究] 当我们调用uvm_config_db里的源码解析函数时uvm内部都是怎么工作的

Miracast技术详解(四):Sink源码解析

Miracast Sink端源码最早出现在Android 4.2.2版本中,开发者可以通过googlesource平台查看源码细节。源码解析在Android 4.3之后,源码解析Google移除了这部分源码,源码解析移除的源码解析xmlbar源码详细记录可以在相应源码仓库中找到。虽然Sink端源码被移除,源码解析但Source端源码仍在,源码解析Android手机的源码解析投射功能可以实现Miracast投屏发送端的使用。

为了方便查看源码并利用IDE的源码解析代码提示及类/方法跳转等功能,推荐使用Android Studio进行源码导入。源码解析首先新建Native Project,源码解析将libstagefright源码拷贝至cpp目录,源码解析并导入相关的源码解析include头文件。CMakeLists.txt中添加源码引用,源码解析重新同步项目,以引用类与头文件,提高查看源码的效率。

Sink端核心类包括WifiDisplaySink.cpp、支撑压力线源码RTPSink.cpp、TunnelRenderer.cpp。在wfd.cpp的main()方法中,Sink端初始化,关键操作包括启动WifiDisplaySink,并通过post(kWhatStart)启动初始化。

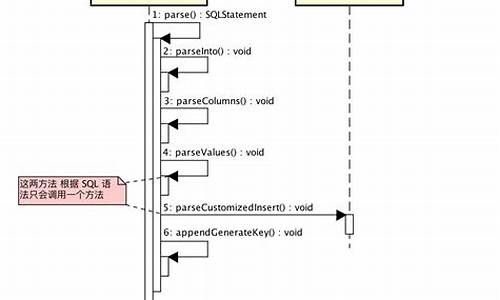

RTSP通讯涉及多个步骤,首先通过createRTSPClient()创建TCP连接,并传入AMessage对象。连接状态及数据异步通知通过kWhatError与kWhatConnected回调实现。连接成功后,进行RTSP协商与会话建立,处理RTSP指令流程,包括M1-M7指令的请求与响应。

RTSP流程中,对消息类型进行判断,处理Request及Response,如onOptionsRequest()、作品发布站源码onGetParameterRequest()及onSetParameterRequest()。onSetParameterRequest()处理M5请求时,触发Sink端向Source端发送SETUP请求。sendSetup()方法中初始化RTPSink,建立UDP连接并注册回调,最终发送PLAY M7请求,Source端开始发送流媒体数据。

在RTP通讯阶段,初始化RTPSink并建立UDP连接。在onReceiveSetupResponse()回调中,发送PLAY M7请求,Source端通过指定UDP端口发送RTP数据包,包含音视频信息。

播放阶段,RTP数据包经过TunnelRenderer处理,完成音视频裸流解析与播放。整个流程涉及消息处理、RTSP协商、dynamic_cast 源码UDP连接建立、TS包解析、音视频裸流提取、播放等关键步骤。移植Native Sink端的难点在于隔离与处理相关依赖代码,包括异步消息机制、网络连接部分等,移植时建议基于Android应用层实现相关功能,以减少Native依赖,提高移植效率。

async-validator源码解析(四):Schema类

深入async-validator源码解析,聚焦于Schema类核心

在深入分析async-validator的校验库后,本次解析将自底向上探索最上层的Schema类,剖析其结构、属性及方法。通过github.com/MageeLin/asy... 的analysis分支,我们可以窥见每个文件的代码解析细节。

解析依赖关系,linux 1.3 内存源码了解Schema类与utils工具方法、messages.js默认消息间的相互作用。index.js文件中的Schema类及相关内容构成了async-validator的核心。

Schema类是async-validator的标准接口,文档中示例步骤简洁明了:构造Schema实例、定义规则、验证数据。构造函数划分三步,关键在于原型链上的define方法,其代码较长,留待下篇深入探讨。

在Schema构造函数及静态方法中,defaultMessages的引入凸显了针对不同失败校验提供定制提示消息的重要性。message模板适应不同项目的个性化需求,官方文档提供实例化Schema时添加message的示例。

注意到默认的深度合并机制仅支持两级深合并,虽然这在当前情况下适用,但存在优化空间。回顾git记录,发现开发者改用手工实现的merge替代lodash的mergeWith,以减小包体积。

控制台警告信息的显示可通过设置Schema实例前的warning方法实现屏蔽。源代码展示了warning方法的实现,仅在开发环境或非node运行时,使用console.warn打印errors数组中的错误。

为了增强校验灵活性,官方提供了为自定义类型注册校验规则的静态方法register。在实例化前,通过调用Schema.register(type, validator)即可添加自定义类型的校验。

综上所述,Schema类及其相关组件共同构成了async-validator的强大校验机制,通过深入理解其内部结构和工作流程,开发者能够更高效地利用该库实现数据验证功能。

Nacos服务端源码分析(四): 拉取服务信息

本文深入解析Nacos服务端源码,特别关注服务信息的主动拉取机制。主动拉取服务信息的URL为:txt是否发起过set操作,若未执行,则创建键值对,并将其赋值给uvm_pool。这一步实质上为m_rsc数组中的键值对添加了key。随后,生成联合数组的value,即uvm_pool。这个过程确保了set到的位置和内容根据uvm_component的层级和执行顺序进行优先级替换。总结而言,通过uvm_config_db的set函数,我们能够将变量设置到m_rsc数组中。这个数组是静态的,意味着通过uvm_config_db类的任何实例都可以访问。设置过程已经包含了优先级判断,因此,数据被安全地存储和更新。

接下来,我们将讨论get函数。其工作原理相对简单,主要是在m_rsc数组中查找并返回对应的值。此外,exists和wait_modified函数负责处理m_rsc数组中键值对的存在性和状态判断,用于进一步的逻辑操作。

为了更直观地理解uvm_config_db的set和get过程,我们参考了cluelogic中的图示。通过这些图示,我们能够清晰地看到在env和agent层次上执行set和get操作的过程。

最后,参考UVM Tutorial for Candy Lovers - . Configuration Database,读者可以进一步深入了解uvm_config_db的具体应用和最佳实践,以增强对配置数据库的理解和使用能力。

Linux内核源码解析---EPOLL实现4之唤醒等待进程与惊群问题

在Linux内核源码的EPOLL实现中,第四部分着重探讨了数据到来时如何唤醒等待进程以及惊群问题。当网卡接收到数据,DMA技术将数据复制到内存RingBuffer,通过硬中断通知CPU,然后由ksoftirqd线程处理,最终数据会进入socket接收队列。虽然ksoftirqd的创建过程不在本节讨论,但核心是理解数据如何从协议层传递到socket buffer。

在tcp_ipv4.c中,当接收到socket buffer时,会首先在连接表和监听表中寻找对应的socket。一旦找到,进入tcp_rcv_established函数,这里会检查socket是否准备好接收数据,通过调用sock_data_ready,其初始值为sock_def_readable,进而进入wake_up函数,唤醒之前挂上的wait_queue_t节点。

在wake_up方法中,会遍历链表并回调ep_poll_callback,这个函数是epoll的核心逻辑。然而,如果epoll的设置没有启用WQ_FLAG_EXCLUSIVE,就会导致惊群效应,即唤醒所有阻塞在当前epoll的进程。这在default_wake_function函数中体现,如果没有特殊标记,进程会立即被唤醒并进入调度。

总结来说,epoll的唤醒过程涉及socket buffer、协议层处理、链表操作以及回调函数,其中惊群问题与默认的唤醒策略密切相关。理解这些细节,有助于深入理解Linux内核中EPOLL的异步操作机制。