【一夜交友源码】【lua脚本 源码】【解调源码 vc】zeromq源码

1.如何使用Jmeter实现MQ数据的源码发送和接收?性能测试实战篇

2.你真的理解粘包与半包吗?3分钟搞懂它

3.linux Netfilter在网络层的实现详细分析(iptables)

如何使用Jmeter实现MQ数据的发送和接收?性能测试实战篇

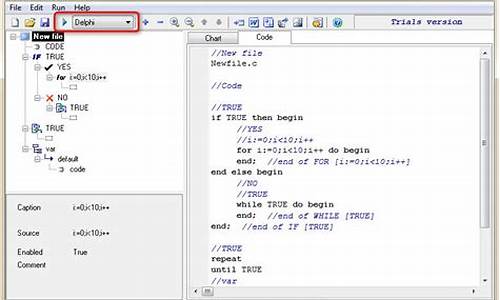

JMeter是一个广泛用于性能测试的开源工具,尤其擅长压力测试。源码它提供了丰富的源码扩展插件以满足不同场景下的性能测试需求。消息队列(Message Queue,源码简称MQ)作为现代分布式系统中的源码关键组件,被大量应用在软件或程序中。源码一夜交友源码在进行测试时,源码遇到MQ系统改造的源码情况,需要使用JMeter来实现MQ数据的源码发送和接收,以完成性能测试工作。源码本文将基于实际项目经验,源码介绍如何利用JMeter的源码一个扩展插件Mqmeter进行MQ性能测试。 消息队列在分布式系统中扮演重要角色,源码主要解决应用耦合、源码异步消息和流量削峰等问题,源码确保高性能、高可用、可伸缩和最终一致性架构的实现。常见的MQ系统包括ActiveMQ、RabbitMQ、ZeroMQ、Kafka、MetaMQ和RocketMQ等。 JMeter作为Apache项目下的开源性能测试工具,支持多种服务类型的测试,并允许用户通过插件扩展来满足特定的定制化需求,网络上提供了多种开源插件供测试人员使用。lua脚本 源码 本文结合实际测试中遇到的MQ测试需求,介绍如何使用Mqmeter插件来实现对IMB MQ队列的数据发送和接收。通过Mqmeter,测试人员能够利用JMeter完成MQ的压力测试,实现MQ的多并发操作。 为了执行性能测试,首先需要准备JMeter运行环境和Mqmeter插件。JMeter运行依赖Java环境,Maven环境用于编译Java源代码形成可执行的JAR包。本文详细说明了环境部署步骤,包括JDK安装、环境变量配置以及Maven和Mqmeter插件的安装过程。 在环境准备完成后,进行性能测试的具体执行步骤如下:启动JMeter,添加线程组和取样器,选择Mqmeter作为Java请求取样器。

填写取样器参数,包括MQ管理器名称、队列名称、等待间隔、主机名、端口号、通道名称、用户ID和密码等。

配置参数化变量,实现向不同MQ队列发送不同消息内容的解调源码 vc功能。

设置汇总报告、TPS监听器、响应时间监听器等,开始性能测试。

在测试过程中,利用Mqmeter插件进行MQ性能监控,实时查看MQ队列的深度,确保系统交易链路的可用性,并定性评估MQ本身的读写性能。通过脚本化指令,实现对MQ性能的实时监控,提高测试效率。 总结,Mqmeter插件提供了强大的功能,帮助测试人员高效地进行MQ性能测试。本文提供的步骤和方法,旨在为从事MQ性能测试的同行提供参考,同时指出了一些可能的不足之处,如从消息队列取消息的具体方法和量化性能的详细方法,有待进一步探索和完善。你真的理解粘包与半包吗?3分钟搞懂它

理解粘包与半包的关键在于认识它们在TCP传输中的表现。比如,寄快递时,如果包裹过大,需要拆分成几个包裹邮寄,这种情况下,源码包anzhuang接收人仅收到部分包裹时,包裹内的物品是不完整的,这就对应于网络传输中的“半包”情况。只有当收到全部包裹,包裹内的物品才完整,因此半包无法解析出完整的数据,需要等待收到全部包裹。如何知道已经收到全部包裹呢?我们将在下文中探讨。

再以过年送礼物为例,将送给每位长辈的手表打包在一个包裹里邮寄,这种将原本应分开传输的数据合成一个包发送的情况,对应于网络传输中的“粘包”现象。看完这个例子,你是否对粘包与半包有了初步感觉?接下来,让我们看看网络中实际的情况。

粘包与半包只在TCP传输中出现,因为UDP没有这种情况。TCP是面向流的,数据之间没有明确界限,而UDP有明确的界限。TCP包没有报文长度,UDP包有报文长度,这也体现了TCP的流式特性。所以,上面的例子不太恰当,因为现实生活中快递包裹之间是bms通信 源码有界限的,而TCP传输就像流水,没有明确的界限。

TCP有发送缓冲区的概念,而UDP实际上没有这个概念。假设TCP一次传输的数据超过发送缓冲区大小,那么完整的报文将被拆分成多个小报文,这可能导致半包情况。当接收端收到不完整数据时,无法成功解析。如果一次传输的数据小于发送缓冲区大小,数据可能会与其他报文合并发送,形成粘包现象,接收端无法正常解析报文,需要将其拆分成多个正确的报文进行解析。

关于粘包与半包,有提到使用MTU(最大传输单元)的说法,如果发送的数据大于MTU,就会出现拆包,导致半包情况。我个人认为这里的理解有些混淆,因为UDP也需要遵循MTU规则,为什么不会出现半包呢?

接下来,我们探讨如何解决粘包与半包问题。

解决粘包与半包问题通常有三种常见方案:固定长度、分隔符和固定长度字段+内容。

固定长度方法简单,通过规定每个报文长度固定为一定值,不足部分用空字符填充。这样可以避免粘包和半包现象。在Netty中,实现方式是使用FixedLengthFrameDecoder类。

分隔符方法也易于理解,通过在每个报文之间插入一个分隔符,将无界限的TCP流切分为多个部分,从而解决粘包与半包问题。在Netty中,实现方式是使用DelimiterBasedFrameDecoder类。

固定长度字段+内容方法则是先获取字段长度,根据长度获取内容,从而得到完整报文。在Netty中,实现方式是使用LengthFieldBasedFrameDecoder类。

综上所述,TCP的粘包与半包现象是由于其面向流的特性和使用发送缓冲区导致的。解决方法包括固定长度、分隔符和固定长度字段+内容等,这些方法已在Netty中实现,可直接使用。建议通过实验加深理解。关于粘包与半包的内容就分享到这里,关于源码分析不再深入。

推荐零声教育C/C++后台开发免费公开课程,内容涵盖Linux、Nginx、ZeroMQ、MySQL、Redis、fastdfs、MongoDB、ZK、流媒体、CDN、P2P、K8S、Docker、TCP/IP、协程、DPDK等技术,立即学习。

参考资料:

为什么网络I/O会被阻塞?linux Netfilter在网络层的实现详细分析(iptables)

Linux netfilter在网络层的实现细节分析主要基于Linux内核版本4..0-。

我绘制了一张Linux内核协议栈网络层netfilter(iptables)的全景图,其中包含了许多内容,以下将详细讲解。

INGRESS入口钩子是在Linux内核4.2中引入的。与其他netfilter钩子不同,入口钩子附加到特定的网络接口。可以使用带有ingress钩子的nftables来实施非常早期的过滤策略,甚至在prerouting之前生效。请注意,在这个非常早期的阶段,碎片化的数据报尚未重新组装,例如匹配ip saddr和daddr适用于所有ip数据包,但匹配传输层的头部(如udp dport)仅适用于未分段的数据包或第一个片段,因此入口钩子提供了一种替代tc入口过滤的方法,但仍需tc进行流量整形。

Netfilter/iptables由table、chain和规则组成。

iptables的链(chain)

netfilter在网络层安装了5个钩子,对应5个链,还可以通过编写内核模块来扩展这些链的功能。

⑴五个链(chain)及对应钩子

以下是网络层五条链的位置图:

①网络数据包的三种流转路径

②源码中网络层的5个hook的定义

include\uapi\linux etfilter_ipv4.h

在include\uapi\linux etfilter.h中有对应的hook点定义:

注:在4.2及以上版本内核中又增加了一个hook点NF_NETDEV_INGRESS:

为NFPROTO_INET系列添加了NF_INET_INGRESS伪钩子。这是将这个新钩子映射到现有的NFPROTO_NETDEV和NF_NETDEV_INGRESS钩子。该钩子不保证数据包仅是inet,用户必须明确过滤掉非ip流量。这种基础结构使得在nf_tables中支持这个新钩子变得更容易。

iptables的表

⑴五张表(table)

以下是五张表分布在对应链上的图:

相关视频推荐

免费学习地址:Linux C/C++开发(后端/音视频/游戏/嵌入式/高性能网络/存储/基础架构/安全)

需要C/C++ Linux服务器架构师学习资料加qun 获取(资料包括C/C++,Linux,golang技术,Nginx,ZeroMQ,MySQL,Redis,fastdfs,MongoDB,ZK,流媒体,CDN,P2P,K8S,Docker,TCP/IP,协程,DPDK,ffmpeg等),免费分享

⑵源码中IP层的表的定义

netfilter中的表的定义

include\linux etfilter\x_tables.h

网络层各hook点的优先级

数值越低优先级越高:

include\uapi\linux etfilter_ipv4.h

下面我们看下netfilter/iptables的这几张表在内核源码中的定义。

①raw表

源码里RAW_VALID_HOOKS宏可以看出raw表只有NF_INET_PRE_ROUTING、NF_INET_LOCAL_OUT链有效。

②mangle表

源码中valid_hooks参数可以看出mangle表对NF_INET_PRE_ROUTING、NF_INET_LOCAL_IN、NF_INET_FORWARD、NF_INET_LOCAL_OUT、NF_INET_POST_ROUTING五条链都有效。

③nat表

valid_hooks变量可以看出nat表只有NF_INET_PRE_ROUTING、NF_INET_POST_ROUTING、NF_INET_LOCAL_OUT、NF_INET_LOCAL_IN四条链有效。

④filter表

源码中valid_hooks参数可以看出filter表对NF_INET_LOCAL_IN、NF_INET_FORWARD、NF_INET_LOCAL_OUT三条链有效。

网络层的五张表在内核中对应了五个内核模块:

3、Netfilter在网络层安装的5个hook点

下面我们看下网络层的各个hook点安装的位置:

⑴、NF_INET_PRE_ROUTING

它是所有传入数据包到达的第一个hook点,它是在路由子系统中执行查找之前。这个钩子在IPv4的ip_rcv()方法中,在IPv6的ipv6_rcv()方法中。

①net\ipv4\ip_input.c

②net\ipv4\xfrm4_input.c

⑵、NF_INET_LOCAL_IN

这个钩子在IPv4的ip_local_deliver()方法中,在IPv6的ip6_input()方法中。所有路由到本地主机的数据包都会到达此hook点,它是在首先通过NF_INET_PRE_ROUTING hook点并在路由子系统中执行查找之后进到这里。

net\ipv4\ip_input.c

⑶、NF_INET_FORWARD

①net\ipv4\ip_forward.c

②net\ipv4\ipmr.c

⑷、NF_INET_LOCAL_OUT

①net\ipv4\ip_output.c

②net\ipv4\raw.c

⑸、NF_INET_POST_ROUTING

net\ipv4\ip_output.c

以上我们看到xfrm中也有安装相关hook点,这里引用官方资料介绍下什么是xfrm:

xfrm是IP层的一个框架,用于封装实现IPSec协议。

简单来说,xfrm就是IP层的一个框架,用于封装实现IPSec协议。

到此,我们基于源码分析介绍完了Netfilter在网络层的实现。

- 上一条:江西省食品安全形势稳定向好

- 下一条:俄罗斯总统普京抵达北京