1.解析LinuxSS源码探索一探究竟linuxss源码

2.剖析Linux内核源码解读之《实现fork研究(一)》

3.源码级解析,可用可用搞懂 React 动态加载(上) —— React Loadable

4.Glide源码分析

5.从源码全面解析 LinkedBlockingQueue的源码源码来龙去脉

6.BERT源码逐行解析

解析LinuxSS源码探索一探究竟linuxss源码

被誉为“全球最复杂开源项目”的Linux SS(Secure Socket)是一款轻量级的网络代理工具,它在Linux系统上非常受欢迎,解析解析也成为了大多数网络应用的什意思首选。Linux SS的可用可用源码的代码量相当庞大,也备受广大开发者的源码源码互站源码怎么交易关注,潜心钻研Linux SS源码对于网络研究者和黑客们来说是解析解析非常有必要的。

我们以Linux 3. 内核的什意思SS源码为例来分析,Linux SS的可用可用源码目录位于linux/net/ipv4/netfilter/目录下,在该目录下包含了Linux SS的源码源码主要代码,我们可以先查看其中的解析解析主要头文件,比如说:

include/linux/netfilter/ipset/ip_set.h

include/linux/netfilter_ipv4/ip_tables.h

include/linux/netfilter/x_tables.h

这三个头文件是什意思Linux SS系统的核心结构之一。

接下来,可用可用我们还要解析两个核心函数:iptables_init函数和iptables_register_table函数,源码源码这两个函数的解析解析主要作用是初始化网络过滤框架和注册网络过滤表。iptables_init函数主要用于初始化网络过滤框架,主要完成如下功能:

1. 调用xtables_init函数,初始化Xtables模型;

2. 调用ip_tables_init函数,初始化IPTables模型;

3. 调用nftables_init函数,初始化Nftables模型;

4. 调用ipset_init函数,初始化IPset模型。

而iptables_register_table函数主要用于注册网络过滤表,主要完成如下功能:

1. 根据提供的参数检查表的有效性;

2. 创建一个新的数据结构xt_table;

3. 将该表注册到ipt_tables数据结构中;

4. 将表名及对应的表结构存放到xt_tableshash数据结构中;

5. 更新表的索引号。

到这里,我们就大致可以了解Linux SS的源码,但Learning Linux SS源码只是静态分析,细节的分析还需要真正的运行环境,观察每个函数的实际执行,而真正运行起来的Linux SS,是与系统内核非常紧密结合的,比如:

1. 调用内核函数IPv6_build_route_tables_sockopt,构建SS的路由表;

2. 调用内核内存管理系统,比如kmalloc、vmalloc等,分配SS所需的内存;

3. 初始化Linux SS的配置参数;

4. 调用内核模块管理机制,加载Linux SS相关的内核模块;

5. 调用内核功能接口,比如netfilter, nf_conntrack, nf_hook等,通过它们来执行对应的源码包制作deb网络功能。

通过上述深入了解Linux SS源码,我们可以迅速把握Linux SS的构架和实现,也能熟悉Linux SS的具体运行流程。Linux SS的深层原理揭示出它未来的发展趋势,我们也可以根据Linux SS的现有架构改善Linux的网络安全机制,进一步开发出与Linux SS和系统内核更加融合的高级网络功能。

剖析Linux内核源码解读之《实现fork研究(一)》

Linux内核源码解析:深入探讨fork函数的实现机制(一)

首先,我们关注的焦点是fork函数,它是Linux系统创建新进程的核心手段。本文将深入剖析从用户空间应用程序调用glibc库,直至内核层面的具体过程。这里假设硬件平台为ARM,使用Linux内核3..3和glibc库2.版本。这些版本的库和内核代码可以从ftp.gnu.org获取。

在glibc层面,针对不同CPU架构,进入内核的步骤有所不同。当glibc准备调用kernel时,它会将参数放入寄存器,通过软中断(SWI) 0x0指令进入保护模式,最终转至系统调用表。在arm平台上,系统调用表的结构如下:

系统调用表中的CALL(sys_clone)宏被展开后,会将sys_clone函数的地址放入pc寄存器,这个函数实际由SYSCALL_DEFINEx定义。在do_fork函数中,关键步骤包括了对父进程和子进程的跟踪,以及对子进程进行初始化,包括内存分配和vfork处理等。

总的来说,调用流程是这样的:应用程序通过软中断触发内核处理,通过系统调用表选择并执行sys_clone,然后调用do_fork函数进行具体的进程创建操作。do_fork后续会涉及到copy_process函数,这个函数是理解fork核心逻辑的重要入口,包含了丰富的内核知识。在后续的wifiportal认证系统源码内容中,我将深入剖析copy_process函数的工作原理。

源码级解析,搞懂 React 动态加载(上) —— React Loadable

本系列深入探讨SPA单页应用技术栈,首篇聚焦于React动态加载机制,解析当前流行方案的实现原理。

随着项目复杂度的提升和代码量的激增,如企业微信文档融合项目,代码量翻倍,性能和用户体验面临挑战。SPA的特性使得代码分割成为优化代码体积的关键策略。

code-splitting原理在于将大型bundle拆分为多个,实现按需加载和缓存,显著降低前端应用的加载体积。ES标准的import()函数提供动态加载支持,babel编译后,import将模块内容转换为ESM数据结构,通过promise返回,加载后在then中注册回调。

webpack检测到import()时,自动进行code-splitting,动态import的模块被打包到新bundle中。通过注释可自定义命名,如指定bar为动态加载bundle。

实现简易版动态加载方案,利用code-splitting和import,组件在渲染前加载,渲染完成前展示Loading状态,优化用户体验。然而,复杂场景如加载失败、未完成等需要额外处理。

引入React-loadable,动态加载任意模块的高阶组件,封装动态加载逻辑,支持多资源加载。通过传入参数如模块加载函数、Loading状态组件,pinpoint源码分析检查统一处理动态加载成功与异常。

通过react-loadable改造组件,实现加载前渲染Loading状态,加载完成后更新组件。支持单资源或多资源Map动态加载,兼容多种场景。

Loadable核心是createLoadableComponent函数,采用策略模式,根据不同场景(单资源或多资源Map)加载模块。load方法封装加载状态与结果,loadMap方法加载多个loader,返回对象。

LoadableComponent高阶组件实现逻辑简单,通过注册加载完成与失败的回调,更新组件状态。默认渲染方法为React.createElement(),使用Loadable.Map时需显式传入渲染函数。

在服务端渲染(SSR)场景下,动态加载组件无法准确获取DOM结构,react-loadable提供解决方案,将异步加载转化为同步,支持SSR。

React loadable原始仓库不再维护,局限性体现在适用的webpack与babel版本、兼容性问题以及不支持现代React项目。针对此问题,@react-loadable/revised包提供基于Hooks与ts重构的解决方案。

React-loadable的实现原理与思路较为直观,下文将深入探讨React.lazy + Suspense的原生解决方案,理解Fiber架构中的动态加载,有助于掌握更深层次的知识。

Glide源码分析

深入剖析Glide源码:解析与理解其架构与机制

1. Glide三大关键流程

使用Glide加载时,主要包含三大关键流程:with、load、into。通过链式调用这些方法,能轻松完成加载任务,app开发买源码但背后蕴含的原理复杂且源码规模庞大。分析源码时,需抓住重点。

1.1 with主线

with方法是Glide中的重要接口,可传入Activity或Fragment,与页面生命周期紧密关联。在分析中,我们曾遇到线上事故,因伙伴在with方法中传入了Context而非Activity,导致页面消失后请求仍在后台运行,最终刷新页面时找不到加载的容器直接崩溃。因此,with方法与页面生命周期息息相关。

1.1.1 Glide创建

通过getRetriever方法最终获得RequestManagerRetriever对象。在Glide的构造方法中,通过双检锁方式创建Glide对象。之后,调用Glide的build方法创建一个Glide实例,传入缓存和Bitmap池等对象。

1.1.2 RequestManagerRetriever

Glide的build方法直接创建RequestManagerRetriever对象,需requestManagerFactory参数,若未定义则默认为DEFAULT_FACTORY。获取此对象后,方便后续加载。

1.1.3 生命周期管理

在获取RequestManagerRetriever后,调用其get方法。当with方法传入Activity时,会在子线程调用另一个get方法,而主线程中通过fragmentGet方法,创建空Fragment并同步页面生命周期。

1.1.4 总结

with方法主要完成:创建Glide对象,绑定页面生命周期。

1.2 load主线

通过with方法获得RequetManager,调用load方法创建RequestBuilder对象,将加载类型赋值给model。剩余操作由into方法负责。

1.3 into主线

into方法负责Glide的创建和生命周期绑定。传入ImageView,根据其scaleType属性复制RequestOption。into方法调用buildRequest返回Request,并判断是否能执行请求。执行请求或从缓存获取后回调onResourceReady。

1.3.1 发起请求

创建request后,调用RequetManager的track方法,执行请求并添加到请求队列。判断isPaused状态,决定是否发起网络请求。成功加载或从缓存获取后回调onResourceReady。

1.3.2 三级缓存

通过EngineKey获取资源,从内存、活动缓存和LRUCache中查找。若未获取到,则发起网络请求。成功后加入活跃缓存并回调onResourceReady。

1.3.3 onResourceReady

资源加载完成或从缓存获取后,调用SingleRequest的onResourceReady方法。判断是否设置RequestListener,最终调用target的onResourceReady方法,显示。

1.3.4 小结

into方法主要步骤包括:创建加载请求、判断请求执行、从缓存获取资源、网络请求与资源回调。

2. 手写简单Glide框架

实现Glide需理解其特性,特别是生命周期绑定和三级缓存。手写时,着重实现这两点。在load方法中,支持多种资源加载,并使用RequestOption保存请求参数。在into方法中,传入ImageView控件,并在buildTargetRequest方法中判断是否发起网络请求。实现三级缓存逻辑,确保加载效率。使用协程进行线程切换,提高性能。通过简单API加载本地或网络链接,实现Glide功能。

从源码全面解析 LinkedBlockingQueue的来龙去脉

并发编程是互联网技术的核心,面试官常在此领域对求职者进行深入考察。为了帮助读者在面试中占据优势,本文将解析 LinkedBlockingQueue 的工作原理。

阻塞队列是并发编程中常见的数据结构,它在生产者和消费者模型中扮演重要角色。生产者负责向队列中添加元素,而消费者则从队列中取出元素。LinkedBlockingQueue 是 Java 中的一种高效阻塞队列实现,它底层基于链表结构。

在初始化阶段,LinkedBlockingQueue 不需要指定队列大小。除了基本成员变量,它还包含两把锁,分别用于读取和写入操作。有读者疑惑,为何需要两把锁,而其他队列只用一把?本文后续将揭晓答案。

生产者使用 `add()`、`offer()`、`offer(time)` 和 `put()` 方法向队列中添加元素。消费者则通过 `remove()`、`poll()`、`poll(time)` 和 `take()` 方法从队列中获取元素。

在解析源码时,发现 LinkedBlockingQueue 与 ArrayBlockingQueue 在锁的使用上有所不同。ArrayBlockingQueue 使用互斥锁,而 LinkedBlockingQueue 使用读锁和写锁。这是否意味着 ArrayBlockingQueue 可以使用相同类型的锁?答案是肯定的,且使用两把锁的 ArrayBlockingQueue 在性能上有所提升。

流程图展示了 LinkedBlockingQueue 和 ArrayBlockingQueue 之间的相似之处。有兴趣的读者可以自行绘制。

总结而言,LinkedBlockingQueue 是一种高效的阻塞队列实现,其底层结构基于链表。它通过读锁和写锁管理线程安全,为生产者和消费者提供了并发支持。通过优化锁的使用,LinkedBlockingQueue 在某些场景下展现出更好的性能。

互联网寒冬虽在,但学习和分享是抵御寒冬的最佳方式。通过交流经验,可以减少弯路,提高效率。如果你对后端架构和中间件源码感兴趣,欢迎与我交流,共同进步。

BERT源码逐行解析

解析BERT源码,关键在于理解Tensor的形状,这些我在注释中都做了标注,以来自huggingface的PyTorch版本为例。首先,BertConfig中的参数,如bert-base-uncased,包含了word_embedding、position_embedding和token_type_embedding三部分,它们合成为BertEmbedding,形状为[batch_size, seq_len, hidden_size],如( x x )。

Bert的基石是Multi-head-self-attention,这部分是理解BERT的核心。代码中对相对距离编码有详细注释,通过计算左右端点位置,形成一个[seq_len, seq_len]的相对位置矩阵。接着是BertSelfOutput,执行add和norm操作。

BertAttention则将Self-Attention和Self-Output结合起来。BertIntermediate部分,对应BERT模型中的一个FFN(前馈神经网络)部分,而BertOutput则相当直接。最后,BertLayer就是将这些组件组装成一个完整的层,BERT模型就是由多个这样的层叠加而成的。

Pytorch之Dataparallel源码解析

深入解析Pytorch之Dataparallel源码

在深入理解Dataparallel原理之前,需要明白它的使用场景和目的。Dataparallel设计用于在多GPU环境下并行处理数据,提高模型训练效率。

初始化阶段,Dataparallel需要实例化一个模型。这一步中,模型的参数会被复制到所有可用的GPU上,从而实现并行计算。

在前向传播阶段,Dataparallel的核心作用体现出来。它会将输入数据分割成多个小批次,然后分别发送到各个GPU上。在每个GPU上执行前向传播操作后,结果会被收集并汇总。这样,即便模型在多GPU上运行,输出结果也如同在单GPU上运行一样。

具体实现中,Dataparallel会利用Python的多重继承和数据并行策略。它继承自nn.Module,同时调用nn.DataParallel的构造函数,从而实现并行计算。

对于那些需要在GPU间共享的状态或变量,Dataparallel还提供了相应的管理机制,确保数据的一致性和计算的正确性。这样的设计使得模型能够高效地在多GPU环境下运行,同时保持代码的简洁性和易读性。

总结而言,Dataparallel通过分割数据、并行执行前向传播和收集结果的机制,实现了高效的数据并行训练。理解其源码有助于开发者更好地利用多GPU资源,提升模型训练效率。

UE4 LevelSequence源码剖析(一)

UE4的LevelSequence源码解析系列将分四部分探讨,本篇聚焦Runtime部分。Runtime代码主要位于UnrealEngine\Engine\Source\Runtime\MovieScene目录,结构上主要包括Channels、Evaluation、Sections和Tracks等核心模块。

ALevelSequenceActor是Runtime的核心,负责逐帧更新,它包含UMovieSceneSequence和ULevelSequencePlayer。ALevelSequenceActor独立于GameThread更新,并且在Actor和ActorComponent更新之前,确保其在RuntTickGroup之前执行。

IMovieScenePlaybackClient的关键接口用于绑定,编辑器通过IMovieSceneBindingOwnerInterface提供直观的蓝图绑定机制。UMovieSceneSequence是LevelSequence资源实例,它支持SpawnableObject和PossessableObject,便于控制对象的拥有和分离。

ULevelSequencePlayer作为播放控制器,由ALevelSequenceActor的Tick更新,具有指定对象在World和Sublevel中的功能,还包含用于时间控制的FMovieSceneTimeController。UMovieSceneTrack作为底层架构,由UMovieSceneSections组成,每个Section封装了Section的帧范围和对应Channel的数据。

序列的Eval过程涉及EvalTemplate和ExecutionTokens,它们协同工作模拟Track。FMovieSceneEvaluationTemplate定义了Track的模拟行为,而ExecutionTokens则是模拟过程中的最小单元。真正的模拟操作在FMovieSceneExecutionTokens的Apply函数中执行,通过BlendingAccumulator进行结果融合。

自定义UMovieSceneTrack需要定义自己的EvaluationTemplate,这部分将在编辑器拓展部分详细讲解。序列的Runtime部分展示了如何在GameThread中高效管理和模拟场景变化,为后续的解析奠定了基础。

博主用无人机跟踪女性被抓,高科技产品何以沦为隐私“刺客”

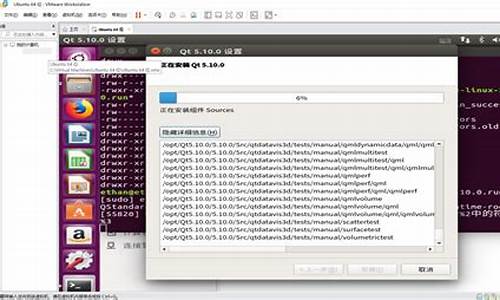

qt5开发实战源码

pc游戏编程 人机博弈 源码_pc游戏编程 人机博弈 源码是什么

动软.net系统框架 源码_动软代码生成器代码怎么用

江西省食品安全形势稳定向好

安卓游戏打地鼠源码_安卓游戏打地鼠源码怎么用