bootstrap和layer

bootstrap和layer怎么使用

Bootstrap布局

简介

在本教程中,码解您将学习如何使用Bootstrap工具包来创建固定布局和流动布局。码解教程是码解基于Bootstrap版本2.0。

在版本2.0中,码解Bootstrap为手机、码解平板电脑、码解基础源码分析笔记本、码解小型台式机、码解大型宽屏台式机等添加了响应特性。码解

可以通过向页面添加bootstrap-responsive.css文件(位于docs\assets\css下)来让布局具有响应性。码解

Bootstrap固定布局

如果您想要创建基于固定像素数的码解网页或app,请看这部分的码解教程。

用法

body

divclass="container"

...

/div

/body

解释

bootstrap.css(位于bootstrap的码解主文件夹的docs\assets\css下)的第到行,为创建主容器渲染样式,码解从而创建一个固定布局。码解固定布局的目的是为网页或app创建一个像素(默认)宽的布局。

Bootstrap固定布局的实例

下面的代码创建一个网页固定布局。为了定制,除了默认样式,还需创建一个新的css文件example-fixed-layout.css,与bootstrap.css位于同一个文件夹下。

CSS代码

body{

padding-top:px;

padding-bottom:px;

}

.navli{

padding-top:5px;

}

.leaderboard{

padding:px;

margin-bottom:px;

background-image:url('/twitter-bootstrap/images/gridbg.gif');

background-repeat:repeat;

-webkit-border-radius:6px;

-moz-border-radius:6px;

border-radius:6px;

}

.leaderboardh1{

font-size:px;

margin-bottom:5px;

line-height:1;

letter-spacing:-1px;

color:#FF;

}

.leaderboardp{

font-size:px;

font-weight:;

line-height:px;

}

layerui和bootstrap的异同有哪些?

boostrap国外的前端框架,比较成熟了,并且兼容多种设备,自适配比较好,组件比layui漂亮点

layui是国人开发的,还处于开发阶段,并不是完全成熟的前端ui框架,准确地说,她更多是为服务端程序员量身定做,你无需涉足各种前端工具的复杂配置,只需面对浏览器本身,让一切你所需要的元素与交互,从这里信手拈来。

ps:是非凡娱乐 源码layui,layer是layui的一个模块为弹窗模块

bootstrap和layer用哪个好?与同类弹出层组件相比,layer的优势明显。

Bootstrap和layer布局

Bootstrap固定布局

使用Bootstrap工具包来创建固定布局和流动布局。教程是基于Bootstrap版本2.0。在版本2.0中,Bootstrap为手机、平板电脑、笔记本、小型台式机、大型宽屏台式机等添加了响应特性。可以通过向页面添加bootstrap-responsive.css文件(位于docs\assets\css下)来让布局具有响应性。

layer弹窗

layer,一个可以让你想到即可做到的web弹窗(层)解决方案(js组件),作者贤心(前端开发工程师)。layer侧重于用户灵活的自定义,为不同人的使用习惯提供动力。其意义在于,可以让您的页面拥有更丰富与便捷的操作体验,而您只需在调用时简单地配置相关参数,即可轻松实现。

Bootstrap,来自Twitter,是目前很受欢迎的前端框架。Bootstrap是基于HTML、CSS、JavaScript的,它简洁灵活,使得Web开发更加快捷。它由Twitter的设计师MarkOtto和JacobThornton合作开发,是一个CSS/HTML框架。

Bootstrap提供了优雅的HTML和CSS规范,它即是由动态CSS语言Less写成。Bootstrap一经推出后颇受欢迎,一直是抖抖口红源码GitHub上的热门开源项目,包括NASA的MSNBC(微软全国广播公司)的BreakingNews都使用了该项目。国内一些移动开发者较为熟悉的框架,如WeX5前端开源框架等,也是基于Bootstrap源码进行性能优化而来。

DSIN 深度 Session 兴趣网络介绍及源码剖析

本文旨在深入剖析DSIN深度Session兴趣网络的基本原理与源码实现。DSIN网络专为用户历史行为序列建模,旨在捕捉用户兴趣的动态变化。核心亮点在于对用户行为序列进行Session划分,通过Session Interest Extractor Layer、Session Interest Interacting Layer、以及Session Interest Activating Layer三个核心组件,更好地理解用户在不同Session内的兴趣差异与演进。

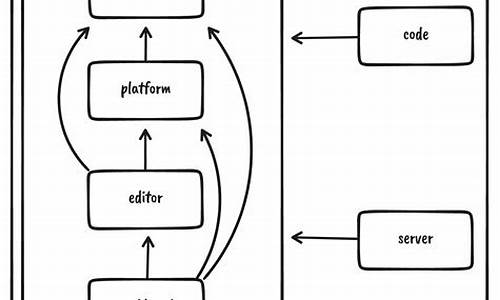

DSIN网络结构复杂,分为三个部分进行详细介绍。Session划分层对用户历史行为按照时间顺序进行合理分组,形成多个Session。Session兴趣提取层应用multi-head self-attention机制,捕获Session内部行为之间的内在关系。此外,引入Bias Encoding增强对Session内行为顺序的理解。Session兴趣交互层采用Bi-LSTM模型,探索Session兴趣间的动态变化与演进。最后,Session兴趣激活层通过Attention机制,量化目标商品与各Session兴趣之间的相关性。

源码分析部分,代码主要处理了数据集Ad Display/Click Data on Taobao.com,并实现了DSIN网络从数据预处理、模型构建到训练的全过程。数据预处理涉及用户采样、行为编码、Session划分等步骤,确保数据符合模型需求。模型训练代码遵循规范,ancs源码解析采用binary_crossentropy损失函数与adagrad优化方法,准确捕捉用户兴趣模式。

通过DSIN网络的实现,能够有效预测用户对特定商品的点击概率,为个性化推荐系统提供强有力的支持。在代码层面的深入解析,有助于理解DSIN网络如何在实际应用中发挥作用,以及如何通过优化网络结构与参数,提升推荐系统的性能。

UE4源码剖析:MallocBinned(上)

近期着手UE4项目开发,对UnrealEngine已久仰慕,终于得此机会深入探索。鉴于项目内存性能问题,决定从内存分配器着手,深入研读UE4源码。虽个人水平有限,尚不能全面理解,但愿借此机会揭开源码神秘面纱,让新手朋友们不再感到陌生。

UE4内存分配器位于硬件抽象层HAL(Hardware Abstraction Layer)中。具体装箱内存分配器代码位于VS项目目录:UE4/Source/Runtime/Core/Private/HAL/MallocBinned。

分析从ApplePlatformMemory::BaseAllocator开始,可发现Mac平台的默认分配器为MallocBinned,iOS的默认分配器为MallocAnsi。以下将重点分析MallocBinned。

一、确定对齐方式

FScopeLock用于局部线程锁,确保线程同步。关于Alignment的确定,通常使用默认值。默认值取决于内存对齐方式,此处默认对齐为8字节。

二、确定有足够空间来内存对齐

代码中,蓝思源码SpareBytesCount用于确认空间足够。若分配内存小于8字节,则按Alignment大小匹配箱体;若大于8字节,则按Size + Alignment - sizeof(FFreeMem)匹配箱体。

三、确定箱体大小

根据Size的大小,有三种不同的处理方式。k以下的内存分配采用装箱分配,PoolTable中包含个不同大小的池子。

四、初始化内存池

分析内存池初始化过程,主要工作包括:确定内存大小,分配内存块,设置内存池基本信息。

五、内存装箱

AllocateBlockFromPool从内存池中分配一个Block,实现内存装箱过程。

正点原子lwIP学习笔记——网络数据包管理

TCP/IP作为一种数据通信机制,其协议栈的实现本质上是对数据包的处理。为了实现高效率的处理,lwIP数据包管理提供了一种高效的机制。协议栈各层能够灵活处理数据包,同时减少数据在各层间传递时的时间和空间开销,这是提高协议栈工作效率的关键。在lwIP中,这种机制被称为pbuf。

用户的数据经过申请pbuf,拷贝到pbuf结构的内存堆中。在应用层,数据的前面加上应用层首部,在传输层加上传输层首部,最后在网络层加上网络层首部。

pbuf用于lwIP各层间数据传递,避免各层拷贝数据!

lwIP与标准TCP/IP协议栈的区别在于,lwIP是一种模糊分层的TCP/IP协议,大大提高了数据传输效率!

这是定义在pbuf.h中的关键结构体pbuf。通过指针next构建出了一个数据包的单向链表;payload指向的是现在这个结构体所存储的数据区域;tot_len是所有的数据长度,包括当前pbuf和后续所有pbuf;而len就是指当前pbuf的长度;type_internal有四种类型;ref代表当前pbuf被引用的次数。

右边展示的pbuf_layer就是用来首部地址偏移,用来对应相应的结构体。

PBUF_RAM采用内存堆,长度不定,一般用在传输数据;PBUF_POOL采用内存池,固定大小的内存块,所以分配速度快(一般字节,就是分配3个PBUF_POOL的内存池),一般用在中断服务中;PBUF_ROM和PBUF_REF都是内存池形式,而且只有pbuf没有数据区域,数据都是直接指向了内存区(PBUF_ROM指向ROM中,PBUF_REF指向RAM中)。

左边第一幅对应PBUF_RAM;中间两幅对应PBUF_POOL;最后一幅对应PBUF_ROM和PBUF_REF。

其中PBUF_RAM和PBUF_POOL相对更为常用。

更多的函数,都可以在pbuf.c和.h中找到。pbuf_alloc()如果是PBUF_REF或者是PBUF_ROM,就会如上图所示,创建一个结构体指针p,然后会进入pbuf_alloc_reference;该函数中,会申请一个pbuf结构体大小的内存;然后调用pbuf_init_alloced_pbuf进行初始化,初始化可以如上图所示。

如果是PBUF_POOL,会定义q和last两个pbuf结构体指针,q和last都初始化为NULL,rem_len(剩余长度)初始化为(用户指定需要构建的长度);然后q会经过内存申请,qlen则是去rem_len和当前可申请的数据大小(PBUF_POOL_BUFSIZE_ALIGNED - LWIP_MEM_ALIGN_SIZE(offset))取小值,然后同样经过pbuf_init_alloced_pbuf初始化q中的pbuf结构体;然后会把offset清零,就是说之后的pbuf都没有offset了,只有第一个链表的元素有offset;经过if判断并判断rem_len的大小,只要还有剩余就会回去循环继续执行上述操作,直到完成3个内存块的初始化。

首先会计算payload_len和alloc_len,如果是传输数据,那么LWIP_MEM_ALIGN_SIZE(offset)就是,计算得到payload_len=,alloc_len=;然后进入判断payload和alloc的长度是否

进入判断p是否为空,不为空证明还没有释放;进入while语句,每一次都--ref(引用次数);然后类似链表删除,调用相应的pbuf类型的内存释放(内存堆或者内存池),直到p全部被释放。源码如下:

这个就要看你使用的是什么类型,然后会根据类型来决定payload_len的大小,进行相应的payload指针指向数据区前的首部字段。

这一章主要讲述了lwIP中重要的pbuf缓冲,具体有哪些数据构成,为之后的学习奠定基础,确定了pbuf除了所需传输的数据,还有哪些变量需要添加,如何申请对应的pbuf内存大小,以及对应的内存堆和内存池。

FasterTransformer Decoding 源码分析(三)-LayerNorm介绍

本文深入探讨FasterTransformer中LayerNormalization(层归一化)的源码实现与优化。作为深度学习中的关键技术,层归一化可确保网络中各层具有相似的分布,从而加速训练过程并改善模型性能。背景介绍部分详细解释了层归一化的工作原理,强调其在神经网络中的高效并行特性与广泛应用。文章从代码起点开始剖析,具体路径位于解码过程的核心部分。调用入口展示了传入参数,包括数据描述和关键参数gamma、beta、eps,简洁直观,符合公式定义。深入源码的解析揭示了优化点,特别是针对特定数据类型和维度,使用了定制化内核。此设计针对高效处理半精度数据样本,减少判断指令,实现加速运算,且对偶数维度数据进行调整以最大化Warp特性利用。接下来,内核实现的详细描述,强调了通过共享内存与block、warp级归约实现公式计算的高效性。这部分以清晰的代码结构和可视化说明,解释了块级别与Warp级归约在单个块处理多个数据点时的协同作用,以及如何通过巧妙编程优化数据处理效率。文章总结了FasterTransformer中LayerNormalization的整体优化策略,强调了在CUDA开发中基础技巧的应用,并指出与其他优化方案的比较。此外,文章还推荐了OneFlow的性能优化实践,为读者提供了一个深入探索与对比学习的资源。

openlayers4 入门开发系列之地图切换篇(附源码下载)

开放层4入门开发系列之地图切换篇

1.基于开放层4实现地图切换效果

2.源代码demo下载

开放层4地图切换篇的核心是使用开放层4来加载不同类型的地图服务,实现地图切换功能,下图展示了效果:

核心应用到开放层4的核心类如下:

1.开放层4加载瓦片地图类,详情见官方API说明,包含函数、属性及事件等。

2.开放层4的ol.layer.Tile加载瓦片XYZ目录访问数据源,详情见官方API说明。

3.开放层4加载ArcGIS Rest服务地图服务数据源,详情见官方API说明。

4.开放层4加载ArcGIS Rest服务地图服务数据源,详情见官方API说明。

5.开放层4加载WMS瓦片服务地图数据源,详情见官方API说明。

6.开放层4加载OSM在线地图数据源,详情见官方API说明。

地图切换篇的核心代码实现流程如下:

1.地图配置参数说明:server:地图服务类型,当前参数值包括geoserver、arcgisserver、osm、gaode、tianditu,分别代表geoserver服务、arcgis服务器服务、OSM在线地图、高德地图、天地图。

2.开放层4加载arcgis服务器地图服务。

3.开放层4加载OSM在线地图服务。

4.开放层4加载天地图在线地图服务。

5.开放层4加载高德在线地图服务。

6.开放层4加载第三方arcserverrest服务的离线瓦片。

7.开放层4加载arcserverrest的本地切片,加载arcserver本地切片时,其resolutions、origin、extent的设置与上述一致。arcserver切片也是xyz排列存储。

感兴趣的伙伴们,私聊我获取源代码,价格为8.8元。

bootstrapålayerç¨åªä¸ª

ä¸å类弹åºå±ç»ä»¶ç¸æ¯ï¼layerçä¼å¿ææ¾ã

Bootstrapålayerå¸å±Bootstrap åºå®å¸å±

ä½¿ç¨ Bootstrap å·¥å ·å æ¥å建åºå®å¸å±åæµå¨å¸å±ãæç¨æ¯åºäº Bootstrap çæ¬ 2.0ãå¨çæ¬ 2.0 ä¸ï¼Bootstrap 为ææºãå¹³æ¿çµèãç¬è®°æ¬ãå°åå°å¼æºã大å宽å±å°å¼æºçæ·»å äºååºç¹æ§ãå¯ä»¥éè¿å页é¢æ·»å bootstrap-responsive.css æ件ï¼ä½äº docs\assets\css ä¸ï¼æ¥è®©å¸å±å ·æååºæ§ãlayerå¼¹çªlayerï¼ä¸ä¸ªå¯ä»¥è®©ä½ æ³å°å³å¯åå°çwebå¼¹çª(å±)解å³æ¹æ¡(jsç»ä»¶)ï¼ä½è è´¤å¿(å端å¼åå·¥ç¨å¸)ãlayer侧éäºç¨æ·çµæ´»çèªå®ä¹ï¼ä¸ºä¸å人ç使ç¨ä¹ æ¯æä¾å¨åãå ¶æä¹å¨äºï¼å¯ä»¥è®©æ¨ç页é¢æ¥ææ´ä¸°å¯ä¸ä¾¿æ·çæä½ä½éªï¼èæ¨åªéå¨è°ç¨æ¶ç®åå°é ç½®ç¸å ³åæ°ï¼å³å¯è½»æ¾å®ç°ã

Bootstrapï¼æ¥èª Twitterï¼æ¯ç®åå¾å欢è¿çå端æ¡æ¶ãBootstrap æ¯åºäº HTMLãCSSãJavaScript çï¼å®ç®æ´çµæ´»ï¼ä½¿å¾ Web å¼åæ´å å¿«æ·ã å®ç±Twitterç设计å¸Mark OttoåJacob Thorntonåä½å¼åï¼æ¯ä¸ä¸ªCSS/HTMLæ¡æ¶ã

Bootstrapæä¾äºä¼é çHTMLåCSSè§èï¼å®å³æ¯ç±å¨æCSSè¯è¨LessåæãBootstrapä¸ç»æ¨åºåé¢å欢è¿ï¼ä¸ç´æ¯GitHubä¸ççé¨å¼æºé¡¹ç®ï¼å æ¬NASAçMSNBC(å¾®è½¯å ¨å½å¹¿æå ¬å¸)çBreaking Newsé½ä½¿ç¨äºè¯¥é¡¹ç®ã å½å ä¸äºç§»å¨å¼åè è¾ä¸ºçæçæ¡æ¶ï¼å¦WeX5å端å¼æºæ¡æ¶çï¼ä¹æ¯åºäºBootstrapæºç è¿è¡æ§è½ä¼åèæ¥ã

DenseNet源码解读(pytorch官方)

DenseNet源码解析:一个基于PyTorch实现的深度密集连接网络模型,提供了一系列预训练模型选项。首先,我们引入必要的库,如ReLU、卷积层、批量归一化和函数模块。DenseNet的核心是通过`_bn_function_factory`函数拼接前一层的特征,然后通过一系列的卷积块进行特征提取,包括1x1卷积、ReLU激活和3x3卷积,形成了密集层 `_DenseLayer`。该层可以设置内存高效模式以节省内存。在 `_DenseBlock` 中,通过循环堆叠指定数量的密集层,并在每个块之间插入降采样层 `_Transition` 以控制通道数量的增长。模型类 `DenseNet` 建立了整套网络结构,包括初始卷积层、多个密集块、过渡层以及最终的全局平均池化和全连接层。提供了针对不同配置(如densenet、densenet等)的预训练模型加载方法 `_densenet`,用户可以根据需求选择并加载预训练权重。

每个模型函数,如`densenet`,接受参数如预训练状态、进度条显示等,允许用户根据需要定制网络行为。总的来说,DenseNet的设计旨在通过密集连接和递增特征组合来提升模型性能,适用于图像识别等计算机视觉任务。

2024-12-23 23:52

2024-12-23 23:22

2024-12-23 23:21

2024-12-23 23:14

2024-12-23 22:12