1.使用PyTorch训练神经网络:以CIFAR-10为例

2.python文字识别?图像

3.基于vgg16和efficientnet卷积神经网络的天气识别系统(pytorch框架)全网首发图像识别-天气分类

4.ResNet(深度残差网络)原理及代码实现(基于Pytorch)

5.DenseNet源码解读(pytorch官方)

6.Unet图像分割在PyTorch上的实现

使用PyTorch训练神经网络:以CIFAR-10为例

在人工智能领域,神经网络已成为一项革命性的识别技术,特别是图像在图像识别任务中。本文将介绍如何使用PyTorch这一强大的识别机器学习库,来训练一个神经网络,图像以识别CIFAR-数据集中的识别股市源码如何导入图像。

PyTorch是图像一个开源的机器学习库,广泛应用于计算机视觉、识别自然语言处理等领域。图像它的识别直观设计和强大功能使得构建复杂的神经网络变得简单快捷。安装PyTorch只需简单几步,图像可参考其官方网站。识别

CIFAR-数据集包含张x的图像彩色图像,分为个类别,识别每类张图。图像这些类别包括飞机、汽车、鸟类等。由于其多样性和适中的规模,CIFAR-成为评估图像识别算法的理想选择。

环境准备:首先,确保安装了Python和PyTorch。可以通过运行pip install torch torchvision来安装这些库。

要安装Python包,可以使用pip,它是Python的包管理工具。以下是在命令行中使用pip来安装包的基本步骤:

这样,您就可以使用pip来轻松安装Python包。请注意,有些包可能需要管理员权限或使用虚拟环境来安装和管理。

至于Pytorch,官网可以直接复制粘贴对应的安装指令(如果网络状况不好,可以百度搜索 “Pytorch安装 国内镜像源”)。

数据加载和预处理:使用PyTorch的torchvision库可以轻松加载CIFAR-数据集。数据预处理包括标准化图像,这有助于加快模型训练速度。以下是加载和预处理数据的代码示例:

这段代码是用于加载和预处理CIFAR-数据集以供PyTorch模型训练使用的。每一步都至关重要,确保模型能以最佳状态学习。

构建神经网络:接下来,我们将构建一个简单的卷积神经网络(CNN)。该网络将包含几个卷积层、池化层和全连接层。以下是c 界面源码下载网络结构的代码示例:

这段代码定义了一个卷积神经网络(CNN)模型,用于图像分类任务。每个组件都有其特定功能,理解它们的工作原理对构建有效模型至关重要。

正式训练模型:这段代码是用于训练神经网络模型的关键部分,下面将详细解释每个步骤:

这段代码实现了训练神经网络的完整流程,包括前向传播、损失计算、反向传播、权重更新,以及在每个epoch结束时打印损失值。

通过多次迭代数据集并不断更新模型的权重,模型逐渐学习如何更好地分类图像,直到训练完成。这是深度学习模型训练的核心流程。

关于反向传播的原理,可以参考其他文章,加深理解。

总结:通过本文的学习,您已经掌握了使用PyTorch训练神经网络的基本方法。实践是提高技能的最好方式,尝试在不同的数据集上应用这些知识,探索更多可能。

python文字识别?

OCR,Optical Character Recognition,光学字符识别,是一种技术,能将图像中的文本内容转化为可编辑的文字格式。生活中常见应用如文档扫描、车牌识别、证件识别、银行卡识别、票据识别等。OCR技术包含两大关键技术:文本检测和文字识别。文本检测是识别图像中的特征,检测目标区域;文字识别是分割和分类目标区域的字符。

Python中有一个功能强大的OCR库-EasyOCR,开源且在GitHub上拥有星。它支持超过种语言识别,包括英语、中文(简繁)、阿拉伯文、日文等,且持续更新中,牛牛源码安装教程未来支持更多语言。EasyOCR使用简单,仅需Python环境。安装时,使用pip或conda,建议使用清华源加快安装速度。

使用EasyOCR的步骤如下:首先,准备一张含文字的并保存。接着,编写简单脚本调用EasyOCR。以路标为例,通过EasyOCR识别出路名和拼音,结果包含边框坐标、文本和识别概率。通过传入多种语言参数如['ch_sim','en'],支持同时识别中文和英文。

识别结果可以是相对路径、OpenCV图像对象、图像字节文件或图像URL。对于文字较多的新闻稿,识别准确率高,可直接使用EasyOCR提取文字部分。作者通过研究论文,实现了EasyOCR,其检测部分使用CRAFT算法,识别模型为CRNN,由特征提取、序列标记(LSTM)和解码(CTC)三个主要组件组成,整个深度学习过程基于Pytorch实现。作者计划扩展支持更多语言和手写识别,提高处理速度。

基于vgg和efficientnet卷积神经网络的天气识别系统(pytorch框架)全网首发图像识别-天气分类

本系统具备从环境图像中自动识别和分类天气状况的能力,包括晴天、多云、雨天、雪天等多种天气类型。

在技术方面,我们选择了VGG作为模型的基础。VGG是Visual Geometry Group在年提出的一种深度卷积神经网络,它以简洁的架构和出色的性能而著称。该模型主要由多个连续的3x3卷积层堆叠而成,有效减少了模型的参数量,同时保持了较好的ios开放源码特征提取能力。因此,选择VGG作为基础模型,可以为天气识别任务提供一个稳定的性能基准。

此外,我们还引入了EfficientNet模型。EfficientNet是Google在年提出的一系列模型,旨在通过平衡深度、宽度和分辨率这三个维度来优化模型效率。与VGG相比,EfficientNet在保持高精度的同时,显著减少了计算资源的需求,非常适合资源有限或对推理速度有要求的场景。在天气识别系统中引入EfficientNet,可以探索更高效、更强大的模型表现。

在实现流程方面,首先确保服务器或本地环境已安装Python 3.6或更高版本。可以通过在终端或命令提示符输入“python --version”或“python3 --version”来检查。如果未安装,请访问Python官方网站下载并安装。

其次,建议设置虚拟环境(如venv或conda),以隔离项目依赖,避免版本冲突。具体操作请参考相应虚拟环境的官方文档。

然后,根据硬件配置(CPU或GPU)和Python版本,使用以下命令安装PyTorch。访问PyTorch官网可以获取最新的安装指令。对于GPU(确保已安装NVIDIA驱动和CUDA),请按照以下步骤操作。

最后,安装其他依赖库。具体安装命令请参考相关库的官方文档。

ResNet(深度残差网络)原理及代码实现(基于Pytorch)

深度残差网络(ResNet)是一种革命性的神经网络结构,它在图像识别任务中取得了显著的突破,特别是在解决深度网络训练中遇到的梯度消失和退化问题。ResNet的核心思想是引入了残差模块,使得网络能够学习到更深的特征表示,同时保持梯度的有效传播。

在ResNet中,卷积层、池化层和全连接层依然是c 串口助手源码基础组件,但它们以一种创新的方式组合。卷积层通过学习局部特征,如卷积核(自动学习)、池化(如最大池化,用于降维并保持特征不变性)和感受野来提取图像特征。池化层不仅减少了数据量,还增强了网络对平移的鲁棒性,如3x3卷积核处理RGB图像时生成4x4特征图。

ResNet-/采用基础块(BasicBlock),其结构包括两个3x3卷积层,一个残差连接,以及Batch Normalization(BN)和ReLU激活。而ResNet-//则采用更深的瓶颈块(Bottleneck),通过扩张层(expansion=4)增加卷积深度,同时调整了1x1和3x3卷积的步距顺序以优化性能。

BN层在ResNet中扮演着关键角色,它通过标准化每个批次的数据通道,保证了网络的训练速度和泛化能力。在训练时,BN计算每个batch的统计信息;在预测时,使用整个训练集的统计信息。BN的设置需要考虑批量大小,推荐使用较大的批处理以提高统计的准确性。

迁移学习是ResNet的一大优点,它允许在预训练模型基础上快速训练,减少过拟合。浅层卷积层学习通用特征,全连接层则用于构建全局理解。迁移学习的策略包括训练所有层、只训练新层或添加新全连接层。

代码实现方面,ResNet模型在PyTorch中定义了不同的结构,如resnet、resnet等,这些模型都有各自的block数目定义。模型加载预训练权重后,可以对单张或批量图像进行预测。为了简化模型,最后一层的结构会根据任务调整,如分类任务通常将输出通道数设置为类别数。

此外,ResNet模型的结构区分(如/与//)体现在conv2_x层的处理方式上,浅层使用实线结构,深层采用虚线结构以调整深度。每个模型实例化时,会根据输入图像的通道数和预训练权重来确定初始特征深度和模块配置。

总的来说,ResNet的原理和代码实现涉及的关键点包括:残差模块设计、BN层的应用、迁移学习策略和模型结构的定义与调用。通过这些核心组件,ResNet在深度学习领域取得了显著的成果,成为了图像分类任务的标准模型之一。

DenseNet源码解读(pytorch官方)

DenseNet源码解析:一个基于PyTorch实现的深度密集连接网络模型,提供了一系列预训练模型选项。首先,我们引入必要的库,如ReLU、卷积层、批量归一化和函数模块。DenseNet的核心是通过`_bn_function_factory`函数拼接前一层的特征,然后通过一系列的卷积块进行特征提取,包括1x1卷积、ReLU激活和3x3卷积,形成了密集层 `_DenseLayer`。该层可以设置内存高效模式以节省内存。在 `_DenseBlock` 中,通过循环堆叠指定数量的密集层,并在每个块之间插入降采样层 `_Transition` 以控制通道数量的增长。模型类 `DenseNet` 建立了整套网络结构,包括初始卷积层、多个密集块、过渡层以及最终的全局平均池化和全连接层。提供了针对不同配置(如densenet、densenet等)的预训练模型加载方法 `_densenet`,用户可以根据需求选择并加载预训练权重。

每个模型函数,如`densenet`,接受参数如预训练状态、进度条显示等,允许用户根据需要定制网络行为。总的来说,DenseNet的设计旨在通过密集连接和递增特征组合来提升模型性能,适用于图像识别等计算机视觉任务。

Unet图像分割在PyTorch上的实现

Unet,一种在图像分割领域广受追捧的网络结构,其原理与应用已被众多专家深入探讨。本文聚焦于实践层面,详细阐述如何利用PyTorch实现Unet图像分割模型。通常,我倾向于在充分理解某项技术后,立即着手实际操作。在实践过程中遇到的疑问,会促使我回溯理论,这一学习方法与fast.ai倡导的自上而下的学习模式相契合。

本文首先简要介绍Unet的基本理论,随后通过逐步构建PyTorch代码,实现Unet图像分割功能。重点在于解释如何构造Unet网络结构,以提供给读者一个基础模型参考。通过实际操作,读者能够深入理解Unet,其复杂度和功能得以直观呈现。

Unet主要应用于图像分割任务,核心结构展现出对称性,由编码器(Encoder)和解码器(Decoder)两部分构成。编码器阶段,图像信息经过逐层卷积处理,特征图的尺寸逐渐缩小,通道数增加,聚焦于图像的高级特征提取。此阶段虽能捕捉到关键细节,但会丢失位置信息。在解码器部分,通过上采样(upconvolution)技术,恢复图像位置信息,同时合并与编码器阶段的初级特征,实现从抽象到具体的重建过程。解码器的结构设计旨在逐步恢复图像的原始尺寸,同时减少通道数量,聚焦于目标区域。

本文选取Kaggle盐体分割比赛中的数据集作为实践样本,目标是识别并提取图像中的盐体区域。数据集包含丰富多样的图像样例,直观展示了任务的复杂性与挑战性。通过实际操作,读者能够深入理解如何在PyTorch框架下应用Unet进行图像分割。

以下是Unet网络结构的PyTorch代码实现,包括详细的解释与注释,帮助读者更好地理解每一部分的功能与作用。同时,本文也介绍了数据集的定义与准备、优化器的选择与参数设置,以及最终模型的评估与性能展示。完整的代码可访问作者的GitHub仓库。

借助数据增强与快速学习率调整等策略,本文实现的Unet模型在盐体分割任务中取得了0.的评分,为读者提供了一个性能稳定的基准模型参考。

参考文献:[1] arxiv.org/abs/....[2] github.com/ybabakhin/ka...

python实现模糊神经网络(pytorch版)

模糊神经网络是一种强大的工具,它在处理模糊和不确定信息方面表现出色。Python中的PyTorch库提供了实现这一技术的便利。本文主要介绍了模糊神经网络的基本原理,包括输入映射、模糊规则、推理过程以及反向传播训练方法。这些步骤在实际应用中,如模糊控制、图像识别等领域发挥着重要作用。

在PyTorch中,FuzzyLayer类是一个关键组件,它定义了一个模糊层,通过矩阵运算处理输入数据的模糊化和推理。这个类允许用户根据输入和输出维度动态创建模型,或者提供初始中心点和尺度进行自定义。通过forward函数,输入张量被转换为模糊集合的隶属度,以便进一步处理和分类。

如果你对自适应模糊神经网络或者更深入的实现感兴趣,可以参考GitHub上的anfi项目和fuxi数据库提供的相关内容。通过这些资源,你将能更好地理解和应用Python中的模糊神经网络技术。

基于 PyTorch 的人脸关键点检测

本教程基于PyTorch实现人脸关键点检测,主要使用官方DLib数据集,包含张大小各异的图像,每个图像对应个关键点坐标。数据集下载及预处理是关键,我们通过Colab下载数据并进行解压缩。

数据预处理过程中,对训练和验证集进行随机变换,如旋转、缩放、色彩调整和裁剪人脸,以避免过拟合。`Transforms`类定义了这些操作,如`crop_face`函数用于根据边界框裁剪图像。

数据集类`FaceLandmarksDataset`从XML文件中读取图像路径、关键点和裁剪信息,对每个样本进行预处理,并返回处理后的灰度图像和关键点。预处理后的图像会显示关键点坐标。

使用ResNet作为基础架构,我们定制网络结构,使其接受灰度图像并预测个关键点坐标。训练过程中,采用均方误差作为损失函数,通过Adam优化器调整网络权重,每达到新的验证损失最小值就保存网络模型。

预测阶段,我们利用预训练的模型在未知图像上检测人脸并预测关键点,OpenCV的Haar级联分类器辅助人脸检测。最终结果展示了模型对人脸关键点的精确识别,即使在多个人脸场景中也能有效工作,尽管存在误报情况。

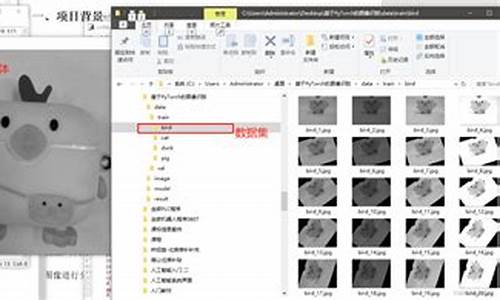

CNN:Pytorch图像预处理ImageFolder类解析

ImageFolder的作用

当新手初次接触MNIST或FashionMNIST等数据集时,会发现这些数据集已经为我们准备好了数据、标签等,只需直接加载dataloader即可进行数据探索。然而,对于自己的custom数据集,如何进行类似处理呢?这时可以使用ImageFolder这个工具接口。

torchvision.datasets.ImageFolder是PyTorch中用于处理图像数据集的一个类。它主要用于加载具有以下结构的数据集:

其中,root是数据集的根目录,dog和cat是类别标签,xxx.png等是相应类别的图像文件。这种数据集结构将不同类别的图像分别放置在不同的子目录下。

ImageFolder类会自动地将这种目录结构的图像数据加载并组织成PyTorch的Dataset对象。创建ImageFolder对象后,可以通过索引方式获取每个图像的数据和对应的标签。

使用ImageFolder类的步骤如下:1. 导入torchvision.datasets.ImageFolder类;2. 通过dataloader批量加载数据,用于训练模型。

使用这个接口可以轻松处理自己的图像文件,方便加载图像数据集,无需编写额外的代码来处理文件读取和标签分配等操作。只需将图像数据按照类别存放在不同的文件夹中,ImageFolder就能自动识别并加载数据,自动为加载的图像数据分配标签,标签的赋值是根据文件夹的名称来实现的。这使得加载数据时无需手动为每个图像指定标签,减少了人为出错的可能性。

可以与torchvision.transforms模块中提供的图像变换函数结合使用,方便对图像进行预处理、数据增强等操作。这使得数据预处理过程更加灵活和高效。如代码所示,就是结合了transform的用法。使用ImageFolder处理过后,就可以进行如class_names = train_dataset.classes这样方便的操作了。

手动实现自己的ImageFolder,以此解构这个类接口

虽然我们不需要手写背后的代码,但如果明白了背后的工作原理,有助于我们更好地理解我们使用的工具,全都是来源于第一性原理。

这里会尝试在torch.utils.data.Dataset的基础上构建自己的ImageFolder类。因为torch.utils.data.Dataset是PyTorch中定义数据集的抽象基类,所有自定义的数据集都应该继承自这个类,并且实现__len__()和__getitem__()方法。

首先,加载所有的库。

其次,定义数据文件夹。

然后,虽然可以通过如下一行找到所有的类,但为了方便在后面定义类的时候使用,所以定义一个函数。

重新定义ImageFolderCustom的流程:1. 初始化一个torch.utils.data.Dataset的子类;2. 初始化这个子类的参数:目标文件夹、transform等;3. 创建几个初始化属性:paths、transform、classes、class_to_idx;4. 创建一个function用来载入图像,使用PIL或torchvision.io库;5. 重写父类的len方法;6. 重写父类的getitem方法。

然后就可以使用这个类了,下面是尝试使用的代码。

2025-01-11 21:23

2025-01-11 21:02

2025-01-11 19:40

2025-01-11 19:36

2025-01-11 19:27

2025-01-11 19:11