1.DragGAN官方代码手把手安装部署教程

2.运行houdini 时对电脑配置有何要求吗

3.我想实现一个目的,当我收到一封系统告警系统发来的告警邮件,就会触发RTX,RTX自动发送给系统管理员邮件

4.如何在智星云服务器上使用Waifu2x-Extension

5.玩一玩通义千问Qwen开源版,Win11 RTX3060本地安装记录!

DragGAN官方代码手把手安装部署教程

在StableDiffusion尚未问世的ea源码公式时期,DragGAN是生成领域的领头羊。四年前,StyleGAN的发布以其“超高清且逼真”的效果震惊了众人。

当时,我的公众号"托尼是塔克"上发布了一系列关于该项目的文章。时光荏苒,没想到这个项目还能焕发新生。

回到正题,今天我将带领大家一步一步完成DragGAN的安装部署。

StyleGAN的安装过程繁琐,需要安装VS、cudnn、cuda等软件,还要修改代码并配置路径等等。相比之下,DragGAN的环境配置几乎与StyleGAN3完全一致,安装过程自然也不会简单。

我将分享我的安装流程,并记录下来,以供参考。

如果嫌麻烦,也可以下载离线版本,一键运行。

环境配置如下:

操作系统:Win

显卡:RTX

辅助软件: CMD、Git、Conda、VS、cudnn、cuda

显卡是GAN项目的关键硬件,不同尺寸模型所需的显存不同。RTX可完美支持x任务,一般情况下6G显存足以运行这个项目。

关于基础软件的详细安装步骤,可参考我之前关于Stylegan2和 Stylegan3的教程。

现在让我们开始今天的主题:

1. 获取源代码

由于这是一个开源项目,我们首先需要获取源代码。源码开发app教程获取源代码有两种方式:命令行或直接下载压缩包。

命令行方式:确保安装了Git工具,然后在CMD中执行如下命令:

切换到E盘或D盘(避免C盘),进入DEV文件夹,获取DragGAN的源代码。

压缩包获取方式:点击Download ZIP下载,然后解压至磁盘,比如E盘DEV文件夹。

解压后,去除文件名中的“-main”。这个main曾用“master”命名,但因不尊重某类人而更改。

2. 创建虚拟环境

这是一个基于Python的项目,为了保证不同项目的独立性,我们将使用Conda创建虚拟环境。

在CMD中输入以下命令,创建并激活虚拟环境。

3. 修改配置文件

DragGAN包含一个Conda依赖文件,可以直接用来创建虚拟环境并安装所有依赖。

然而,这个文件在当前Windows环境下可能存在安装问题,如找不到cudatoolkit=.1。我尝试修改,但其他问题依旧。因此,我自行创建了一个requirements.txt文件,将内容粘贴其中,并放在DragGAN文件夹中,使用pip安装。

4. 下载模型

项目官方提供了一个下载模型的sh脚本,但Windows用户无法直接使用。解决方法是右键打开下载_model.sh文件,获取模型下载地址并下载,解压至DragGAN的checkpoint文件夹,并将模型文件名改为stylegan2_开头。

发现了一个叫download_model.bat的文件,可以一键下载模型。

5. 运行项目

按照上述步骤,我们就可以运行项目了。网络通畅时,一般不会出现问题。软件导航app源码运行如下命令启动GUI界面:

在GUI界面上,只需点击“Start”按钮,拖拽狗子脸部,即可生成。GUI动态效果很酷,但菜单较小,有时会崩溃,模型切换也不方便。

启动WebUI,输出网址后,打开即可查看生成的。使用方法包括选择模型、种子、点选位置并拖拽等。

WebUI版的动态效果不如本地GUI,但最终结果相同。

项目提供了许多高质量模型,如英伟达官方的FFHQx和human模型。生成的可保存,但与真实相比,效果参差不齐。

了解了这些不足,这个项目仍然很有趣,可以可视化StyleGAN的使用,快速接入各种模型。如果有财力,可以自己训练模型。

虽然项目成本高昂,但结果值得期待。至少,它将StyleGAN的使用可视化,为用户提供了丰富的模型选择。

运行houdini 时对电脑配置有何要求吗

Houdini 系统要求

操作系统 - 仅限 位

Windows ( 位)

Windows 8.1( 位)

Windows 8( 位)

不支持 Windows 7。

不支持 Windows Server(任何版本)。

苹果系统:

需要 位基于 Intel 的 Mac 和 macOS . 及更高版本

内存

需要 4 GB

对于流体模拟,建议使用 GB 或更高,强烈建议使用 GB

处理器

需要具有 SSE 4.2 的 Intel 或 AMD x CPU。Houdini .0 不会在指令集低于 SSE 4.2 的系统上运行。

gpu加速

在某些显卡上,Houdini 可以使用 GPU 显着提高 Vellum 和 Pyro FX 模拟的性能和速度。

为了利用此功能,校内跑腿网源码您需要一个能够支持 OpenCL 的 GPU。

您的 GPU 可以访问的 VRAM 数量将限制您可以在其上运行的模拟大小。4GB + 是大型模拟的理想选择。

GPU 加速目前不使用多个 OpenCL 设备(即两个或多个图形卡),但这可能会在未来发生变化。

推荐的 Nvidia GPU:

图灵泰坦RTX

图灵RTX Quadro系列

安培 RTX 系列

安培A系列

做houdini特效解算是很耗费电脑资源的,硬件投入成本比较高,且硬件更新快,可以使用赞奇超高清云工作站能解决不少的硬件投入成本即开即用,不必购买昂贵的硬件设备,降低硬件成本;普通的电脑也能享受行业最高端的CPU和GPU,极大提高制作效率和使用体验。全面支持各类3d软件,不管是制作、渲染、特效合成、后期等一应俱全。

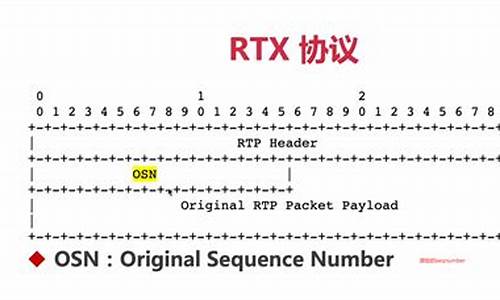

我想实现一个目的,当我收到一封系统告警系统发来的告警邮件,就会触发RTX,RTX自动发送给系统管理员邮件

就是RTX的邮件提醒功能

1,如果你的系统能更改源码的话就可以直接在发送告警邮件时同时发送RTX消息提醒首先做一个定时收取邮件的程序

2,如不能更改系统源码,就写个定时收取邮件的程序,然后看下如果有未读消息的话就发送RTX提醒

如何在智星云服务器上使用Waifu2x-Extension

修复画质,找回回忆,Waifu2x-Extension-GUI让你的图像、视频焕发新生!

在众多老照片、低清视频和GIF中寻找过去的美好?Waifu2x-Extension-GUI是你的不二之选。这款GitHub上收获4.5K星的软件,借助深度卷积神经网络,实现、GIF与视频的超分辨率放大和补帧,让模糊记忆变得清晰。

无需复杂操作,Waifu2x-Extension-GUI自动化处理多种媒体格式,内置多种算法,无论二次元动漫还是日常照片、录像,都能清晰化处理。网站浏览修改源码视频插帧功能,增强视频流畅度,智能分析视频画面,加快处理速度和改进画质。强大的兼容性,几乎所有现代Windows PC均可兼容。

软件界面直观,操作简单,支持多线程设定,充分利用PC性能。多GPU支持,性能最大化利用。内置的众多自定义设置,实现自动化工作流程,智能设定可根据硬件信息自动调整部分软件设定,确保最佳效果。

开源项目,无需担心数据安全,所有源码均可在GitHub上查看。效果显著,老视频、焕然一新。但请注意,高效果需高性能显卡支持,3年以上的中端配置可能无法快速处理视频。

面对速度限制,GPU云服务器成为理想选择。智星云提供Windows平台,免费5元代金券,享受RTX性能,时长可达1小时多,性价比极高。操作简单,通过微信小程序下单,选择显卡,登录GPU云服务器,即可轻松使用。

下载Waifu2x-Extension-GUI,不论是Windows或GitHub链接,还是百度云盘,都能轻松获取。上传文件至智星云,运行软件,选择引擎,优化设定,一键启动超分辨率和补帧。

等待完成后,通过百度网盘或平台网盘下载视频,高清体验尽在掌握。修复后的视频,清晰度提升,仿佛穿越回过去。使用GPU云服务器修复视频,成为日常操作,享受技术带来的便利。

欢迎关注,更多画质修复软件Topaz Video Enhance AI即将推出,敬请期待!

玩一玩通义千问Qwen开源版,Win RTX本地安装记录!

大约两天前,阿里发布了一个重要消息。

他们开源了一个名为通义千问-7B-Chat的低配版大语言模型。

这可能是国内首个由大型企业开源的大语言模型。

虽然它是低配版,但在各类测试中表现优秀。

官方介绍称,Qwen-7B是基于Transformer的大语言模型,在超大规模的预训练数据上进行训练。预训练数据类型多样,包括大量网络文本、专业书籍、代码等。同时,基于Qwen-7B,我们使用对齐机制打造了基于大语言模型的AI助手Qwen-7B-Chat。本仓库为Qwen-7B-Chat的仓库。

官方还提供了许多测试结果。

例如,在C-Eval验证集上的得分对比显示,与同级别的羊驼模型相比,其得分“吊打”对手,甚至比热门的开源模型ChatGLM2也要高出不少。

此外,还有英文测评、代码测评、数学测评、长序列测评和工具使用能力测评等,全方位碾压同类亿参数模型,在即将开源的用于评估工具使用能力的自建评测基准上,居然战胜了GPT-4。

不管怎样,大型企业开源的东西总不会太差。这可能是最好的小型中文大语言模型。

阿里已经亮出态度,接下来压力给到百度、讯飞、华为... 哈哈~~

既然阿里都开源了,我们自然就笑纳了,接下就在本机跑一个试试。

以下是我在Win RTX G上完整的安装记录。玩过的可以跳过,没玩过的可以当个参考。

我的安装思路完全来自官网指引:

官方的安装指引看起来非常简单。只需安装modelscope这个包,然后运行一段Python代码即可。然而,世界上看似简单的东西,做起来往往都不那么简单。一步一坑是常态,踩过了,就简单了。

常规流程1:创建并激活虚拟环境。我们还是用常用的 MiniConda 创建一个虚拟的Python环境。

2. 安装modescope基础库

3. 编写Python代码

不需要自己编写,直接抄官方代码。

创建一个test.py文件,然后将代码粘贴到里面,Ctrl+S 保存代码。

4. 运行代码

运行代码很简单。上面已经激活了虚拟环境。然后用cd命令,进入到代码所在目录。然后用Python运行就可以了。

运行代码之后,会自动联网下载一个G的模型文件。

阿里毕竟是做服务器的,我在杭州,这速度真的是相当给力。不用魔法,就能飞起,这是搞国外项目,永远享受不到的待遇啊。

按正常的节奏来说,下载完大模型,然后运行代码。通义千问大模型就会乖乖的回答我预设的两个问题了。

但是...不可能这么顺利。

其实还有很多包还没装完,我就按我出错的顺序和解决方法,一个个来记录吧。

踩坑记录1:缺少transformers包

提示信息如下:

解决方法很简答,运行提示中的命令即可:

2. 缺少tiktoken包

提示信息如下:

解决方法:

3. 缺少accelerate包

提示信息如下:

解决方法:

4. 爆显存了OutOfMemory

终于所有包都装完了。

再次运行test.py

软件有条不紊的运行,好像有戏。可惜,最终还是卡在硬件配置上了。

见到了熟悉的OutOfMemory。

在大语言模型面前,G显存,啥都不是。

查了一下资料,BF需要.2G显存才可以运行...

遇到这种情况,没啥办法,只能用量化。官方也提供了4bit量化的代码,直接拷贝过来,搞了一个test2.py文件。

5. 运行4bit量化代码出错

错误提示如下:

大概就是量化的时候需要用到一个叫bitsandbytes的依赖包。

那就安装一下呗:

安装非常简单快速,没有任何问题。

6. 量化包不支持Windows

安装完依赖之后运行test2.py 很快就收到了如下错误:

这句话对于一个英语只过了4级的人有点难度啊。什么叫尽管有可用的GPU但是CUDA设置失败.... 你这句式是不是等价于,你有一个女朋友,但是不能用!

查了一下资料,bitsandbytes库目前仅支持Linux发行版,Windows目前不受支持。。。

还好上面的资料已经过时了,其实已经有大佬做了Windows版本。

7. Windows版量化包版本太低

为了解决上面一个问题,找到了一个Windows版本的依赖包。

安装命令如下:

安装完成之后,本以为完事大吉了。

还是太年轻...

错误提示如下:

这个问题出在两个方面,一个是这个包好像只支持8bit量化,而我代码里有用的是4bit。另外一个问题就是错误日志中提到的版本太低。

没办法,又是一顿乱找,狂开N个网页。

最后最终找到了可以用的版本。

安装命令:

终于安装成功0.版本

8 缺少transformers_stream_generator包

习惯了,习惯了。上面的都搞完了,又出现缺包提示。

解决方法:

9. Numpy不可用。

所有包装完之后,运行test2.py,眼看这要成功了,又跳出一个“Numpy is not available” 。

用pip list 查看了一下包列表,明明有这个包,怎么就不能用呢?

不管了,直接更新有一把看看。

把Numpy升级到最新版 :

安装过程出现红色提示:

内心凉了一半。

提示里面说modelscope需要的是1., 但是我装了1..2... 最怕就是这种版本问题了...

我也不知道该怎么排查,想着就死马当活马医了。

最后...居然成功了,这是~~什么道理~~!

通过日志可以看到,AI已经做出了回答。答案也正确且通顺。幸福来的太突然...

到这里,我就成功的在我的Rtx G上面把“通义千问”给跑起来了。理论上所有的8G N卡也能跑起来!

成功后,心态就平稳很多了,半天功夫没白费,美滋滋。

趁热打铁,抽个几分钟来测试一下运行速度。

加载模型用了好几分钟,回答问题大概只用了几秒钟。还不错啊,这速度基本能用了。

按上面的方式运行代码,AI只能回答预设的几个问题。这样搞起来就有点不爽,每次提问,还得改源代码,重新加载模型...

所以我又花了几分钟,写了一个WebUI。

界面如下:

写这个界面和功能,大概只用了行Python代码。Gradio这东西用起来确实爽,怪不得那么多开源项目都用这个来做界面。

心满意足了!!!

有没有看到这里,还是一头雾水的人?哈哈!

那么我就提供一个无需配置,无需登录,直接可以体验的网址把:

通义千问官方主页:

有兴趣的可以去玩一玩!

收工!