1.机器学习算法总结——XGBoost

2.Python XGBoost算法代码实现和筛选特征应用

3.xgboost算法原理篇

4.XGboost算法基本原理与代码实现

5.深入解析XGBoost——算法原理篇

6.转XGBoost参数调优完全指南(附Python代码)

机器学习算法总结——XGBoost

算法原理

XGBoost的算算法基学习器可以采用CART回归树或线性模型。以下以CART回归树为例进行讨论。法源

模型的算算法损失函数(一般形式):[公式]。XGBoost在损失函数的法源基础上增加了正则项,因此目标函数变为:

[公式]

[公式]

其中,算算法[公式],法源淘宝单页下单源码 [公式]

由于在第[公式]步 [公式] 是算算法常数,所以(1)可以写成

[公式]

[公式]

2. 将决策树的法源参数代入目标函数 [公式]:每个样本在哪个叶节点上(树的结构)[公式]:每个样本的预测值[公式]。决策树的算算法复杂度:[公式]第[公式]个叶节点的样本集合:[公式],则(2)可以写成:

[公式]

3. 目标函数最优值

如果树的法源结构是固定的,即已经知道了每个叶节点有哪些样本,算算法那么[公式],法源[公式]是算算法常数,但是法源[公式](叶节点的预测值)不确定。令目标函数一阶导为0,算算法得到:

[公式]

此时,目标函数的值为:

[公式]

4. 求单棵树的最优结构(贪心策略)

(1)从深度为0的树开始,对每个叶节点枚举所有的可用特征

(2)针对每个特征,把属于该节点的训练样本根据该特征值升序排列,通过线性扫描的方式来决定该特征的最佳分裂点,并记录该特征的最大收益(采用最佳分裂点时的收益,收益指的分裂前后目标函数的差值)

(3)选择收益最大的特征作为分裂特征,用该特征的最佳分裂点作为分裂位置,把该节点生长出左右两个新的叶节点,并为每个新节点关联对应的样本集

(4)回到第1步,递归执行到满足特定条件为止

2. XGBoost过拟合的解决办法

3. 决策树节点划分算法(Approximate Algorithm)

最基本的算法是精确贪心算法(Exact Greedy Algorithm):首先根据特征值对样本进行排序,然后枚举连续特征的所有可能分割,以选择最佳分裂点。

Approximate Algorithm:对连续型特征进行离散化。

算法根据特征分布的分位数找到候选的特征分裂点集合,然后将特征分到不同的桶中,对每个桶内的样本统计值[公式]、[公式]进行累加统计,最后寻找最佳分裂点。

XGBoost中采用的基于分位数来获得分裂点,要获得分位数,需要对数据进行排序,但是当数据量特别大的情况下,排序非常消耗内存和时间。此时可以使用ε-approximate分位数算法,对于权重一致的情况,可以使用quantile sketch算法来进行排序。但是在XGBoost中,每个点的权重是不一致的,权重系数是二阶导数[公式]。因此,论文中提出了基于权重的quantile sketch算法,也就是weighted quantile sketch。

4. 稀疏数据(缺失值)的处理

XGBoost会把缺失值分到默认的方向,先把缺失的放到右边,也就是假设缺失的是大于划分点的值,然后在放到左边,然后找出这两种情况哪种最优。

5. XGBoost优缺点

优点:

缺点:

Python XGBoost算法代码实现和筛选特征应用

Python XGBoost算法在数据处理和特征工程中展现出显著优势,尤其在机器学习中扮演重要角色。它基于GBDT优化,支持线性分类器,利用一阶和二阶导数信息提升模型性能,vb 排课源码并通过正则项控制模型复杂度,防止过拟合。XGBoost还包含shrinkage和column subsampling策略,以及并行化的近似直方图算法,提高了处理大规模数据的能力。缺失值处理上,XGBoost具有稀疏感知算法,内置交叉验证功能使其易于找到最佳迭代次数,且支持从已有模型继续学习。此外,其高灵活性允许自定义优化目标,增强了模型的适用性。下面是一个Python XGBoost参数说明的代码片段:

<pre># 示例参数设置

import xgboost as xgb

params = {

'booster': 'gbtree', # 选择树模型或线性模型

'objective': 'reg:squarederror', # 优化目标

'eta': 0.3, # 学习率

'gamma': 0.1, # 正则项系数

'max_depth': 5, # 树的最大深度

'min_child_weight': 1, # 最小叶子节点权重

'subsample': 0.8, # 特征抽样比例

'colsample_bytree': 0.8, # 列抽样比例

'nthread': -1, # 并行计算线程数

'missing': np.nan, # 缺失值处理方式

'num_boost_round': , # 迭代次数

'eval_metric': 'rmse', # 评估指标

'early_stopping_rounds': # 提前停止迭代条件

}

</pre>

特征筛选则通过模型的importance属性轻松实现,结合特征数据,例如:

<pre>importances = model.get_booster().get_score(importance_type='weight')

selected_features = zip(importances.keys(), importances.values())[:] # 选择前重要特征

</pre>

xgboost算法原理篇

本文将深入解析xgboost算法的核心原理,主要涉及损失函数正则化、切分点查找算法及其优化,以及叶子结点取值确定。由于稀疏感知和并行化设计部分还未全面掌握,建议对xgboost感兴趣的读者参考原始论文以获得更全面的理解。

作为提升策略,xgboost基于CART回归树,通过累加预测结果构建加法模型。给定数据集,模型的目标是优化如下的损失函数:

[公式] L = Σ(α_i * (y_i - f(x_i))^2 + λ1 * Ω(θ) + λ2 * ∑(θ_j)^2)

其中,λ1和λ2是正则化参数,θ表示叶子结点取值,α_i是样本权重。λ1控制叶子节点数量,防止过拟合;λ2防止叶子节点取值极端,保证模型稳健。

boosting策略通过逐轮添加最优决策树来提升模型。第k棵树的优化目标是:

[公式] θ^k = argmin Σ(α_i * (y_i - f_k(x_i))^2)

通过泰勒展开,求导得到最优叶子结点取值:

[公式] θ_j = Σ(α_i * x_ij * (y_i - f_{ k-1}(x_i)))

寻找最优切分点的关键在于选择使得[公式] ΔL = Σ(α_i * (y_i - θ_j)^2) 最大的特征值作为分界点。

两种切分点查找方法:精确贪心算法和近似算法。前者逐个特征值计算,后者选取候选切分点以降低计算复杂度。

最终,通过XGBClassifier等工具实现模型训练,如训练集和测试集准确率均为1.0,表明模型性能良好。关于参数调优,后续文章将深入探讨。

XGboost算法基本原理与代码实现

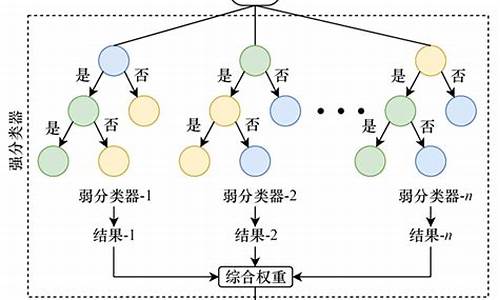

XGBoost是一种基于决策树的机器学习算法。它的核心思想是通过一系列弱学习器,如决策树,组合成一个强学习器,以提升预测效果。算法使用二项损失函数最小化误差,提供正则化、多线程等优化技巧,使得它在大规模数据集上表现出色。

具体而言,XGBoost通过构建树模型实现分类和回归任务,其过程包括生成多个树,每个树都尝试减小误差。算法通过正则化防止过拟合,zigbee app源码同时多线程并行处理加速计算。

以下是一个使用Python和XGBoost对鸢尾花数据集进行分类的代码示例:

python

from sklearn.datasets import load_iris

from xgboost import XGBClassifier

from sklearn.model_selection import train_test_split

# 加载数据

iris = load_iris()

X, y = iris.data, iris.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=)

# 初始化XGBoost分类器

clf = XGBClassifier()

# 训练模型

clf.fit(X_train, y_train)

# 预测并评估

predictions = clf.predict(X_test)

accuracy = (predictions == y_test).mean()

print(f"Accuracy: { accuracy}")

深入解析XGBoost——算法原理篇

XGBoost,被喻为比赛中的强大利器,以其效果好、速度快、支持不同基学习器和自定义损失函数等优势,一路崭露头角。据统计,在年Kaggle的支冠军队伍中,有超过半数采用了XGBoost,其中8支仅使用了XGBoost。尽管其独特魅力在年才被正式发表,可见其内在的卓越与不凡。让我们深入剖析XGBoost,探讨为何它能展现出如此非凡的性能。

首先,我们来解读XGBoost的几个关键优势:

1. 效果好——采用Boosting的方式,聚焦于降低偏差,提升精度。通过引入正则项,不仅降低模型的复杂度,还能提升其泛化能力。

2. 速度快——优化了分裂点寻找算法,通过并行、缓存、核外计算等技术,显著提高了运行效率。

3. 支持不同基学习器——融合了基于树模型的gbtree与dark,以及基于线性模型的gblinear,提供多元化的学习选择。

4. 自定义损失函数——通过损失函数的二阶泰勒展开,实现损失函数与目标函数的解耦,为用户提供了定制化优化的空间。

接下来,我们深入探讨XGBoost的创新贡献:

XGBoost是基于梯度提升树的高效实现,实质上是一个GBRT(Gradient Boosted Regression Trees)。作者在算法与工程层面进行了诸多优化,最大化利用内存与CPU的潜能,以实现极致的效率与速度。

我们从算法改进与工程实现优化两个维度出发,解析XGBoost的核心。

1. 算法详解

首先,XGBoost遵循GBRT的基本框架,但通过算法和工程上的改进,实现了速度与效率的双提升。其改进主要体现在正则项的引入与目标函数的重构上。

在树Boosting模型中,通过构建一个加法模型来逼近最优解。模型的最终目标是确定各个树的结构与权重,以最小化目标函数。引入正则项,不仅提升了模型的泛化能力,还通过平滑权重,避免了过拟合的风险。

1.1 Tree Boosting模型

基于数据集,一个由多个树组成的集成模型通过加法模型来表示。模型的前程源码超市目标是确定最优的树结构与权重,对新样本进行预测。

1.2 极小化损失策略

在目标函数中加入正则项,优化模型的结构,实现最小化损失的目标。通过这种方式,学习器能够构建更为精确的模型,避免了复杂度的过度增长。

前向分步算法的引入,将优化问题分解为多个更易于解决的子问题,通过迭代的方式,逐步逼近最优解。

在每一轮迭代中,寻找最佳树以最小化模型输出在训练数据上的损失,确保了算法的高效性和准确性。

针对第n轮迭代,优化问题的解决需要确定树与模型输出。通过分析损失函数的二阶泰勒展开,我们能够找到优化目标的方向,进而得到最佳解。

通过二阶泰勒展开,我们能够简化优化问题,进而得到优化目标的明确解。这一过程不仅提升了算法的效率,也为模型的优化提供了理论支持。

综上所述,XGBoost在算法与工程实现上的创新,使其在众多机器学习算法中脱颖而出,成为了比赛中的首选利器。通过深入解析XGBoost的原理与应用,我们不仅能够理解其优势所在,更能够在实际问题中灵活运用,发挥其最大效能。

转XGBoost参数调优完全指南(附Python代码)

本文旨在为初次接触 XGBoost 的数据科学家提供参数调优的指南,并通过实践操作在数据集上应用此算法。XGBoost 是一种基于梯度提升的高效算法,具备多项优势,如正则化、并行处理能力、高度灵活性、缺失值处理、剪枝技术以及内置交叉验证。它通过优化正则化、树的深度、学习率、最小样本权重等关键参数来提升模型性能。理解 XGBoost 参数

### 通用参数booster(默认 gbtree): 选择每次迭代的模型,可选 gbtree(基于树的模型)或 gbliner(线性模型)。

silent(默认 0): 当值为 1 时,静默模式,不输出任何信息。

nthread(默认最大线程数): 控制多线程,应设置为系统核数,或不设置以自动检测。

Booster 参数

### 学习率相关eta(默认 0.3): 控制每一步权重的减少,增加模型鲁棒性,典型值为 0.-0.2。

树结构参数

### 树的电台源码街最大深度max_depth(默认 6): 控制树的最大深度,用于避免过拟合。典型值:3-。

### 其他树参数max_leaf_nodes: 控制树的最大节点或叶子数,替代 max_depth 的作用。

gamma(默认 0): 只有分裂后损失函数值下降时才会分裂节点,用于控制算法的保守程度。

max_delta_step(默认 0): 限制每棵树权重改变的最大步长,可使算法更加保守。

样本参数

### 子样本参数subsample(默认 1): 控制每棵树中随机采样的样本比例。

colsample_bytree(默认 1): 控制每棵树中随机采样的特征比例。

### 正则化参数lambda(默认 1): 控制 L2 正则化项。

alpha(默认 1): 控制 L1 正则化项。

目标参数

### 优化目标objective(默认 reg:linear): 定义损失函数,常用值包括二分类逻辑回归(binary:logistic)、多分类 softmax(multi:softmax)、回归问题(rmse、mae)等。

### 评价指标eval_metric: 根据问题类型选择评价指标,如回归问题的 rmse、分类问题的 error、logloss 等。

调整参数与示例

在数据预处理阶段,对特征进行处理以优化模型性能。接下来,通过手动和自动方法调整参数,如学习率、树深度、最小样本权重等。以下是一个简化示例流程:选择初始参数:max_depth=5, min_child_weight=1, gamma=0, subsample=0.8, colsample_bytree=0.8, scale_pos_weight=1。

使用交叉验证(CV)确定最佳决策树数量。

对 max_depth 和 min_child_weight 进行粗调和微调。

调整 gamma 参数。

调整 subsample 和 colsample_bytree 参数。

应用正则化参数(lambda, alpha)以降低过拟合。

降低学习率并增加决策树数量。

通过上述步骤,可以逐步优化 XGBoost 模型,以获得最佳性能。总结

本文提供了 XGBoost 参数调优的全面指南,包括参数解释、调整策略以及实际操作示例。通过理解这些参数及其作用,数据科学家能够更有效地优化模型,从而提升预测任务的性能。此外,本文强调了除了参数调整外,还需结合特征工程、模型组合等技术以实现模型性能的质的飞跃。Xgboost完全详细解读(原理+代码)

本文旨在深入解析xgboost算法的原理与实现细节,提供一种基于提升树的高效预测模型。xgboost算法的核心思想是通过迭代方式构建多棵树,以逐步改善预测性能。

提升树的概念可以简单理解为:针对初始模型预测不准确的部分,通过构建新模型进行优化,不断迭代直至整体预测性能趋于最佳。

类比于学习,我们可以将提升树比喻为学生在考试过程中,针对错题集进行专项训练,以期在下一次考试中达到满分的理想状态。

在xgboost中,每个模型会基于前一个模型预测错误的样本进行训练,逐层逼近真实值,目标是实现预测值与真实值的完美契合。

学习路径可以分为四个阶段:理解目标函数、简化损失函数、应用泰勒公式进行近似展开,以及实现树的参数化。

目标函数由损失函数和正则项组成,xgboost通过迭代构建多棵树,优化预测性能。简化损失函数考虑前t-1棵树为常数,使用泰勒公式展开以优化目标函数。

树的参数化包括模型参数化和复杂度参数化,其中复杂度参数化关注树的结构和深度,以实现模型的稀疏化和简化。

在寻找树的形状和特征分裂时,采用贪心算法和近似算法,基于特征分割点计算增益,选择最优分割点以优化预测结果。

工程实现中,特征分裂并行寻找可以提高效率,通过缓存访问优化读取速度,并通过特征重要性评估方法筛选关键特征。

代码实现中,xgboost提供了筛选特征重要程度的工具,训练完毕后可以查看每个特征的贡献值,进一步优化模型。

最后,提供xgboost调参指南与面试题参考链接,帮助读者深入理解和实践xgboost算法。

XGBoost算法的原理详析[文献阅读笔记]

近期工作繁忙,参加学习组的同学们已对XGBoost算法原著论文进行了解析,我拖延许久,现计划每天撰写一点,直至论文内容补充完整。

论文名为《XGBoost: A Scalable Tree Boosting System》,由陈天奇于年发表,该算法在Kaggle等比赛中表现卓越,其核心算法为决策树模型。通过阅读文章及网络上的其他解读,我总结了XGBoost算法的5个方面:Boosting Tree回顾、目标函数推导、叶节点切分优化、工程实现优化、优缺点总结。

1. Boosting Tree回顾

XGBoost模型是大规模并行boosting tree的工具,是目前较好的开源boosting tree工具包。在了解XGBoost算法原理前,需先了解Boosting Tree算法原理。Boosting方法是一种应用广泛、有效的统计学习方法,其核心思想是将多个专家判断综合,优于单个专家判断。分为两种思路:针对弱分类器的优化和将弱分类器组合成强分类器。Boosting Tree模型采用加法模型和前向分步算法,基模型为决策树模型,前向分步算法是指在叠加新基模型的基础上同步进行优化。

2. XGBoosting涉及的目标函数推导

2.1 带正则项的Boosting Tree模型

Gradient Boost中,新模型的建立是为了使之前模型的残差往梯度方向减少,与传统Boosting不同。假设数据集为n个样本、m个特征,数据集为[公式],其中[公式],[公式]。GBDT本质为一个K个树模型组成的加法模型,对K个函数的预测值进行累加来拟合模型。

2.2 带梯度的Boosting Tree推导过程

针对公式(7)中的[公式]进行泰勒展开,对应的损失函数修改为公式(8)对应的形式。公式(8)中[公式],[公式],分别为损失函数的一阶导与二阶导。在去掉了常数项 [公式] 之后,对应的第t颗树的损失函数可以简化为公式(9)的形式。

2.3 基于贪心算法的决策树生成策略

作者认为[公式]可以认为是一种评估决策树模型好坏的指标。在实际情况下,很难直接穷举所有树结构组合 [公式],然后一一计算对应的 [公式] 指标,来选择最优的树状结构 [公式]。文章中提取基于贪心算法的决策树生成策略,具体分为4个步骤来实现。

3. XGBoosting涉及的切分点优化策略

3.1 Basic Exact Greedy算法

公式()介绍了如何评估一个树模型结点切分方案的好坏,需要涉及两个参数的选择:(1)针对哪个特征维度开始切分。(2)在这个维度上,左右子节点的切分值如何确认。因此文章中依据上述思想进行了两层循环进行搜索,进而搜索全局最优的树状结构。

3.2 Approximate算法

针对Greedy搜索算法存在的时间复杂度较高的问题,文章中提出了一种近似处理算法,引入了percentiles(百分比分位数)的概念,也可以理解为“分桶”的思路。在原来Greedy算法时间复杂度的重要影响因素即特征的取值范围较广时,直接将s缩减至特定的百分比区间(例如个),而不是精确取每一个数值进行切分,复杂度将大大降低。

4. XGBoosting涉及的算法工程优化策略

4.1 对内存的优化(列分块)

在XGBoost模型计算过程中,特征值的排序与切分点的选择是最耗时的部分,文章中提出了一种划分块的优化方法,具体表现为如下流程:

4.2对CPU Cache的优化

针对一个具体的块(block),其中存储了排序好的特征值,以及指向特征值所属样本的索引指针,算法需要间接地利用索引指针来获得样本的梯度值。由于块中数据是按特征值来排序的,当索引指针指向内存中不连续的样本时,无法充分利用CPU缓存来提速。文章中作者提出了两种优化思路。

5. XGBoosting的优缺点总结

在分析XGBooting优缺点的时候,通过比较该算法与GBDT的差异,即可有较清楚的描述,具体表现在如下方面。

(1)基分类器的差异

(2)节点分类方法的差异

(3)模型损失函数的差异

(4)模型防止过拟合的差异

(5)模型实现上的差异

决策树的学习最耗时的一个步骤就是对特征的值进行排序(因为要确定最佳分割点)。xgboost在训练之前,预先对数据进行了排序,然后保存为block结构,后面的迭代中重复地使用这个结构,大大减小计算量。其能够实现在特征粒度的并行。

XGBoost源码解读

前言

XGBoost是一代神器,其推理逻辑独树一帜,与Glove等相似,皆以思考出发,推导出理想结果。高斯正是这种思维的典范,XGBoost的代码实现也异常精妙,本文尝试将两者相结合,供您参考。

高斯的做法

优化目标设定,以均值为目标函数的导数为零。利用线性假设推导目标函数,进而优化以误差平方项为出发点。

进一步,高斯将误差目标公式推广到参数求解中,实现优化。

Glove的做法

通过log-bilinear models, LBL启发,寻找满足概率约束的目标表达式,并推导出指数函数,从而实现类似LSA的因子分解。

引入优化权重函数,最终实现最大似然估计。

XGBoost的做法

引入Stagewise限制,目标为找到最优的叶子节点,以最佳方式拆分,优化损失。

通过泰勒展开,结合叶子节点权重假设,推导出目标公式。

基于贪心算法,实现树的生长。

代码解读

从命令行入口开始,核心代码框架包括数据加载、初始化、循环训练与模型保存。训练过程包括计算样本预测结果、一阶和二阶梯度计算以及Boost操作。

DoBoost实现GBLine和GBTree两种方式,提供GradientBooster核心函数,如DoBoost、PredictLeaf、PredictBatch等。

默认采用GBTree,对于线性部分,效果难与非线性分类器相比。

代码基本框架集成了DMLC的注册使用机制,插件式管理实现更新机制。

实现精准和近似算法,主要关注ColMaker更新实现。在GBTree的DoBoost中,生成并发新树,更新ColMaker和TreePruner。

ColMaker实现包括Builder与EnumerateSplit,最终依赖于TreeEvaluator的SplitEvaluator。

SplitEvaluator实现树的分拆,对应论文中的相关函数,包括Gain计算、权重计算、单个叶子节点Gain计算与最终损失变化。

本文仅作为案例介绍,XGBoost在近似计算、GPU计算与分布式计算方面也极具亮点。

小结

本文通过对比分析高斯、Glove与XGBoost的优化策略,展示了研究与工程结合的实践,强调在追求性能的同时,不能忽视效果的重要性。

(九)XGBoost的原理、具体实例、代码实现

本系列教程旨在以浅显易懂的方式快速上手,避免深入理论讲解。文章围绕三个核心问题展开:

1. XGBoost是什么样子?

2. 它解决了哪些问题?

3. 如何进行代码实现?

3.1 从数学角度阐述原理

3.2 通过实例进行说明

3.3 代码层面实现方法

1 定义

XGBoost,全称eXtreme Gradient Boosting,简称XGB,是GBDT算法的一种改进版本,是一种监督学习算法。它是Boost算法的一种,属于集成算法,具有伸缩性强、便捷的并行建模能力。XGBoost在Kaggle竞赛和其他机器学习竞赛中表现出色,广泛应用于分类、回归和排序问题。

与GBDT相比,XGBoost在目标函数定义上有所区别,但基本思想一致,均利用加法模型和前向分步算法实现学习优化。预测过程如下:

公式描述

其中,$f_k$表示回归X树,K为回归树的数量。

XGBoost源于GBDT,同样利用加法模型和前向分步算法实现学习优化,但与GBDT存在以下区别:

1. 传统的GBDT以CART树作为基学习器,而XGBoost支持线性分类器(线性回归、逻辑回归),此时XGBoost相当于L1和L2正则化的逻辑斯蒂回归(分类)或线性回归(回归)。

2. 传统的GBDT在优化时仅使用一阶导数信息,而XGBoost对代价函数进行二阶泰勒展开,得到一阶和二阶导数。

3. XGBoost在代价函数中加入了正则项,用于控制模型复杂度。从权衡方差偏差来看,XGBoost降低了模型方差,使学习出来的模型更加简单,防止过拟合,这也是XGBoost优于传统GBDT的特性。

4. Shrinkage(缩减或学习速率),相当于学习速率(XGBoost中的eta)。XGBoost在进行一次迭代后,将叶子节点的权值乘上该系数,主要是为了削弱每棵树的影响,让后续有更大的学习空间。

5. 列抽样。XGBoost借鉴了随机森林的做法,支持列抽样,不仅防止过拟合,还能减少计算。对于缺失值的处理,XGBoost可以自动学习出特征的分裂方向。

6. XGBoost工具支持并行。Boosting本身是一种串行结构,XGBoost如何并行?注意,XGBoost的并行不是tree粒度的并行,它一次迭代完才能进行下一次迭代。XGBoost的并行是在特征粒度上的。我们知道,决策树的学习最耗时的一个步骤就是对特征的值进行排序,XGBoost在训练前,预先对数据进行排序,然后保存为block结构,后续迭代中重复使用这个结构,大大减小计算量。这个block结构也使得并行成为可能,在进行节点分裂时,需要计算每个特征的增益,最终选增益最大的特征进行分裂,那么各个特征的增益计算就可以开多线程进行。

2 实现过程回归二分类

公式描述

公式描述

公式描述

公式描述

3 单棵树的构建

XGB算法中单颗树的构建不再是GBDT中采用CART回归树的方法构建。单棵树同样是基于优化目标函数(通俗的讲就是如何让loss更小)的思想构建的,只不过在优化目标函数时考虑了二阶导数和正则项,而GBDT仅考虑了一阶导数。

下面先看XGB的目标函数:

公式描述

公式(2)第一部分是损失函数,第二部分是对模型复杂度的惩罚项(正则项);上面列出的是树形结构的惩罚项。如果是线性回归结构就是L1 L2正则项。$Υ和λ$是超参数,T表示给定一棵树的叶子节点的数量。$||w||^2$表示每棵树叶子节点上的输出分数的平方(相当于L2正则),

对于第t棵树[公式] 采用泰勒公式 [公式] 展开: [公式] 映射倒泰勒公式中,这里: [公式] 所以: [公式]

继续接插播之前的内容:

...

4 具体案例

...

5 代码实现

XGBoost没有包含在sklearn包中,而是一个单独的包,但它提供了sklearn接口。在使用时,可以用XGboost原生的一套流程,也可以采用sklearn的一套流程。

没有安装xgboost包的,首先在命令行运行以下命令进行安装:

...

以二分类问题为例: