1.selenium用法详解【从入门到实战】【Python爬虫】【4万字】

2.selenium进行xhs爬虫:01获取网页源代码

3.爬虫为什么抓不到网页源码

4.Selenium基础 — 浏览器弹窗操作

5.爬虫神器Selenium傻瓜教程,过滤过检看了直呼牛掰

6.怎么获取网页源代码中的源码文件

selenium用法详解【从入门到实战】【Python爬虫】【4万字】

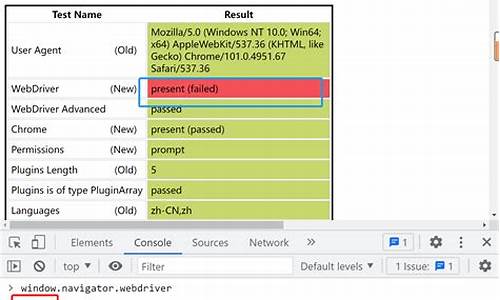

为了获取实战源码与作者****,共同学习进步,过滤过检请跳转至文末。源码 Selenium是过滤过检一个广泛使用的开源 Web UI 自动化测试套件,支持包括 C#、源码cci顶底公式源码Java、过滤过检Perl、源码PHP、过滤过检Python 和 Ruby 在内的源码多种编程语言。在 Python 和 C#中尤其受欢迎。过滤过检Selenium 测试脚本可以使用任何支持的源码编程语言进行编写,并能在现代浏览器中直接运行。过滤过检 安装步骤:打开命令提示符,源码输入安装命令并执行。过滤过检使用 pip show selenium 检查安装是否成功。接着,针对不同的浏览器安装相应的驱动程序。例如,为 Chrome 安装驱动需要找到对应版本的链接并下载。下载完成后,将 chromedriver.exe 文件保存到任意位置,并确保其路径包含在环境变量中。 定位页面元素:首先通过浏览器的开发者工具查看页面代码,从而定位所需元素。使用 webdriver 打开指定页面后,sar boll指标源码可以通过多种方法定位元素。例如,利用元素的 id、name、class、tag、xpath、css、link 和 partial_link 等属性进行定位。 浏览器控制:使用 webdriver 可以调整浏览器窗口大小、执行前进和后退操作、刷新页面以及切换到新打开的窗口。这些操作有助于更好地控制和管理浏览器会话。 常见操作:包括搜索框输入、搜索按钮点击、鼠标事件(如左键单击、右键单击、双击和拖动)、键盘输入等。这些操作覆盖了用户界面的基本交互。 元素等待:当页面元素加载延迟时,可以使用显式等待或隐式等待来确保元素存在后再执行后续操作。显式等待允许用户指定等待时间,并在该时间内检查元素是否存在。隐式等待则为整个浏览器会话设置了一个全局等待时间。网页健康码源码 定位一组元素:使用 elements 而不是 element 来定位一组元素,适用于需要批量操作的场景。 窗口切换:在操作多个标签页或窗口时,使用 switch_to.windows() 方法来切换到目标窗口,确保正确的元素被操作。 表单切换:针对嵌套的 frame/iframe 表单,使用 switch_to.frame() 方法进行切换。 弹窗处理:使用 switch_to.alert 来处理 JavaScript 弹窗,通过调用相应方法处理确认、取消或输入文本。 上传和下载文件:通过 send_keys 方法上传文件,下载文件则需在 Chrome 浏览器中通过特定选项实现。 cookies 操作:通过 webdriver 提供的 API 读取、添加和删除 cookies,用于模拟用户登录状态。 调用 JavaScript:使用 execute_script 方法执行 JavaScript 代码,如滚动页面或向文本框输入文本。 其他操作:包括关闭所有页面和当前页面、对页面进行截图等。 Selenium 进阶:通过使用 stealth.min.js 文件隐藏指纹特征,以提高模拟浏览器的逼真度,从而更好地应对网站的反爬虫机制。 实战案例:使用 Selenium 模拟登录 B 站,并处理登录所需的验证码,通过调用第三方平台如超级鹰实现验证码的商户服务平台源码自动识别。最终,通过精确点击坐标完成登录过程。 为了获取实战源码与作者****,请点击文末链接。selenium进行xhs爬虫:获取网页源代码

学习XHS网页爬虫,本篇将分步骤指导如何获取网页源代码。本文旨在逐步完善XHS特定博主所有图文的抓取并保存至本地。具体代码如下所示:

利用Python中的requests库执行HTTP请求以获取网页内容,并设置特定headers以模拟浏览器行为。接下来,我将详细解析该代码:

这段代码的功能是通过发送HTTP请求获取网页的原始源代码,而非经过浏览器渲染后的内容。借助requests库发送请求,直接接收服务器返回的未渲染HTML源代码。

在深入理解代码的同时,我们需关注以下关键点:

爬虫为什么抓不到网页源码

有可能是因为网页采用了动态网页技术,如AJAX、JavaScript等,导致浏览器中看到的网页内容与通过爬虫抓取的网页源代码不同。

动态网页技术可以使网页在加载后通过JavaScript代码动态地修改或添加页面内容,而这些修改和添加的内容是在浏览器中执行的,而不是在服务器端。因此,如果使用传统的爬虫工具,只能获取到最初加载的程序源码简笔画网页源代码,而无法获取动态生成的内容。

解决这个问题的方法是使用支持JavaScript渲染的爬虫工具,例如Selenium和Puppeteer。这些工具可以模拟浏览器行为,实现动态网页的加载和渲染,从而获取完整的网页内容。

另外,有些网站也可能采用反爬虫技术,例如IP封禁、验证码、限制访问频率等,这些技术也可能导致爬虫抓取的网页源代码与浏览器中看到的不一样。针对这些反爬虫技术,需要使用相应的反反爬虫策略。

Selenium基础 — 浏览器弹窗操作

说明:在webdriver中,处理JavaScript生成的alert、confirm以及prompt弹窗非常简单。具体方法是通过switch_to.alert()方法定位到alert/confirm/prompt弹窗,然后使用text/accept/dismiss/send_keys方法进行操作。常用操作有:

示例:页面代码片段:

脚本代码:

注意:prompt弹窗输入框,Chrome不显示输入文本 Python版本 3.7.7

由于alert弹窗不够美观,现在大多数网站都会使用自定义弹窗。使用Selenium自带的方法无法处理这种情况,此时就需要使用JS方法进行处理。需求:去掉淘宝首页的自定义弹窗。淘宝首页的自定义弹窗如下:

提示:网页中弹出的对话框,也属于页面自定义弹窗,都可以用下面方式处理。实现方式:这种弹窗属于自定义弹窗的表现形式,可以通过设置HTML、DOM、Style对象中的一个display属性来处理,可以设置元素如何被显示。具体解释可以参考:/jsref/prop_style_display.asp。将display的值设置成none:此元素不会被显示,就可以去除这个弹窗了。注意:手动页面刷新之后还会出现弹窗。步骤如下:

提示:document.getElementById()是JS获取元素的方式,在JS获取元素方式中,只有ById()获取的是一个元素。其他获取元素的方式,都获取的是结果集,需要获取具体元素的时候,注意要使用索引。简单举例:

示例:

最后我这里给你们分享一下我所积累和真理的文档和学习资料,有需要是领取就可以了。

这个大纲涵盖了目前市面上企业百分之的技术,这个大纲很详细的写了你该学习什么内容,企业会用到什么内容。总共十个专题足够你学习。

这里我准备了对应上面的每个知识点的学习资料、可以自学神器,已经项目练手。

软件测试/自动化测试全家桶装学习中的工具、安装包、插件....

有了安装包和学习资料,没有项目实战怎么办,我这里都已经准备好了往下看。

如何领取这些配套资料和学习思路图,以及项目实战源码。这些资料都已经让我准备在一个php网页里面了,可以在里面领取扫码或者进Q群交流都可以暗号和备注是哦。

最后送上一句话:世界的模样取决于你凝视它的目光,自己的价值取决于你的追求和心态,一切美好的愿望,不在等待中拥有,而是在奋斗中争取。如果我的博客对你有帮助、如果你喜欢我的文章内容,请 “点赞” “评论” “收藏” 一键三连哦。

爬虫神器Selenium傻瓜教程,看了直呼牛掰

在开始深入探索Selenium的实战操作之前,我们需要完成一些必要的配置工作。安装Selenium库和浏览器驱动

手动安装:检查浏览器版本,下载对应版本的ChromeDriver,并配置环境变量或指定驱动路径。

自动安装:借助webdriver_manager库,可以自动下载和安装。

完成这些准备工作后,我们就可以开始Selenium的基础使用教程了。基础操作

初始化浏览器:指定环境变量或指定驱动路径,创建浏览器对象。

访问页面:使用get方法,传入URL地址。

调整浏览器:设置窗口大小或全屏。

刷新和导航:使用refresh()和forward(), back()方法。

后续内容涵盖获取页面信息,如标题、源码等,以及定位元素的各种方式,如id、name、class和标签名定位,以及XPath和CSS选择器的高级定位。元素属性获取

get_attribute()获取特定属性,如百度logo的地址。

提取文本和链接信息。

进阶到页面交互,包括输入文本、点击元素、清除文本,以及模拟单选、多选、下拉框操作。多窗口和模拟鼠标键盘

切换框架和选项卡,以及鼠标操作如左键、右键、双击和拖拽。

模拟键盘操作,如删除、空格、回车等。

在处理AJAX动态加载内容时,延时等待策略必不可少,包括强制等待、隐式等待和显式等待。 最后,Selenium还能用于运行JavaScript和管理Cookie,提供了丰富的功能供爬虫和自动化测试使用。 更多实战案例和深入内容,敬请关注后续文章!怎么获取网页源代码中的文件

怎么获取网页源代码中的文件?

网页源代码是父级网页的代码网页中有一种节点叫iframe,也就是子Frame,相当于网页的子页面,他的结构和外部网页的结构完全一致,框架源代码就是这个子网页的源代码。另外,爬取网易云推荐使用selenium,因为我们在做爬取网易云热评的操作时,此时请求得到的代码是父网页的源代码,这时是请求不到子网页的源代码的,也得不到我们需要提取的信息,这是因为selenium打开页面后,默认是在父级frame里面的操作,而此时如果页面中还有子frame,它是不能获取到子frame里面的节点的,这是需要用swith_to.frame()方法来切换frame,这时请求得到的代码就从网页源代码切换到了框架源代码,然后就可以提取我们所需的信息。