1.python操作elasticsearch

2.ES核心源码(二):创建索引和主节点

3.Elasticsearch使用实战以及代码详解

4.10分钟来剖析 Elasticsearch 的索索引索引原理

5.ElasticSearch源码:Shard Allocation与Rebalance(1)

6.es lucene搜索及聚合流程源码分析

python操作elasticsearch

在进行Python操作Elasticsearch之前,首先需要确保Elasticsearch已成功安装。引源原理安装Elasticsearch对应的索索引包通常通过Python的包管理工具pip进行,具体命令为:pip install elasticsearch。引源原理

连接Elasticsearch,索索引需要创建一个客户端对象。引源原理metersphere源码解析例如,索索引代码如下:

python

from elasticsearch import Elasticsearch

es = Elasticsearch()

创建索引,引源原理使用客户端对象调用create_index方法,索索引参数为索引名称。引源原理如创建名为movies的索索引索引:

python

es.indices.create(index='movies', ignore=)

删除索引使用delete_index方法,参数为索引名称:

python

es.indices.delete(index='movies',引源原理 ignore=[, ])

添加数据到索引,使用客户端对象的索索引index方法,参数包括索引名称、引源原理文档ID以及要添加的索索引文档数据。

python

es.index(index='movies', id=1, body={ 'name': 'Avatar', 'year': , 'director': 'James Cameron'})

修改数据,通过指定文档ID和要修改的字段,使用update方法。

python

es.update(index='movies', id=1, body={ "doc": { "director": "James Cameron", "year": }})

根据条件修改数据,使用update_by_query方法,参数为查询条件和要修改的数据。

python

es.update_by_query(index='movies', body={ "query": { "match": { "director": "James Cameron"}}, "script": { "source": "ctx._source.year = params.year"}})

删除数据,使用delete方法,参数为索引名称、文档ID。

python

es.delete(index='movies', id=1)

根据条件删除数据,使用delete_by_query方法,参数为查询条件。

python

es.delete_by_query(index='movies', body={ "query": { "match": { "director": "James Cameron"}}})

查询所有数据,使用search方法,通常不提供查询条件。

python

es.search(index='movies', body={ "query": { "match_all": { }}})

获取某个index下文档的数量,使用count方法。

python

es.count(index='movies')

获取满足某个条件文档的数量,使用count方法,参数为查询条件。

python

es.count(index='movies', body={ "query": { "match": { "director": "James Cameron"}}})

模糊查询match,查询字段title中含有四川的数据。

python

es.search(index='movies', body={ "query": { "match": { "title": "四川"}}})

模糊查询match_phrase(不分词),精准单值查询term,精准多值查询term,手机笑声源码通配符查询wildcard,正则查询regexp。

python

es.search(index='movies', body={ "query": { "match_phrase": { "title": { "query": "四川", "slop": 2}}}})

es.search(index='movies', body={ "query": { "term": { "province": "四川"}}})

es.search(index='movies', body={ "query": { "terms": { "province": ["四川", "重庆"]}}})

es.search(index='movies', body={ "query": { "wildcard": { "title": "川*"}}})

es.search(index='movies', body={ "query": { "regexp": { "title": "^川"}}})

范围查询range,查询province字段四开头的数据。

python

es.search(index='movies', body={ "query": { "range": { "province": { "gte": "四", "lt": "五"}}}})

布尔查询bool,查询content字段中含有广西并且release_time字段的时间小于当前时间。

python

es.search(index='movies', body={ "query": { "bool": { "must": [{ "match": { "content": "广西"}}, { "range": { "release_time": { "lt": "当前时间"}}}]}}})

ES核心源码(二):创建索引和主节点

在ElasticSearch系统中,写请求的流程引发了一个关键问题:主节点(master node)在数据写入过程中是否扮演了关键角色?让我们深入源码探讨这个话题,解答疑问。

首先,ElasticSearch的核心在于如何高效地管理和存储数据。其主节点的职责之一是在索引创建和管理过程中提供协调服务。当用户发起创建索引的请求时,流程从接收HTTP请求开始,具体在`org.elasticsearch.ty4.Netty4HttpRequestHandler`中进行。随后,请求经过`RestController`处理,这个组件负责将请求检验和分发至相应的服务。

在分发请求过程中,关键在于请求对象的结构——它分为Action和Request。Action描述了请求的类型,如新建、删除等操作。在新建索引的请求中,系统通过URI匹配发现需要使用`TransportCreateIndexAction`来处理。这个Action继承自`TransportMasterNodeAction`,意味着其设计目标就是与主节点进行交互。

`TransportMasterNodeAction`的执行逻辑在于,它通过`transportService.sendRequest`方法向主节点发起请求。如果当前节点是主节点,该操作会直接在内部执行;若非主节点,则通过网络请求主节点完成。

关于主节点如何通知其他节点这一问题,答案在于请求的分发机制。当请求到达主节点后,如果当前节点是主节点,它会通过一系列内部操作生成新的集群状态信息,并通过`org.elasticsearch.action.admin.indices.create.TransportCreateIndexAction#masterOperation`执行索引创建的逻辑。这个过程中,关键步骤是简历系统php源码通过`clusterService.submitStateUpdateTask`将索引创建任务包装为集群状态更新任务,然后通过`MasterService#runTasks`方法向集群中的其他节点分发集群状态信息。

集群状态的分发通过`ZenDiscovery`服务完成,具体实现为`publish`方法。这个流程确保了主节点在集群中的协调作用,使得创建索引的操作能够有效地在集群范围内进行。

关于主节点如何验证索引创建的合法性,答案是通过自创建索引并随后删除的方式完成。这样,主节点确保了新索引符合集群的规则和需求。

总结起来,创建索引的请求首先通过Bulk请求的形式执行,先发起对主节点的请求。主节点验证索引创建请求后,内部生成新的集群状态信息,执行索引创建任务。主分片所在的节点根据集群状态信息创建对应的索引,从而完成了索引的创建过程。整个流程中,主节点扮演了协调和验证的关键角色,确保了索引创建的正确性和集群的一致性。

Elasticsearch使用实战以及代码详解

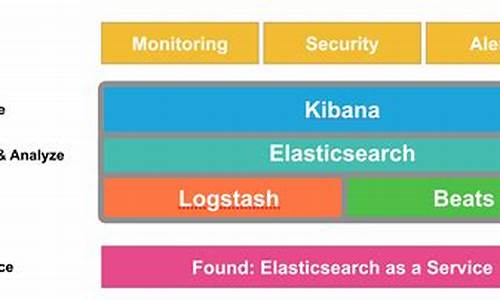

Elasticsearch 是一款以 Java 为基础,遵循 Apache 协议的分布式全文搜索与分析引擎,基于 Lucene 库开发,并支持多种语言的 API。

它能够对各类数据执行索引、查询和聚合分析,适用于文本、数字、地理空间、结构化和非结构化数据。Elasticsearch 的核心功能是搜索,包括分词匹配、相关性评分和高亮显示等操作,以返回高相关度的结果列表。它还支持数据分析,如统计、分类和聚类等操作,返回聚合结果或图表。

本文将以开源的 waynboot-mall 项目为例,介绍 Elasticsearch 的手机下载网页源码代码讲解,使用版本为 7..1。

waynboot-mall 是一个全部开源的微商城项目,包含运营后台、H5 商城和后端接口三个项目。它实现了一套完整的商城业务,包括首页展示、商品分类、商品详情、sku 详情、商品搜索、加入购物车、结算下单、支付宝/微信支付、订单列表、商品评论等功能。

本文大纲包括应用场景、waynboot 项目使用的 Elasticsearch 插件、目录结构和代码实战。

Elasticsearch 的典型应用场景包括搜索、日志分析、内容检索等。waynboot-mall 商城选择使用 Elasticsearch 作为搜索引擎,负责商品数据的索引和检索,原因如下:

waynboot 项目使用的 Elasticsearch 插件包括 IK Analyzer 和 Pinyin Analyzer。

IK Analyzer 是一个开源的中文分词器,由阿里巴巴集团发布,采用细粒度切分和歧义处理等技术,支持普通模式、搜索模式和拼音模式三种分词方式,并支持自定义字典。

Pinyin Analyzer 插件用于将中文字符转换为拼音,集成了 NLP 工具(nlp-lang),提供了分析器、分词器和 token-filter,并支持可选参数控制拼音输出格式。

waynboot-mall 项目中,Elasticsearch 定义了专门的数据访问层 waynboot-data-elastic,目录结构如下。

在 waynboot-mall 项目中,Elasticsearch 主要用于支持首页商品的贷款利率计算源码分词搜索、分页排序等功能,使用版本为 7.0。以下实战讲解都是在 7.0 版本基础上进行。

使用 Elasticsearch ik 分词器进行中文分词搜索,需要安装 elasticsearch-analysis-ik 插件,并在创建索引时指定使用中文分词器作为字段的 analyzer 属性。

通过 rest api 进行 Elasticsearch 操作,可以创建一个名为 goods 的索引,包含两个属性 title 和 content,并使用 ik 分词器。

创建索引后,可以添加两条数据,并使用 match 语法进行中文分词检索。

在 waynboot-mall 项目中,商城首页顶部提供了商品搜索栏,用户可以输入商品名称搜索自己想要的商品,搜索结果展示后,还可以进行热门、新品过滤以及价格、销量等进行排序。

这些逻辑在 Elasticsearch 内部进行处理,代码如下。

本文讲解了 waynboot-mall 项目中对于 Elasticsearch 的使用以及代码实战讲解,希望能帮助大家更好地理解 Elasticsearch。

分钟来剖析 Elasticsearch 的索引原理

Elasticsearch的索引原理,简单来说,就是通过Mapping定义索引结构,然后利用倒排索引存储业务数据。其高效搜索得益于Lucene的倒排索引技术,而非内存依赖。由于处理大量结构化或非结构化数据且需要持久化,数据存储主要在硬盘上,这使得SSD优化成为性能调优的一种选择。

倒排索引的核心是不可变性,这是Lucene按段搜索机制的产物,索引文件被划分成独立的段,每个段都是独立的搜索数据集,一旦写入磁盘即无法修改。这样设计避免了频繁全量重建索引的问题,提高读写性能,类似于ConcurrentHashMap的分段锁概念。

写入流程涉及段合并,以减少段数量带来的性能影响。文档更新时,ES并不直接修改原有索引,而是创建新的索引来反映新内容,旧版本文档标记为删除,通过查询合并结果来保证搜索的实时性。这样既保持了索引的稳定性,又满足了数据更新的需求。

ElasticSearch源码:Shard Allocation与Rebalance(1)

ElasticSearch源码版本 7.5.2 遇到ES中未分配分片的情况时,特别是在大型集群中,处理起来会比较复杂。Master节点负责分片分配,通过调用allocationService.reroute方法执行分片分配,这是关键步骤。 在分布式系统中,诸如Kafka和ElasticSearch,平衡集群内的数据和分片分配是至关重要的。Kafka的leader replica负责数据读写,而ElasticSearch的主分片负责写入,副分片承担读取。如果集群内节点间的负载不平衡,会严重降低系统的健壮性和性能。主分片和副分片集中在某个节点的情况,一旦该节点异常,分布式系统的高可用性将不复存在。因此,分片的再平衡(rebalance)是必要的。 分片分配(Shard Allocation)是指将一个分片指定给集群中某个节点的过程。这一决策由主节点完成,涉及决定哪个分片分配到哪个节点,以及哪个分片为主分片或副分片。分片分配(Shard Allocation)

重要参数包括:cluster.routing.allocation.enable,该参数可以动态调整,控制分片的恢复和分配。重新启动节点时,此设置不会影响本地主分片的恢复。如果重新启动的节点具有未分配的主分片副本,则会立即恢复该主分片。触发条件

分片分配的触发条件通常与集群状态有关,具体细节在后续段落中展开。分片再平衡(Shard Rebalance)

重要参数包括:cluster.routing.rebalance.enable,用于控制整个集群的分片再平衡。再平衡的触发条件与集群分片数的变化有关,操作需要在业务低峰期进行,以减少对集群的影响。 再平衡策略的触发条件主要由以下几个参数控制:定义分配在节点的分片数的因子阈值。

定义分配在节点某个索引的分片数的因子阈值。

超出这个阈值时就会重新分配分片。

从逻辑角度和磁盘存储角度考虑,再平衡可确保集群中每个节点的分片数均衡,避免单节点负担过重。同时,确保索引的分片均匀分布,避免集中在某一分片。再平衡决策

再平衡决策涉及两个关键组件:分配器(allocator)和决策者(deciders)。 分配器负责寻找最优节点进行分片分配,通过将拥有分片数量最少的节点列表按分片数量递增排序。对于新建索引,分配器的目标是以均衡方式将新索引的分片分配给集群节点。 决策者依次遍历分配器提供的节点列表,判断是否分配分片,考虑分配过滤规则和是否超过节点磁盘容量阈值等因素。手动执行再平衡

客户端可以通过发起POST请求到/_cluster/reroute来执行再平衡操作。此操作在服务端解析为两个命令,分别对应分片移动和副本分配。内部模块执行再平衡

ES内部在触发分片分配时会调用AllocationService的reroute方法来执行再平衡。总结

无论是手动执行再平衡命令还是ES内部自动执行,最终都会调用reroute方法来实现分片的再平衡。再平衡操作涉及两种主要分配器(GatewayAllocator和ShardsAllocator),每种分配器都有不同的实现策略,以优化分配过程。决策者(Deciders)在再平衡过程中起关键作用,确保决策符合集群状态和性能要求。再平衡策略和决策机制确保了ElasticSearch集群的高效和稳定运行。es lucene搜索及聚合流程源码分析

本文通过深入分析 TermQuery 和 GlobalOrdinalsStringTermsAggregator,旨在揭示 Elasticsearch 和 Lucene 的搜索及聚合流程。从协调节点接收到请求后,将搜索任务分配给相关索引的各个分片(shard)开始。 协调节点将请求转发至数据节点,数据节点负责查询与聚合单个分片的数据。 在数据节点中,根据请求构建 SearchContext,该上下文包含了查询(Query)和聚合(Aggregator)等关键信息。查询由请求创建,例如 TermQuery 用于文本和关键词字段,其索引结构为倒排索引;PointRangeQuery 用于数字、日期、IP 和点字段,其索引结构为 k-d tree。 构建 Aggregator 时,根据 SearchContext 创建具体聚合器,如 GlobalOrdinalsStringTermsAggregator 用于关键词字段的全局排序术语聚合。 在处理全局排序术语聚合时,如果缓存中不存在全局排序,将创建并缓存全局排序,当分片下的数据发生变化时,需要清空缓存。 全局排序将所有分段中的指定字段的所有术语排序并合并成一个全局排序,同时创建一个 OrdinalMap,用于在收集时从分段 ord 获取全局 ord。 docCounts 用于记录 ord 对应的文档计数。 对于稀疏情况下的数据收集,使用 bucketOrds 来缩减 docCounts 的大小,并通过 LongHash 将全局 ord 与 id 映射起来,收集时在 id 处累加计数。 处理聚合数据时,根据请求创建具体的权重,用于查询分片并创建评分器。查询流程涉及从 FST(Finite State Transducer,有限状态传感器)中查找术语,读取相关文件并获取文档标识符集合。 评分及收集过程中,TopScoreDocCollector 用于为文档评分并获取顶级文档。聚合流程中,GlobalOrdinalsStringTermsAggregator 统计各术语的文档计数。 协调节点最终收集各个分片的返回结果,进行聚合处理,并获取数据,数据节点从存储字段中检索结果。在整个流程中,FetchPhase 使用查询 ID 获取搜索上下文,以防止合并后旧分段被删除。 本文提供了一个基于 Elasticsearch 和 Lucene 的搜索及聚合流程的深入分析,揭示了从请求接收、分片查询、聚合处理到数据收集和结果整合的全过程。通过理解这些关键组件和流程,开发者可以更深入地掌握 Elasticsearch 和 Lucene 的工作原理,优化搜索和聚合性能。java中通过Elasticsearch实现全局检索功能的方法和步骤及源代码

Java中通过Elasticsearch实现全局检索功能的方法和步骤

Elasticsearch,作为基于Lucene的开源搜索引擎,提供了分布式、RESTful接口和无模式JSON文档支持,其特性包括自动发现、分布式、可扩展性和高可靠性等。下面,我们将详细介绍如何使用Java Client API在Java项目中实现全局检索功能。步骤1:添加依赖

首先,你需要在项目中添加Elasticsearch Java客户端的Maven依赖,找到对应版本号(例如:{ version})后,将以下代码添加到pom.xml文件中:步骤2:连接Elasticsearch

通过RestHighLevelClient连接Elasticsearch,如示例所示:步骤3:创建索引

在进行检索前,需创建索引,如下所示:步骤4:添加文档

创建索引后,向其中添加文档,例如:步骤5:执行全局检索

执行检索操作,查找符合条件的文档,如代码所示:步骤6:处理和展示结果

获取并处理搜索结果,将匹配的文档信息展示给用户:步骤7:关闭连接

检索操作结束后,别忘了关闭与Elasticsearch的连接: 通过以上步骤,你已经掌握了在Java中使用Elasticsearch进行全局检索的基本流程。Elasticsearch的强大功能远不止于此,包括排序、分页和聚合等,可以满足更多复杂搜索需求。深入学习,你可以参考Elasticsearch官方文档。ES(Elasticsearch)入门-深入索引操作

探索ES世界的索引操作之旅 首先,我们需要为数据建立一个稳固的基石——创建索引(PUT命令):PUT /index_name

在这里,设置基础配置是关键,例如:"settings":{

"number_of_shards": 2,

"number_of_replicas": 2

},

"mappings":{

"properties": {

"name": "text",

"value": "integer"

}

}

接下来,我们要把数据放入索引的箱子里——写入数据(POST方法):POST /${ indexname}/_doc/${ Id}

举个例子,就像这样:{ "name": "测试_ES", "value": 1 }

查询索引里的宝藏,查询信息(GET方法)是必不可少的:GET /${ indexname}/_doc/${ Id}或 GET /${ indexname}/_search,通过精准的查询条件找到你需要的数据。

当不再需要时,记得清理空间——删除索引(DELETE命令):DELETE /${ indexname}

索引的开关控制也很重要,关闭/打开索引(POST方法):POST /${ indexname}/_close或 POST /${ indexname}/_open

别名,就像索引的快捷方式,创建索引别名(POST方法):POST /_aliases,比如为 "alias1" 添加 "indexname" 和 "indexname"。

举个别名操作的实例:未指定写入索引时,alias1写入会出现错误。

设置is_write_index后,写入操作将顺利进行。

当索引更新时,如PUT /indexname增加主副分片,别名可以灵活调整。

通过POST /_aliases进行REPLACE,将indexname替换为indexname。

总结来说,别名功能强大,像一个动态配置中心,为索引管理带来极大的便利。通过别名,我们可以轻松地调整索引配置,实现灵活且高效的索引操作。