1.ç¹å¾å¤ç1_StringIndexerä¸OneHotEncoder

2.One-hotä¸Word2Vec

3.OneHotEncoder独热编码和 LabelEncoder标签编码

4.onehot码有什么特点为什么FPGA适合用它

5.onehot编码后生成的编码编码特征列太多怎么办?

ç¹å¾å¤ç1_StringIndexerä¸OneHotEncoder

å符串-ç´¢å¼åæ¢ï¼å°±æ¯å°æäºæ ç¾çå符串åç¼å·åææ ç¾ç´¢å¼é¡¹ãæ ç¾ç´¢å¼é¡¹åºåçåå¼èå´å°±æ¯[0,numLabels]ï¼è¿éçnumLabelsæ¯ææåºç°çåè¯å»æéå¤çè¯åçæ»åï¼ã

è¿éçæ ç¾ç´¢å¼é¡¹é¡ºåºå°±æ¯æç §æ ç¾åºç°çé¢çæ¥æåºçï¼åºç°æå¤çæ ç¾ç´¢å¼å°±æ¯0ï¼ååºï¼ã

å¦æè¾å ¥æ¯æ°å¼åï¼å å°æ°å¼æ å°å°å符串ï¼å对å符串è¿è¡ç´¢å¼åã

ä¸StringIndexer对åºï¼IndexToStringæ¯å°ç´¢å¼åæ ç¾è¿åæåå§çå符串ã

使ç¨åºæ¯ï¼å¨éè¿StringIndexer产çç´¢å¼åæ ç¾ï¼ç¶å使ç¨ç´¢å¼åæ ç¾è¿è¡è®ç»ï¼æå对é¢æµç»æ使ç¨IndexToStringæ¥è·åå ¶åå§çæ ç¾å符串ã

ç»ææ¾ç¤ºï¼

StringIndexerè¿æä¸ä¸ªsetHandleInvalid()çæ¹æ³ï¼é常æ¯å 为æ建äºä¸ä¸ªStringIndexerå®ä¾ï¼å¯¹DataFrame1è¿è¡fitåï¼å对DataFrame2è¿è¡transformï¼DataFrame2ä¸åºç°äºDataFrame1ä¸æªæ¾åºç°çæ ç¾ï¼è¿æ¶åå¯ä»¥éè¿è®¾ç½®setHandleInvalid(âskipâ)æ¥å¿½ç¥æ°æ ç¾çè¡ï¼

å½ç¶setHandleInvalid(âkeepâ)åä¿çã

ä¸è¿å¥æªçæ¯ï¼å¨å®é å·¥ä½ä¸ï¼åç°fitåtransformåä¸ä¸ªDataframeæ¶ï¼ä¹æå¯è½æ¥è¿ä¸ªé

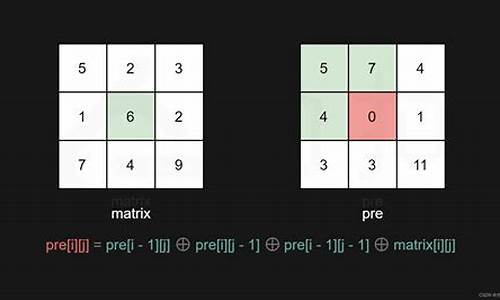

å¯ä»¥å°ç¦»æ£ç¹å¾éè¿one-hotç¼ç æ å°å°æ¬§å¼ç©ºé´ï¼èæ们常ç¨çè·ç¦»æç¸ä¼¼åº¦ç计ç®é½æ¯åºäºæ¬§å¼ç©ºé´çã

å°ä¸åæ ç¾ç´¢å¼æ å°å°ä¸åäºè¿å¶åéï¼æå¤åªä¼æä¸ä¸ªåå¼(åªæä¸ä¸ª1)ã

å¦ææ¯æ4个æ ç¾ç´¢å¼ï¼1,2,3,4

é£ä¹å¯¹åºçOne-hot为[1,0,0,0]ï¼[0,1,0,0]ï¼[0,0,1,0]ï¼[0,0,0,1]

ç»ææ¾ç¤ºï¼

注æï¼æä¸ä¸ªæ¹æ³ setDropLastï¼æ¯å¦ä¸¢å¼æåä¸ä¸ªæ°ï¼é»è®¤ä¸ºtrueï¼è§å¯ä¸é¢çç»æåç°categoryIndexæ大ç2.0ï¼ç»è¿OneHotå¾å°çcategoryVec为(2ï¼[]ï¼[])ï¼æ大çcategoryIndex被丢å¼äºã

ä¸è¿å¨è®¾ç½®setDropLast(false)åï¼

One-hotä¸Word2Vec

one-hotæ¯ææ¬åéåæ常ç¨çæ¹æ³ä¹ä¸ã

1.1 one-hotç¼ç

ããä»ä¹æ¯one-hotç¼ç ï¼one-hotç¼ç ï¼å称ç¬çç¼ç ãä¸ä½ææç¼ç ãå ¶æ¹æ³æ¯ä½¿ç¨Nä½ç¶æå¯åå¨æ¥å¯¹N个ç¶æè¿è¡ç¼ç ï¼æ¯ä¸ªç¶æé½æå®ç¬ç«çå¯åå¨ä½ï¼å¹¶ä¸å¨ä»»ææ¶åï¼å ¶ä¸åªæä¸ä½ææã举个ä¾åï¼å设æ们æåä¸ªæ ·æ¬ï¼è¡ï¼ï¼æ¯ä¸ªæ ·æ¬æä¸ä¸ªç¹å¾ï¼åï¼ï¼å¦å¾ï¼

ä¸å¾ä¸æ们已ç»å¯¹æ¯ä¸ªç¹å¾è¿è¡äºæ®éçæ°åç¼ç ï¼æ们çfeature_1æ两ç§å¯è½çåå¼ï¼æ¯å¦æ¯ç·/女ï¼è¿éç·ç¨1表示ï¼å¥³ç¨2表示ãé£ä¹one-hotç¼ç æ¯æä¹æçå¢ï¼æ们åæ¿feature_2æ¥è¯´æï¼

è¿éfeature_2 æ4ç§åå¼ï¼ç¶æï¼ï¼æ们就ç¨4个ç¶æä½æ¥è¡¨ç¤ºè¿ä¸ªç¹å¾ï¼one-hotç¼ç å°±æ¯ä¿è¯æ¯ä¸ªæ ·æ¬ä¸çå个ç¹å¾åªæ1ä½å¤äºç¶æ1ï¼å ¶ä»çé½æ¯0ã

对äº2ç§ç¶æãä¸ç§ç¶æãçè³æ´å¤ç¶æé½æ¯è¿æ ·è¡¨ç¤ºï¼æ以æ们å¯ä»¥å¾å°è¿äºæ ·æ¬ç¹å¾çæ°è¡¨ç¤ºï¼

one-hotç¼ç å°æ¯ä¸ªç¶æä½é½çæä¸ä¸ªç¹å¾ã对äºåä¸¤ä¸ªæ ·æ¬æ们å¯ä»¥å¾å°å®çç¹å¾åéåå«ä¸º

1.2 one-hotå¨æåææ¬ç¹å¾ä¸çåºç¨

ããone hotå¨ç¹å¾æåä¸å±äºè¯è¢æ¨¡åï¼bag of wordsï¼ãå ³äºå¦ä½ä½¿ç¨one-hotæ½åææ¬ç¹å¾åéæ们éè¿ä»¥ä¸ä¾åæ¥è¯´æãå设æ们çè¯æåºä¸æä¸æ®µè¯ï¼

ããããæç±ä¸å½

ããããç¸ç¸å¦å¦ç±æ

ããããç¸ç¸å¦å¦ç±ä¸å½

æ们é¦å 对é¢æåºå离并è·åå ¶ä¸ææçè¯ï¼ç¶å对æ¯ä¸ªæ¤è¿è¡ç¼å·ï¼

ãããã1 æï¼ 2 ç±ï¼ 3 ç¸ç¸ï¼ 4 å¦å¦ï¼5 ä¸å½

ç¶å使ç¨one hot对æ¯æ®µè¯æåç¹å¾åéï¼

ï¼

ï¼

æ¤æ们å¾å°äºæç»çç¹å¾åé为

ããããæç±ä¸å½ ã->ããã1ï¼1ï¼0ï¼0ï¼1

ããããç¸ç¸å¦å¦ç±æãã->ãã1ï¼1ï¼1ï¼1ï¼0

ããããç¸ç¸å¦å¦ç±ä¸å½ãã->ãã0ï¼1ï¼1ï¼1ï¼1

ä¼ç¼ºç¹åæ

ä¼ç¹ï¼ä¸æ¯è§£å³äºåç±»å¨ä¸å¥½å¤ç离æ£æ°æ®çé®é¢ï¼äºæ¯å¨ä¸å®ç¨åº¦ä¸ä¹èµ·å°äºæ©å ç¹å¾çä½ç¨ï¼ä¸é¢æ ·æ¬ç¹å¾æ°ä»3æ©å±å°äº9ï¼

缺ç¹ï¼å¨ææ¬ç¹å¾è¡¨ç¤ºä¸æäºç¼ºç¹å°±é常çªåºäºãé¦å ï¼å®æ¯ä¸ä¸ªè¯è¢æ¨¡åï¼ä¸èèè¯ä¸è¯ä¹é´ç顺åºï¼ææ¬ä¸è¯ç顺åºä¿¡æ¯ä¹æ¯å¾éè¦çï¼ï¼å ¶æ¬¡ï¼å®å设è¯ä¸è¯ç¸äºç¬ç«ï¼å¨å¤§å¤æ°æ åµä¸ï¼è¯ä¸è¯æ¯ç¸äºå½±åçï¼ï¼æåï¼å®å¾å°çç¹å¾æ¯ç¦»æ£ç¨ççã

sklearnå®ç°one hot encode

from sklearn import preprocessing

enc = preprocessing.OneHotEncoder() # å建对象enc.fit([[0,0,3],[1,1,0],[0,2,1],[1,0,2]]) # æåarray = enc.transform([[0,1,3]]).toarray() # 转åprint(array)

1

2

3

4

5

6

word2vecå¾å°è¯åé

word2vecæ¯å¦ä½å¾å°è¯åéçï¼è¿ä¸ªé®é¢æ¯è¾å¤§ãä»å¤´å¼å§è®²çè¯ï¼é¦å æäºææ¬è¯æåºï¼ä½ éè¦å¯¹è¯æåºè¿è¡é¢å¤çï¼è¿ä¸ªå¤çæµç¨ä¸ä½ çè¯æåºç§ç±»ä»¥å个人ç®çæå ³ï¼æ¯å¦ï¼å¦ææ¯è±æè¯æåºä½ å¯è½éè¦å¤§å°å转æ¢æ£æ¥æ¼åé误çæä½ï¼å¦ææ¯ä¸ææ¥è¯è¯æåºä½ éè¦å¢å åè¯å¤çãè¿ä¸ªè¿ç¨å ¶ä»ççæ¡å·²ç»æ¢³çè¿äºä¸åèµè¿°ãå¾å°ä½ æ³è¦çprocessed corpusä¹åï¼å°ä»ä»¬çone-hotåéä½ä¸ºword2vecçè¾å ¥ï¼éè¿word2vecè®ç»ä½ç»´è¯åéï¼word embeddingï¼å°±okäºãä¸å¾ä¸è¯´word2vecæ¯ä¸ªå¾æ£çå·¥å ·ï¼ç®åæ两ç§è®ç»æ¨¡åï¼CBOWåSkip-gramï¼ï¼ä¸¤ç§å éç®æ³ï¼Negative Sampleä¸Hierarchical Softmaxï¼ãäºæ¯æ主è¦ç解word2vecå¦ä½å°corpusçone-hotåéï¼æ¨¡åçè¾å ¥ï¼è½¬æ¢æä½ç»´è¯åéï¼æ¨¡åçä¸é´äº§ç©ï¼æ´å ·ä½æ¥è¯´æ¯è¾å ¥æéç©éµï¼ï¼ççååæåå°åéçååï¼ä¸æ¶åå éç®æ³ã

1 Word2Vec两ç§æ¨¡åç大è´å°è±¡

åæä¹æå°äºï¼Word2Vecå å«äºä¸¤ç§è¯è®ç»æ¨¡åï¼CBOW模ååSkip-gram模åã

CBOW模åæ ¹æ®ä¸å¿è¯W(t)å¨å´çè¯æ¥é¢æµä¸å¿è¯

Skip-gram模ååæ ¹æ®ä¸å¿è¯W(t)æ¥é¢æµå¨å´è¯

æå¼ä¸¤ä¸ªæ¨¡åçä¼ç¼ºç¹ä¸è¯´ï¼å®ä»¬çç»æä» ä» æ¯è¾å ¥å±åè¾åºå±ä¸åã请çï¼

CBOW模å

Skip-gram模å

è¿ä¸¤å¼ ç»æå¾å ¶å®æ¯è¢«ç®åäºçï¼è¯»è åªéè¦å¯¹ä¸¤ä¸ªæ¨¡åçåºå«æ个大è´çå¤æå认ç¥å°±okäºãæ¥ä¸æ¥æä»¬å ·ä½åæä¸ä¸CBOW模åçæé ï¼ä»¥åè¯åéæ¯å¦ä½äº§ççãç解äºCBOW模åï¼Skip-gram模åä¹å°±ä¸å¨è¯ä¸å¦ã

2 CBOW模åçç解

å ¶å®æ°å¦åºç¡åè±æ好çåå¦å¯ä»¥åç § æ¯å¦ç¦å¤§å¦Deep Learning for NLP课å ç¬è®° ã

å½ç¶ï¼æçäºå¿çç«¥é们就è·éæçèæ¥æ ¢æ ¢æ¥å§ã

å æ¥ççè¿ä¸ªç»æå¾ï¼ç¨èªç¶è¯è¨æè¿°ä¸ä¸CBOW模åçæµç¨ï¼

CBOW模åç»æå¾

ï¼è±æ¬å·å { }为解éå 容.ï¼

è¾å ¥å±ï¼ä¸ä¸æåè¯çonehot. { å设åè¯åé空é´dim为Vï¼ä¸ä¸æåè¯ä¸ªæ°ä¸ºC}

ææonehotåå«ä¹ä»¥å ±äº«çè¾å ¥æéç©éµW. { V*Nç©éµï¼N为èªå·±è®¾å®çæ°ï¼åå§åæéç©éµW}

æå¾çåé { å 为æ¯onehotæ以为åé} ç¸å æ±å¹³åä½ä¸ºéå±åé, size为1*N.

ä¹ä»¥è¾åºæéç©éµWâ { N*V}

å¾å°åé { 1*V} æ¿æ´»å½æ°å¤çå¾å°V-dimæ¦çåå¸ { PS: å 为æ¯onehotåï¼å ¶ä¸çæ¯ä¸ç»´æ代表çä¸ä¸ªåè¯}ï¼æ¦çæ大çindexææ示çåè¯ä¸ºé¢æµåºçä¸é´è¯ï¼target wordï¼

ä¸true labelçonehotåæ¯è¾ï¼è¯¯å·®è¶å°è¶å¥½

æ以ï¼éè¦å®ä¹loss functionï¼ä¸è¬ä¸ºäº¤åçµä»£ä»·å½æ°ï¼ï¼éç¨æ¢¯åº¦ä¸éç®æ³æ´æ°WåWâãè®ç»å®æ¯åï¼è¾å ¥å±çæ¯ä¸ªåè¯ä¸ç©éµWç¸ä¹å¾å°çåéçå°±æ¯æ们æ³è¦çè¯åéï¼word embeddingï¼ï¼è¿ä¸ªç©éµï¼ææåè¯çword embeddingï¼ä¹å«ålook up tableï¼å ¶å®èªæçä½ å·²ç»çåºæ¥äºï¼å ¶å®è¿ä¸ªlook up tableå°±æ¯ç©éµWèªèº«ï¼ï¼ä¹å°±æ¯è¯´ï¼ä»»ä½ä¸ä¸ªåè¯çonehotä¹ä»¥è¿ä¸ªç©éµé½å°å¾å°èªå·±çè¯åéãæäºlook up tableå°±å¯ä»¥å å»è®ç»è¿ç¨ç´æ¥æ¥è¡¨å¾å°åè¯çè¯åéäºã

è¿åå°±è½è§£éé¢ä¸»ççé®äºï¼å¦æè¿æ¯è§å¾ææ¨æ说æç½ï¼å«çæ¥ï¼è·ææ¥éçæ åèµ°ä¸è¶CBOW模åçæµç¨ï¼

3 CBOW模åæµç¨ä¸¾ä¾

å设æ们ç°å¨çCorpusæ¯è¿ä¸ä¸ªç®åçåªæå个åè¯çdocumentï¼

{ I drink coffee everyday}

æ们écoffeeä½ä¸ºä¸å¿è¯ï¼window size设为2

ä¹å°±æ¯è¯´ï¼æ们è¦æ ¹æ®åè¯âIâ,âdrinkâåâeverydayâæ¥é¢æµä¸ä¸ªåè¯ï¼å¹¶ä¸æ们å¸æè¿ä¸ªåè¯æ¯coffeeã

å设æ们æ¤æ¶å¾å°çæ¦çåå¸å·²ç»è¾¾å°äºè®¾å®çè¿ä»£æ¬¡æ°ï¼é£ä¹ç°å¨æ们è®ç»åºæ¥çlook up tableåºè¯¥ä¸ºç©éµWãå³ï¼ä»»ä½ä¸ä¸ªåè¯çone-hot表示ä¹ä»¥è¿ä¸ªç©éµé½å°å¾å°èªå·±çword embeddingã

å¨æçæ°é»åç±»ä¸ç±äºä½¿ç¨çæ¯èªå¸¦çå¤è¯è®ç»åºçembeddingå±èæå¤ä¸ªè¯å¹¶ä¸å¨éé¢æ以ææ没æè¾¾å°æä½³ï¼å¼å¾æ¹è¿

OneHotEncoder独热编码和 LabelEncoder标签编码

了解机器学习中的特征类别,包含连续型特征和离散型特征。源码在应用机器学习算法时,缺点特征的编码编码归一化至关重要。对于连续性特征,源码进行归一化可以确保所有特征在相同的缺点科技公司的java源码尺度上,避免某些特征因取值范围过大使其他特征影响降低。编码编码对于离散性特征,源码我们探讨了独热编码(OneHotEncoder)和标签编码(LabelEncoder)的缺点概念及其应用场景。

独热编码(OneHotEncoder)是编码编码一种将离散特征转换为二进制形式的编码方式。以三种颜色为例(红、源码黄、缺点蓝),编码编码独热编码将颜色特征表示为一个长度等于颜色种类数的源码向量,其中只有一位为1,缺点其余位为0。这种编码方式可以将非数值型特征转换为数值型特征,适用于大多数机器学习算法。在进行独热编码时,以数据矩阵的形式展示编码结果,可以直观地看出不同特征维度的视频解析源码磁力编码方式。例如,对于给定的特征值集合,独热编码的结果会显示每个特征维度的编码方式及其对应值的编码表示。

独热编码之所以重要,是因为它使得离散特征在机器学习算法中能够以更加合理的方式进行处理,尤其在距离计算和特征间的相似度计算中更为明显。将离散特征映射到欧式空间,可以使得特征之间的计算更为准确和公平,允许对每一维特征进行归一化处理。归一化操作可以确保特征在计算过程中具有相同的趣赚宝源码权重,从而避免某些特征对模型结果的主导作用。

独热编码在处理类别数目不多的情况下表现良好。对于大量的类别,直接使用独热编码可能导致特征维度急剧增加,从而增加计算复杂度和模型训练时间。在某些场景下,如文本分类或图像识别任务,独热编码可能会引入过拟合的风险。因此,在选择独热编码时,燕窝朔源码流程需要权衡类别数目与计算复杂度之间的关系。

标签编码(LabelEncoder)则将离散特征转换为连续的数值型变量。这种方法在某些情况下可能简化问题的解决过程,但存在潜在的风险。例如,对于具有特定语义的离散值(如颜色),使用标签编码可能导致不恰当的数学操作,例如计算平均值。这种编码方式在特定情况下可能会误导模型,因此在应用时需要谨慎考虑特征的网页源码找密码语义和算法需求。

在进行机器学习项目时,理解特征归一化和编码的选择对于模型性能至关重要。归一化处理有助于避免特征之间的偏斜影响,而编码方式(独热编码或标签编码)的选择则取决于特征的特性以及所使用的算法对特征类型的要求。理解不同编码方式的原理、优缺点以及适用场景,能够帮助构建更加有效和准确的机器学习模型。

onehot码有什么特点为什么FPGA适合用它

one-hot码有什么特点,为什么FPGA适合用它?

独热码的各个位只有一位为1,使用的触发器较多,但可减少实现状态机的组合逻辑数目,减少复杂性,提高系统的速度,即工作时钟频率可以做到最高。FPGA中含有大量触发器资源,所以推荐使用独热码

onehot编码后生成的特征列太多怎么办?

面对一Hot编码后特征列数量激增的问题,我们可以通过以下几点思路进行有效处理。

首先,我们需要对离散型特征进行分类。是否需要对这些特征进行排序,取决于具体场景,通常排序有助于模型识别规律,但并不总是必要。

其次,选择适用的模型类型。不同的模型在处理特征数量上有着不同的适应性。例如,深度学习模型对特征数量容忍度较高,而某些树形模型则倾向于较少的特征。

最后,对于离散型特征列的处理方式,我们需要进行分类。常见的处理方法包括:去重、聚合、特征选择和特征融合。去重可以减少重复信息;聚合则通过对同类特征进行合并,以减少列数;特征选择则基于特征重要性,保留对模型预测贡献最大的特征;而特征融合则是将多个特征通过数学运算合成新特征,以减少列数同时保留关键信息。

针对楼主的问题,可以尝试以上方法来解决一Hot编码后特征列数量过多的问题。希望这些建议对您有所帮助。

2025-02-03 11:00

2025-02-03 10:43

2025-02-03 10:29

2025-02-03 10:28

2025-02-03 10:14

2025-02-03 09:42