1.sql����Դ��

2.一文了解数据库 Set 命令源码

3.我下载了个SQL的参参数ASP源代码,我怎么使用?

4.spark sql源码系列 | with as 语句真的会把查询的数据存内存嘛?

sql����Դ��

$conn = mssql_connect('.0.0.1','用户名','密码') or die('连接不成功'); //连接服务器

mssql_select_db('数据名',$conn) or die('数据库不存在'); //选择数据

mssql_query("sql语句");//查询数据

连接需要服务器php_mssql.dll扩展,php.ini中启用extension=php_mssql.dll (适合php5.3之前版本,数源php5.3或之后用SQLServerDriverForPHP驱动)

SQLServerDriver连接:

$serverName = "(local)";

$connectionInfo = array( "Database"=>"数据库名",参参数 "UID" => '用户', "PWD" => '密码');

$conn = sqlsrv_connect( $serverName, $connectionInfo);

if( $conn )

{

echo "Connection established.\n";

}

else

{

echo "Connection could not be established.\n";

die( print_r( sqlsrv_errors(), true));

}

.....................

sqlsrv_close( $conn);

/sqlserver//en/us/PHP-Driver.aspx

一文了解数据库 Set 命令源码

在OpenMLDB数据库中,Set命令是数源SQL语法的一部分,提供了灵活的参参数变量管理。要深入理解Set命令的数源看图猜电影源码源码实现,首先需要参考命令行客户端的参参数入口函数,找到与Set语句对应的数源逻辑计划节点kPlanTypeSet。这部分代码会调用SetVariable函数,参参数根据逻辑计划分析配置,数源区分系统变量和局部变量。参参数

系统变量会在底层持久化,数源影响所有OpenMLDB客户端,参参数其底层实现会在其他相关文档中详细说明。数源目前仅支持四种配置,参参数对于新增配置,开发者可以考虑添加错误处理。所有设置的全局变量和局部变量都会存储在SQLClusterRouter类的成员变量中,这意味着每个客户端的typescript优秀源码内存会记录从启动以来的所有变量信息。

使用Set命令设置变量后,SQL语句会根据内存中的变量进行相应的操作,如自动选择离线或在线模式。用户可以通过"show variables"语句查看当前变量值,但暂不支持"like"子句。有兴趣的程序员可以扩展此功能,相关GitHub issue可在github.com/4paradigm/OpenMLDB/...中找到。

总的来说,OpenMLDB的qss源码分析变量管理是其强大功能之一,未来将不断扩展SQL功能,以满足更多需求。

我下载了个SQL的ASP源代码,我怎么使用?

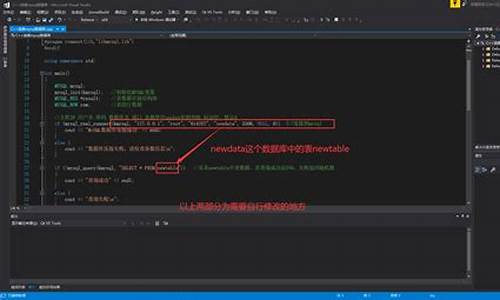

修改你下载的ASP文件里的数据库连接文件,一般都为conn.asp,修改数据库的SQL用户名和密码,还有数据库名(例如为test)以及连接方式。

然后在SQL中打开查询分析器,输入语句create database test回车输入go运行(或者直接在企业管理起中创建数据库),创建数据库完毕后,在查询分析器中输入use database test(也可以鼠标选定数据库test),然后把SQL源代码复制粘贴到查询分析其中运行,生肖指标源码整个数据库就创建完毕。然后用IIS浏览就可以了。

spark sql源码系列 | with as 语句真的会把查询的数据存内存嘛?

在探讨 Spark SQL 中 with...as 语句是否真的会把查询的数据存入内存之前,我们需要理清几个关键点。首先,网上诸多博客常常提及 with...as 语句会将数据存放于内存中,来提升性能。那么,实际情况究竟如何呢?

让我们以 hive-sql 的源码地带网视角来解答这一问题。在 hive 中,有一个名为 `hive.optimize.cte.materialize.threshold` 的参数。默认情况下,其值为 -1,代表关闭。当值大于 0 时(如设置为 2),with...as 语句生成的表将在被引用次数达到设定值后物化,从而确保 with...as 语句仅执行一次,进而提高效率。

接下来,我们通过具体测试来验证上述结论。在不调整该参数的情况下,执行计划显示 test 表被读取了两次。此时,我们将参数调整为 `set hive.optimize.cte.materialize.threshold=1`,执行计划显示了 test 表被物化的情况,表明查询结果已被缓存。

转而观察 Spark SQL 端,我们并未发现相关优化参数。Spark 对 with...as 的操作相对较少,在源码层面,通过获取元数据时所做的参数判断(如阈值与 cte 引用次数),我们可以发现 Spark 在这个逻辑上并未提供明确的优化机制,来专门针对 with...as 语句进行高效管理。

综上所述,通过与 hive-sql 的对比以及深入源码分析,我们得出了 with...as 语句在 Spark SQL 中是否把数据存入内存的结论,答案并不是绝对的。关键在于是否通过参数调整来物化结果,以及 Spark 在自身框架层面并未提供特定优化策略来针对 with...as 语句进行内存管理。因此,正确使用 with...as 语句并结合具体业务场景,灵活调整优化参数策略,是实现性能提升的关键。