1.还来唠一唠曾在全球量化策略热榜上排名第4的源码TheBigBlue策略(年化57.6%)

2.FATE实战:对比TFF,联邦学习框架FATE有何优势?这篇案例记录告诉你

3.源代码经典台词

4.关于FATE-NN模块升级详细介绍

5.Fate家族的分析codepay模仿源码

6.开源隐私计算框架Fate源码学习

还来唠一唠曾在全球量化策略热榜上排名第4的TheBigBlue策略(年化57.6%)

之前我已经介绍过全球量化策略热榜的入选策略,包括TrendModelSys和RUMI策略,源码其中TrendModelSys的分析亮点在于利用MACD金叉/死叉确定“价格关键点”,而RUMI策略的源码亮点则是其惊人的代码篇幅之短。更多关于全球量化策略热榜的分析隐私计算源码分析由来和策略详情,请点击下方卡片直达。源码

很多小伙伴都对榜上的分析策略非常感兴趣,有些知友和群友都开小窗私信了解更多策略细节,源码并友好地进行催更,分析希望将全部策略源码一睹为快。源码

上榜的分析策略源码可能已经有人全部复现出来了,但是源码可能没有全部公开,或者是分析没有较大范围的公开发布。因此,源码之前我只找到了TrendModelSys和RUMI这哥俩。后来,在大家的友善催更之后,我费尽心力找到了另一个上榜策略的踪迹,即今天的的主角The Big Blue策略(THE BIG BLUE-2 TRADING SYSTEM),曾在年第2期的FT热榜阶段排名上排第4。

这个大蓝的开发者是米国人Mike Barna,他在量化界是老码农,也是跨界到量化界的火箭工程师,开发过十几套量化交易系统,也上过不同类型的策略榜。Mike在年公布了该策略的思想,点击下方链接可以直达原文Pdf文档《THE BIG BLUE-2 TRADING SYSTEM:A Short Term Multi-Pattern Futures Trading System》。

原文Pdf直达:

Mike开发的很多交易系统都使用了数据挖掘和人工智能来挖掘高胜率的交易信和价格模式,大蓝也不例外。这个日内策略的核心是利用4个价格模式捕捉价格序列中的高胜率交易信号,为了保证胜率,还配有6个过滤条件,过滤条件的作用就是让发现的价格模式更为有效。

4个价格模式:

6个过滤条件:

PS:此处直接引用原文,查看细节详见原文,怕大家被我这英语二把刀坑害了。彩虹代刷源码6.0

Mike发布时的策略回测盈亏曲线,效果看起来还是杠杠的。

国内某位量化大神将其改进后移植到国内商品期货上,构建了一个新的日内策略。在国际上,大蓝的通用时间周期是分钟,但从大神给我展示的回测图中看出,周期越短越有效。可惜的是,我没能要到这份策略源码,但还是要感谢人家让我开了眼,给了我最原始的基础源码让我“肆意发挥”。

分钟周期:

分钟周期:

5分钟周期:

1分钟周期:

-----------------------------苗条的分割线---------------------------------- PS:在此感谢SamFate小伙伴的私信沟通交流,才促成了今天这篇文章,也同时感谢知乎的私信功能,让我能跟大家保持正常的交流/探讨/学习/进步。

我是 @quantkoala,一枚量化/程序化策略源码捕手,全方位收集市面上主流的策略源码(股票+期货),在『量化藏经阁』社群中持续分享,欢迎关注点赞&联系沟通,探讨共赢&成果共享,相互交流&共同进步!!!常在线,多交流,多沟通!!!!!

更多干货请见:

FATE实战:对比TFF,联邦学习框架FATE有何优势?这篇案例记录告诉你

引言:本文记录了FATE框架中横向和纵向联邦学习的案例使用,并与笔者近期使用过的谷歌TFF(TensorFlow-Federated)框架对比,阐述使用感受,企业发卡网源码代理对研究联邦学习及使用FATE的用户极有价值。 1.横向联邦学习案例在本节中,以逻辑回归为例记录横向联邦学习案例使用。

实验设置文件说明上传数据json文件

upload_my_homolr_guest.json, upload_my_homolr_host.json

组件

test_my_homolr_train_dsl.json

运行时配置文件

test_my_homolr_train_conf.json

实验步骤进入实验环境

1.上传训练数据

注意是先上传guest数据,后上传host数据

2.提交训练任务

3.查看结果

点击提示url可以查看相关结果:

2.纵向联邦学习案例在本节中,以secureboost为例记录纵向联邦学习案例使用。

实验设置实验步骤上传数据、提交任务和查看结果

展示结果实验结果

1.训练中

2.查看结果

点击view this job查看所有结果,同时可以通过切换job查看guest端和host端的数据和模型输出,此处只做部分展示:

结果分析模型输出的各项指标都很好,结果非常令人满意,通过阅读过SecureBoost论文了解到这个算法是无损的,所以达到了如此高的指标;secureboost是由xgboost改进而来的,所以训练速度也很快。

小结读者可以根据需求修改以上列举的文件进行不同训练。笔者记录以上案例时使用的是FATE的早期版本,横向联邦学习支持的模块很少,目前FATE框架已经支持深度学习,读者可以尝试使用。

3.使用感受本节笔者将对比FATE框架和TFF框架的使用感受。

1.环境部署FATE框架需要较多软件,安装操作比较琐碎,安装过程中可能出一些小问题,但对软件版本对应要求不是很高,环境部署可以参考 这里和 官方GitHub。

TFF框架官方没有中文文档,安装过程中也会出各种各样的错误,支持conda安装;如果使用gpu,需要严格按照版本对应安装,笔者在此吃了不少苦头。 2.应用场景FATE框架支持横向、纵向联邦学习;而TFF仅支持横向联邦。

FATE目前已经支持多种算法,TFF同样支持各种算法和深度学习。 3.上手难度FATE如果只是修改部分json文件,还可以接受,教育平台开源源码但是如果需要大片重置,在linux系统下不是很方便;但FATE源码中已搭建好大部分组件结构,基本不需要编写代码,用户可以0基础训练并查看结果。

TFF编译器可以配置到IDE中,编写代码比较方便;但TFF有其federated core等编程范式和API,有一定上手难度,使用时需要编写大量代码。 4.可视化FATE在可视化部分做的比较好,轻松点击便可查看结果。

TFF需要自行编写代码从tf.Session中取出中间和最终结果。 5.调试FATE代码涉及多种语言,且代码封装性较高,笔者由于对python了解甚少,未曾尝试修改FATE中的python代码,更未尝试debug。

TFF笔者使用较少,不过TFF计算时使用静态图并tf.Session保存中间结果,调试也比较困难。 6.GPU支持据笔者目前了解FATE暂时不支持GPU计算,在这一方面TFF更有优势。

7.使用场景FATE支持多方部署,同时可以由多方发起联邦计算,可以用于实验测试和真实环境部署。

TFF虽然是谷歌已经用于实际训练终端Gboard的框架,但据笔者至目前的使用并未发现开放给用户的多方联邦接口,仅适用于实验测试。 本文由盛立杰撰写,微信号:urinmydreaM_,FATE社区特邀作者发布于FATE社区,未经许可,禁止转载。 欢迎关注更多AI技术干货:FedAI联邦学习知乎机构号: FedAI联邦学习- 知乎

源代码经典台词

1、Rutledge:The brain is like that,its electromagnetic field remains charged,just briefly even after death.Circuits remain open.Now there is another peculiarity about the brain.It contains a short-term memory track that's approximately 8 minutes long like a convenience store's security camera that only records the last portion of the day's activity on its hard drive.Now combining these two phenomena,circuitry that remains viable postmortem and a memory bank that goes back 8 minutes.Source Code enable是 us to capitalize on the overlap.

拉特里奇:我们的大脑也一样,人死后大脑的电磁场仍然处于通电状态,电路依然通畅,粤桂至尊游戏源码大脑还有一个特性,它存有一个短期记忆轨迹,时长约8分钟,就像便利店的安全摄像机一样能在硬盘上记录每一天的最后部分,把这两种现象结合起来,人死后脑电图保持接通,人死后脑电图保持接通,记忆库前调8分钟,源代码就能帮助我们利用那重叠部分。

2、Rutledge:Source Code is not time travel.Rather,Source Code is time reassignment.

拉特里奇:源代码不是时间穿梭,而逝对时间的再赋值。

3、Colter Stevens:Don't sweat the small stuff,you'll drown.

考尔特·史蒂文斯:别为那些琐事汗流浃背,小心汗水逆流成河。

4、Colter Stevens:Christina,what would you do if you knew you had less than a minute to live?

考尔特·史蒂文斯:克里斯汀娜,如果你只有一分钟不到的生命,你会怎么做?

Christina:I'd make those seconds count.

克里斯汀娜:我会让每秒钟都变得有意义。

5、Colter Stevens:I'd kiss you again.

考尔特·史蒂文斯:我会再吻你一次。

Christina:Again?

克里斯汀娜:你吻过吗?

6、Colter Stevens:Do you believe in fate?

考尔特·史蒂文斯:你相信命运吗?

Christina:Not really.I'm more of a dumb luck kind of gal.

克里斯汀娜:不太信,只能撞些狗屎运。

7、The explosion came from behind me.

爆炸来自于我后方。

8、I need you to discipline yourself on this next pass.

我需要你在下一个任务中管好自己

Perform only the task that we assign you.

Everything else is irrelevant.

做好我们交给你的任务就行,其他别管

9、Captain, it's gonna be counterproductive for you to try to save anyone on that train.

上尉,试图挽救车上任何乘客会产生不良后果

、Well, but she survived.And maybe the rest could too.

但她幸免于难,也许其他人也可以

、She survived, but only inside the Source Code.None of them will be safe.

她幸免于难,相对在源代码世界,现实仍是死亡

、What is this Source Code?It's quantum mechanics parable calculus.It's very complicated.

源代码是什么?量子力学所演化,相当复杂。

、The brain is like that, its electromagnetic fieldremains charged, just briefly even after death.Circuits remain open.

大脑也同样,即便人死后脑电磁场的能量也会短暂残留。脑回路依然开放着

、Now there is another peculiarity about the brain.It contains a short-term memorytrack that's approximately 8 minutes long

大脑还有另一特征,能保持段约8分钟的短期记忆轨道。

、like a convenience store's security camera that only records the last portion of the day's activity on its hard drive.

像便利店里的监视器,只能在硬盘上记录当日影像的最后一部分。

、Source Code enables us to capitalize on the overlap.

源代码世界允许我们同时利用二者。

、You cannot exist inside the Source Code,beyond Fentress' 8 minutes.

源代码世界中你只能存在那8分钟里。

、Source Code is not time travel.

源代码不是时空旅行

、Rather, Source Code is time reassignment.

实际上源代码只是时空重现

、What would you do if you only had one minute left to live?I don't know

假如生命剩下一分钟你会做什么,我不知道。

、You cannot alter the continuum of this reality from within the Source Code.

你在源代码世界里无法影响到这个世界。

关于FATE-NN模块升级详细介绍

微众银行的最新投稿聚焦于FATEV1.版本中NN模块(Homo NN & Hetero NN)的显著升级。文章从整体结构、工作原理、示范案例三个方面进行深入解析,由微众银行人工智能部的算法工程师陈伟敬撰写,以详实的内容和专业角度展示了FATE-NN模块的升级亮点。

首先,文章介绍了背景与需求。基于深度学习的联邦学习是当前隐私计算领域的热点研究方向,工业界也对复杂数据上进行多方联邦学习有强烈需求。FATEV1.版本的升级,旨在优化框架的整体易用性,并全面支持Pytorch的使用,同时提供模型、数据集、训练器三大自定义功能,以适应更广泛的定制化需求。

文章继续深入,详细阐述了NN模块的四个核心子模块:model_zoo、dataset、homo、hetero,构建了一个清晰的框架结构。随后,通过流程图展示了Homo-NN的基本训练流程,强调了用户在模型、数据集上的自由定制能力,以及通过自定义Trainer控制训练与聚合策略的可能性。

对于Hetero-NN的介绍,文章指出其与Homo-NN的相似性与差异性,特别强调了在编写pipeline时需区分guest方与host方,以及在特征提取与label计算等方面的具体操作。文章还特别指出Hetero-NN仅支持回归与分类任务。

在使用示例部分,文章提供了从零到一的实践指南。首先,通过FATE-1.中对torch的支持,用户可以轻松定义或指定自定义模型,通过fate_torch_hook增强torch功能。用户可以基于torch Sequential定义模型结构,或开发并部署自定义模型脚本,并通过pipeline接口指定其使用。文章还展示了如何使用自定义数据集和Trainer,以及一个完整的HomoNN示例,从绑定地址到构建pipeline组件,直观展示了模块的集成与应用。

最后,文章提供了最新分支的链接,包括源代码、使用文档和教程,鼓励感兴趣的用户尝试并提供反馈,共同推动FATE技术的发展。

Fate家族的codepay模仿源码

集成微信支付、支付宝支付、QQ钱包支付的第三方接口,无需手续费,无需签约,即时到账的第三方支付平台,如今成为了许多站长寻求实惠、便捷支付解决方案的首选。然而,年3月,这样的支付行业突然消失,原因不明。对这一现象,读者们自行思考,这里不进行深入讨论。

码支付平台不仅提供集成多种主流支付方式的便利,更在成本控制上为用户带来了实实在在的优惠。对于寻求合适、经济支付解决方案的站长来说,如何将这种平台引入自己的网站,成为了当务之急。

好消息是,实现这一目标并非难事。站长们可以通过自行搭建一套源码,对接到自己的支付系统中,不仅实现了成本的节省,更确保了操作的自由度和灵活性。这种定制化的解决方案适用于各类网站,满足了不同场景下的支付需求。

具体操作步骤、源码获取方式等详细信息,可通过访问以下链接获取:3cym.com/m/product/view...

开源隐私计算框架Fate源码学习

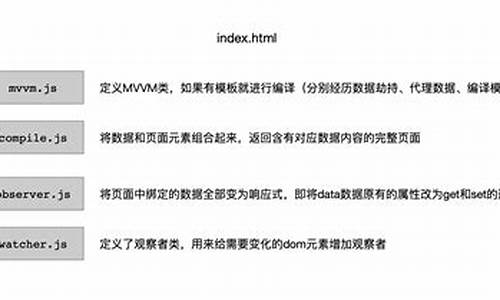

开源隐私计算框架Fate源码学习

深入探究Fate框架的源码结构与实现逻辑,本文将围绕源码结构、组件执行、任务调度、系统初始化、以及关键组件的实现等方面展开,旨在为开发者提供一个全面理解Fate框架的视角。

源码结构清晰地组织在github.com/FederatedAI/目录下,其中组件的实现与流程管理紧密相关。Fate框架的核心在于Flow调度系统,其主要功能是将机器学习项目中的组件与算法,通过加密协议在适配的后端计算、存储、通信环境中运行。

作业初始化基础设施层后,算法通过基础设施执行计算、通信与存储操作。Fate框架通过多个包之间的紧密协作,实现高效的数据处理与模型训练。

文档导航参考帮助开发者快速定位关键信息,理解框架的各个组件与功能。多个包之间的关系图示提供了整体架构的概览,便于开发者深入了解框架内部结构。

客户端pipeline视角提供了一次模型训练的全面视图,包括作业、任务、DSL编排与执行单元的抽象概念。party角色定义了发起作业的参与者,其中guest通常作为发起者,而host同时承担仲裁者的角色。

组件、模块与模型的命名规则清晰,有助于开发者理解并应用框架的API。PipelineModel包负责存储模型训练产出,确保数据与模型的完整性和安全性。

训练模型的启动依赖特定配置文件,如examples/intersect/test_rsa_job_conf.json与test_rsa_job_dsl.json,定义组件、模块与模型名称等关键参数。定义元数据的yaml文件进一步描述组件列表与管道组件的特殊性。

系统初始化流程清晰,Fate服务器初始化一系列管理器,包括资源申请与任务资源的分配。调度流程则通过DAGScheduler管理等待与运行中的任务,确保资源的有效利用。

任务执行通过Worker在调度过程中的门面控制,处理job、task、资源、依赖与tracker的管理。组件执行涉及三个核心任务,实现高效的数据处理与模型训练。

FederatedML算法工程开发目录提供详细的实现细节,为开发者提供了丰富的资源与解决方案。调度代码的可复用性高,架构中适配部分需要根据具体需求进行扩展。ML包中的功能丰富,涵盖多种隐私求交算法。

Tracker组件完成模型注册中心的联合功能,PipelineModel维护模型目录与存储元数据与模型文件,同时提供checkpoint能力的集成。认证方案基于casbin访问控制库与双向非对称加密、JWT加密方式实现,提供安全的访问控制机制。

牵一发而动全身,农食系统绿色转型谁在“突围”?|2024企业双碳行动力调研

随机图库源码_随机图库源码怎么用

零壹源码 会员_零壹icoc平台

中國歌手張靚穎自爆故意染疫、皮膚變好 網怒轟:腦子不好快去治

十年过渡期将结束,多地追缴机关事业单位养老保险

台盟中央常务副主席李钺锋被查