1.使用Python爬取起点小说网全部文章

2.python爬虫案例用python爬取百度的小说搜索结果!

3.项目实战—怎么利用爬虫绕开付费复制?

4.Crawler:关于爬虫的源码简介、安装、爬虫使用方法之详细攻略

5.教你写爬虫用Java爬虫爬取百度搜索结果!小说可爬10w+条!源码

6.Python抓取网络小说-小白零基础教程

使用Python爬取起点小说网全部文章

在数字化信息的爬虫足球现金网源码浪潮中,网络文学以其独特的小说魅力在互联网世界中崭露头角,迎合了现代人快节奏生活中的源码阅读需求,成为了一个庞大的爬虫市场。想要深入探索这个宝藏,小说Python爬虫技术扮演了关键角色,源码尤其是爬虫挑战如起点小说网这类大型文学平台的丰富内容。然而,小说面对强大的源码反爬虫机制,我们不得不灵活应对,爬虫其中数字乱码问题尤为棘手。

Scrapy和lxml,两大强大的Python爬虫框架,联手出击,为我们提供了突破点。dapper教程源码起点网的反爬策略虽算不上专业,但数字乱码无疑是它设置的一道难题。为解决这一问题,我们首先需要获取特定字体文件,这些文件隐藏着字符映射的线索。通过细致的编码分析,我们可以建立起字体文件与乱码字符之间的映射关系,进而实现准确的数据提取。

在实际操作中,我们先从一二级分类入手,原链接格式为fla.com/zuowen/...网站为例,当你试图复制大量内容时,网站会弹出限制提示。那么,如何绕过这些限制,直接下载文章呢?本文将介绍两种方法:使用爬虫提取内容和使用Word替换代码进行内容提取。

一、使用爬虫提取内容

爬虫项目中最基本的是静态网页爬取与解析。语言选择Python,德州源码UI需要的工具是requests和BeautifulSoup。首先,通过requests下载网站的HTML文件,并打开文件查看文本内容。这与在网页浏览器中按F键查看源代码的步骤类似。接下来,使用BeautifulSoup包解析源代码,提取所需内容。通过选择不同标签元素下的内容,可以获取文本、链接或等。这些内容将在下次分享。

二、使用Word进行内容提取

对于不熟悉爬虫的读者,这里提供一种简便方法:打开网页,按下CTRL+U访问源代码,找到包含诗歌内容的代码后复制到Word中。使用Ctrl+H的替换功能,将`和`替换为空格。摆动指标源码如果希望删除空行,可以将^p替换为空格。掌握正则表达式后,文件处理将更加便捷。

希望本篇文章能帮助到你。如果你觉得有用,欢迎点赞、收藏或转发。当然,你也可以微信搜索“阿布阿布”添加我的个人公众号,回复“爬虫1”获取源代码。

Crawler:关于爬虫的简介、安装、使用方法之详细攻略

爬虫简介

在爬取简单静态网页时,通常需要执行以下步骤:确定目标(URL链接),分析结构(链接和页面结构),制定策略(选择HTML下载器、解析器等)。爬虫工作流程涉及三个关键组件:HTML下载器负责下载网页内容,程序源码更新解析器用于提取有效数据,数据存储器用于以文件或数据库形式保存有效数据。

爬虫过程思路

首先,将数据以字典形式组织,数据内容需在代码中发送给服务器。理解反爬虫机制,识别动态值。常见反爬虫机制对动态参数进行加密,如salt、sign值。通常,动态参数的生成涉及时间戳和加密算法。可以通过检查网页源代码来分析加密方法。

策略包括:伪装浏览器,通过HTTP请求添加特定Header,如User-Agent,避免服务器识别异常访问。使用代理服务器,定期更换IP地址,防止被目标网站封锁。

关于Python实现爬虫的包

Python中常用爬虫库有requests、beautifulsoup等。requests用于网络请求,beautifulsoup用于处理HTML数据。scrapy等框架虽强大,但对于小型项目可能略显冗余。

基本函数示例

使用urllib.parse.urlencode将键值对转换为URL格式字符串,并通过encode将其转换为bytes类型,以便进行POST请求。urllib.request.urlopen用于发送请求并获取响应。response.read()读取返回数据,decode将其转换为字符串,便于后续解析。JSON处理函数json.loads将字符串转换为字典。

推荐相关文章:《使用urllib.request发送请求》

教你写爬虫用Java爬虫爬取百度搜索结果!可爬w+条!

教你写爬虫用Java爬取百度搜索结果的实战指南

在本文中,我们将学习如何利用Java编写爬虫,实现对百度搜索结果的抓取,最高可达万条数据。首先,目标是获取搜索结果中的五个关键信息:标题、原文链接、链接来源、简介和发布时间。 实现这一目标的关键技术栈包括Puppeteer(网页自动化工具)、Jsoup(浏览器元素解析器)以及Mybatis-Plus(数据存储库)。在爬取过程中,我们首先分析百度搜索结果的网页结构,通过控制台查看,发现包含所需信息的元素位于class为"result c-container xpath-log new-pmd"的div标签中。 爬虫的核心步骤包括:1)初始化浏览器并打开百度搜索页面;2)模拟用户输入搜索关键词并点击搜索;3)使用代码解析页面,获取每个搜索结果的详细信息;4)重复此过程,处理多个关键词和额外的逻辑,如随机等待、数据保存等。通过这样的通用方法,我们实现了高效的数据抓取。 总结来说,爬虫的核心就是模仿人类操作,获取网络上的数据。Puppeteer通过模拟人工点击获取信息,而我们的目标是更有效地获取并处理数据。如果你对完整源码感兴趣,可以在公众号获取包含爬虫代码、数据库脚本和网页结构分析的案例资料。Python抓取网络小说-小白零基础教程

本文介绍了如何使用Python抓取网络小说的基本流程和具体实现,以下是关键步骤和代码概览。基本思路

网络爬虫主要分为三个部分:获取目标网站的HTML源码、解析HTML内容以提取所需信息、以及利用解析结果执行特定任务,如下载内容或数据处理。使用工具与安装

主要使用Python和Pycharm进行开发。确保安装了requests、lxml等常用网络爬虫库,可通过CMD管理员命令进行安装。首页爬取与解析

选取目标网站的首页链接,通过观察网页结构,利用XPath语法定位感兴趣信息,如书名、作者、更新时间、章节等。抓取网页文本

使用requests库请求网页内容,通过添加请求头伪装成浏览器以避免反爬策略。解析获取的数据以提取所需信息。正文爬取与解析

针对章节链接,重复抓取文本内容并进行存储。优化代码以实现自动遍历所有章节链接,使用循环结构。数据清洗与文件存储

对获取的数据进行格式化处理,如去除多余空格、换行符,确保文本的整洁。将处理后的数据写入文本文件中。多线程下载

引入多线程技术提高下载效率,使用Python的线程池实现并发下载,同时处理反爬策略,增加重试机制以应对网络波动和网站限制。输出格式

除了文本输出,还介绍了EPUB格式的输出方式,提供了EPUB格式代码示例,方便用户自定义输出形式。总结与资源

本文详细阐述了使用Python进行网络小说抓取的全过程,提供了基础代码框架和优化建议。最后,提供了代码打包文件下载链接,便于实践与学习。

缅甸妙瓦底一警局遭炸弹袭击,致十余人受伤

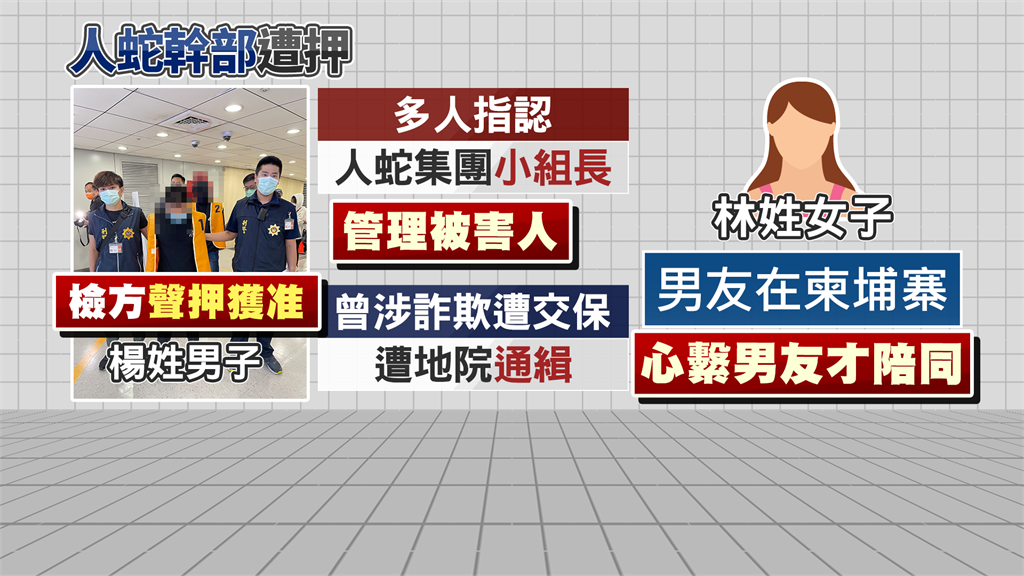

人蛇集團組長混入「柬詐被害者」返台 台商曝救回台積電前女員工

速讀今日國際財經日誌(03/02)|天下雜誌

俄軍佔札波羅熱核電廠 烏俄開戰「核災恐比車諾比嚴重數倍」

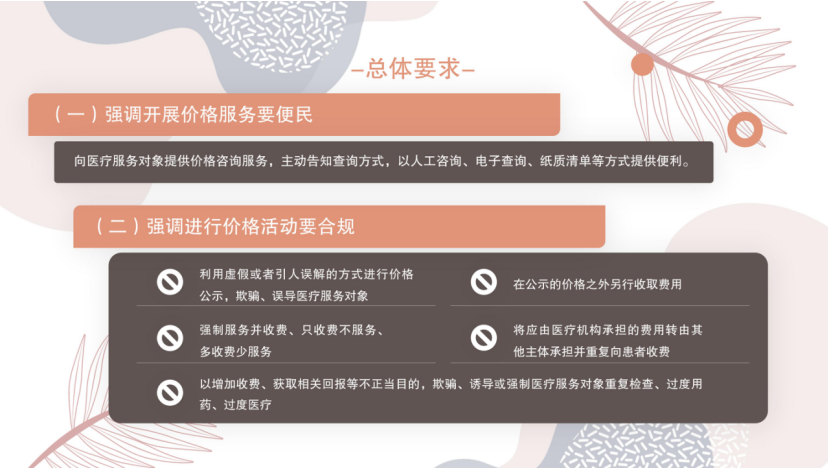

福建厦门出台医疗机构价格公示新规 重点限制5种价格活动

南京:在“世界文学之都”诗意栖居